Результат интеллектуальной деятельности: СИСТЕМЫ И СПОСОБЫ СЕГМЕНТАЦИИ ИЗОБРАЖЕНИЯ С ИСПОЛЬЗОВАНИЕМ СВЁРТОЧНОЙ НЕЙРОННОЙ СЕТИ

Вид РИД

Изобретение

Область техники, к которой относится изобретение

[001] Это изобретение относится в общем к сегментации изображения. Более конкретно, это изобретение относится к системам и способам автоматической сегментации изображения на основе нейронных сетей.

Уровень техники

[002] В радиотерапии или радиохирургии планирование лечения обычно выполняется на основании медицинских изображений пациента и требует определения целевых объемов и нормальных критических органов в медицинских изображениях. Таким образом, сегментация анатомических структур в медицинских изображениях является заранее необходимым и важным этапом для планирования лечения при радиотерапии. Точная и автоматическая компьютерная сегментация или контурная обработка анатомических структур может облегчать разработку и/или адаптацию оптимального плана лечения. Однако, точная и автоматическая сегментация медицинских изображений в настоящее время остается сложной задачей вследствие деформации и изменчивости форм, размеров, положений и т.д. целевых объемов и критических органов у различных пациентов.

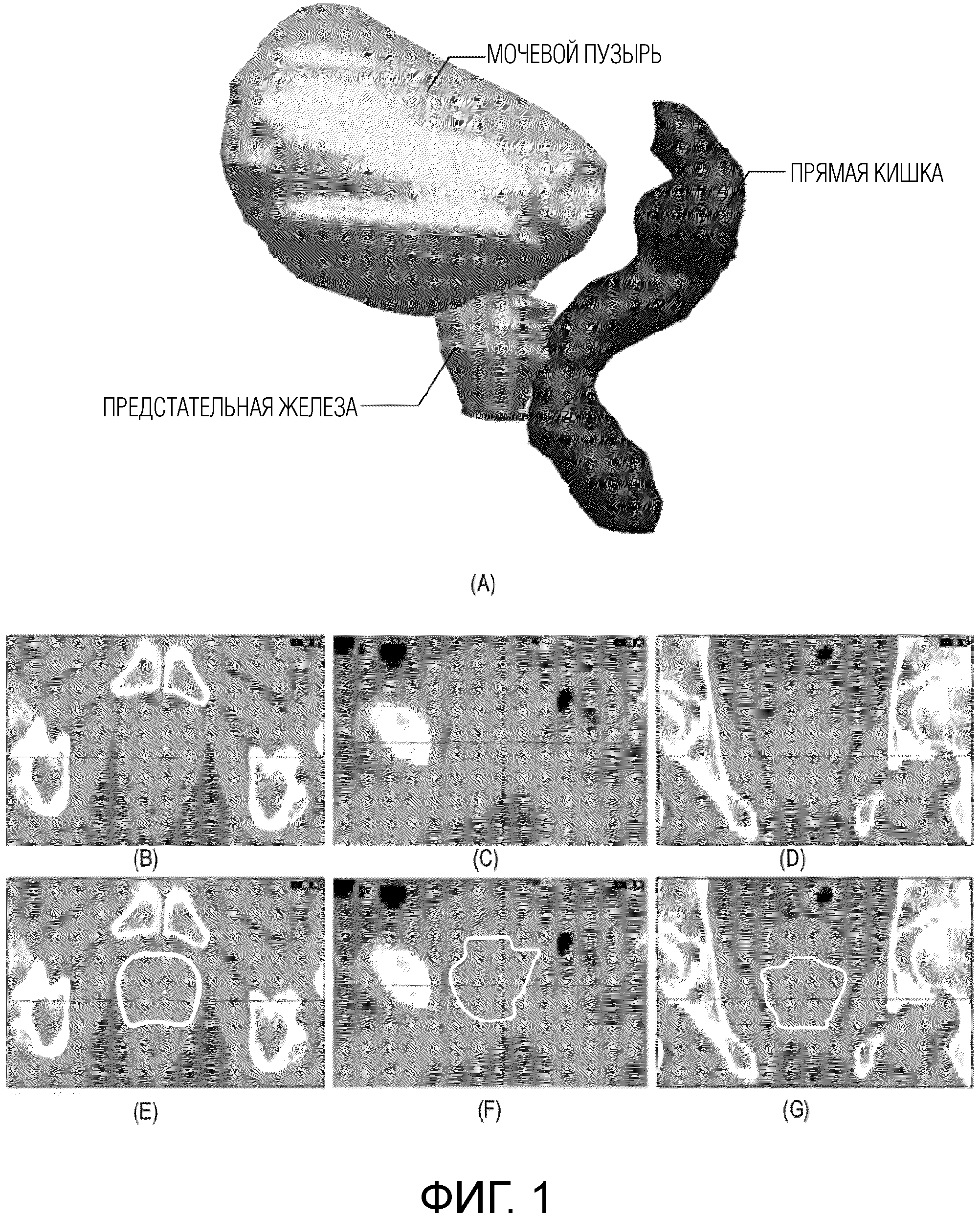

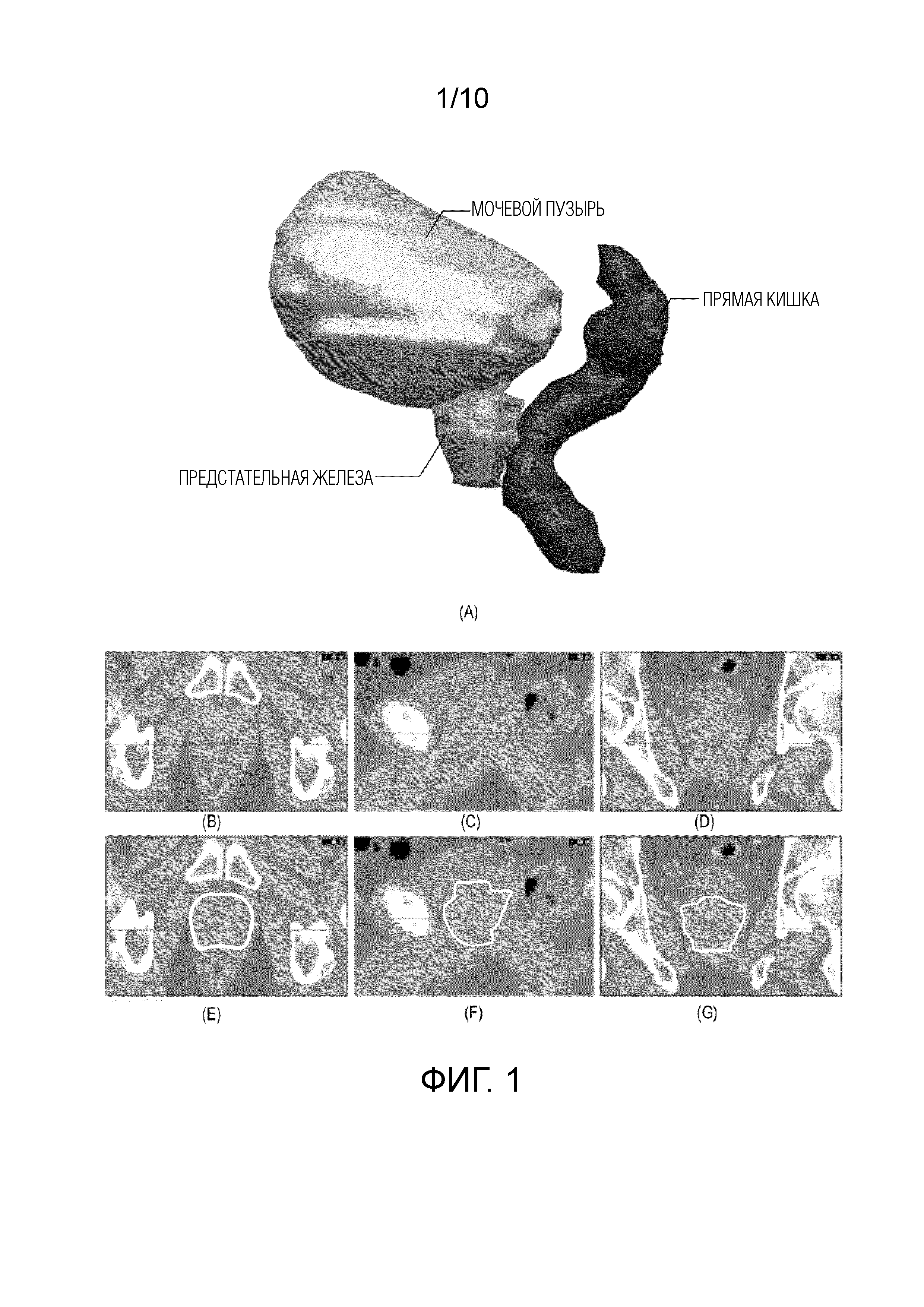

[003] Фиг. 1 иллюстрирует примерное изображение трёхмерной (3D) компьютерной томографии (CT) от примерного пациента с раком предстательной железы. Иллюстрация (A) показывает тазовую область пациента в 3D-виде, который включает в себя мочевой пузырь пациента, предстательную железу и прямую кишку. Изображения (B), (C) и (D) являются осевым, сагиттальным и фронтальным видами из 3D изображения CT этой тазовой области. Как показано в изображениях (B), (C) и (D), большая часть границы предстательной железы является невидимой. Т.е. невозможно легко различить предстательную железу среди других анатомических структур или определить контур предстательной железы. В сравнении, изображения (E), (F) и (G) показывают ожидаемый контур предстательной железы на том же 3D изображении CT. Как иллюстрировано на фиг. 1, традиционные способы сегментации изображения, исключительно основанные на контрасте и текстурах, представленных в изображении, вероятно потерпят неудачу при использовании для сегментации этого примерного 3D изображения CT. Таким образом, различные подходы предлагаются для улучшения точности автоматической сегментации медицинских изображений.

[004] Например, для разрешения проблемы контурной обработки анатомических структур в планировании лечения при радиотерапии были использованы способы автосегментации на основе атласа (ABAS). Способы ABAS создают карту контуров в новом изображении на основе ранее определенной анатомической конфигурации в эталонном изображении, т.е. атласе. Точность способов ABAS в значительной степени зависит от производительности способов регистрации атласа. Как описано выше, формы и размеры некоторых органов могут изменяться для различных пациентов и могут быть деформированы в больших масштабах на различных стадиях для одного и того же пациента, что может снижать точность регистрации и влиять на автоматическую сегментацию, выполняемую способами ABAS.

[005] Недавние разработки в технологиях машинного обучения улучшили сегментацию изображения, такую как более точная сегментация низкоконтрастных частей в изображениях или изображениях более низкого качества. Например, различные алгоритмы машинного обучения могут «обучать» машины, компьютеры или компьютерные программы прогнозированию (например, посредством оценки вероятности) каждого пиксела или воксела анатомической структуры, которую медицинское изображение представляет. Такое прогнозирование или оценка обычно использует один или более признаков медицинского изображения в качестве входных данных. Следовательно, выполнение сегментации очень зависит от типов доступных признаков. Например, метод случайного леса (RF) был с некоторым успехом использован для сегментации изображения. Модель RF может быть построена на основе извлечения различных признаков из набора обучающих образцов. Однако признаки, применяемые в способе RF, требуют ручного проектирования и являются характерными для контурной обработки одного типа органа. Разработка оптимального сочетания признаков для различных применений сегментации является трудоемким и затратным по времени процессом.

[006] Соответственно, существует необходимость в новых способах автоматической сегментации для улучшения характеристик сегментации на медицинских изображениях в лучевой терапии или связанных с ней областях.

Раскрытие изобретения

[007] Некоторые варианты осуществления настоящего изобретения относятся к реализуемому компьютером способу сегментации трёхмерного изображения. Способ может включать в себя прием трёхмерного изображения, полученного устройством формирования изображения, и создание первого стека двухмерных изображений из первой плоскости трёхмерного изображения и второго стека двухмерных изображений из второй плоскости трёхмерного изображения. Способ может дополнительно включать в себя сегментацию посредством процессора первого стека и второго стека двухмерных изображений с использованием по меньшей мере одной нейронно-сетевой модели. Способ может также включать в себя определение посредством процессора карты меток для трёхмерного изображения посредством агрегирования результатов сегментации из первого стека и второго стека.

[008] Некоторые варианты осуществления настоящего изобретения относятся к устройству для сегментации трёхмерного изображения. Устройство может включать в себя входной интерфейс, который принимает трёхмерное изображение, полученное устройством формирования изображения. Устройство может дополнительно включать в себя по меньшей мере одно запоминающее устройство, выполненное с возможностью хранения трёхмерного изображения. Устройство может также включать в себя процессор изображений, выполненный с возможностью создания первого стека двухмерных изображений из первой плоскости трёхмерного изображения и второго стека двухмерных изображений из второй плоскости трёхмерного изображения. Процессор изображений может быть дополнительно выполнен с возможностью сегментации первого стека и второго стека двухмерных изображений с использованием по меньшей мере одной нейронно-сетевой модели. Процессор изображений может также быть выполнен с возможностью определения карты меток для трёхмерного изображения посредством агрегирования результатов сегментации из первого стека и второго стека.

[009] Некоторые варианты осуществления настоящего изобретения относятся к постоянному машиночитаемому носителю, хранящему машиноисполняемые инструкции. При исполнении по меньшей мере одним процессором машиноисполняемые инструкции могут предписывать по меньшей мере одному процессору выполнять способ сегментации трёхмерного изображения. Способ может включать в себя прием трёхмерного изображения, полученного устройством формирования изображения, и создание первого стека двухмерных изображений из первой плоскости трёхмерного изображения и второго стека двухмерных изображений из второй плоскости трёхмерного изображения. Способ может дополнительно включать в себя сегментацию посредством процессора первого стека и второго стека двухмерных изображений с использованием по меньшей мере одной нейронно-сетевой модели. Способ может также включать в себя определение посредством процессора карты меток для трёхмерного изображения посредством агрегирования результатов сегментации из первого стека и второго стека.

[010] Другие задачи и преимущества настоящего изобретения будут частично изложены в нижеследующем подробном описании, и частично будут очевидны из описания или могут быть обнаружены при практическом использовании настоящего изобретения. Задачи и преимущества настоящего изобретения будут реализованы и получены посредством элементов и комбинаций, конкретно указанных в прилагаемой формуле изобретения.

[011] Следует понимать, что вышеприведенное общее описание и нижеследующее подробное описание являются лишь примерными и пояснительными, а не ограничивающими заявляемое изобретение.

Краткое описание чертежей

[012] Сопровождающие чертежи, которые составляют часть данного описания, иллюстрируют несколько вариантов осуществления и вместе с описанием служат для пояснения раскрытых принципов.

[013] Фиг. 1 иллюстрирует примерное трёхмерное изображение CT от примерного пациента с раком предстательной железы.

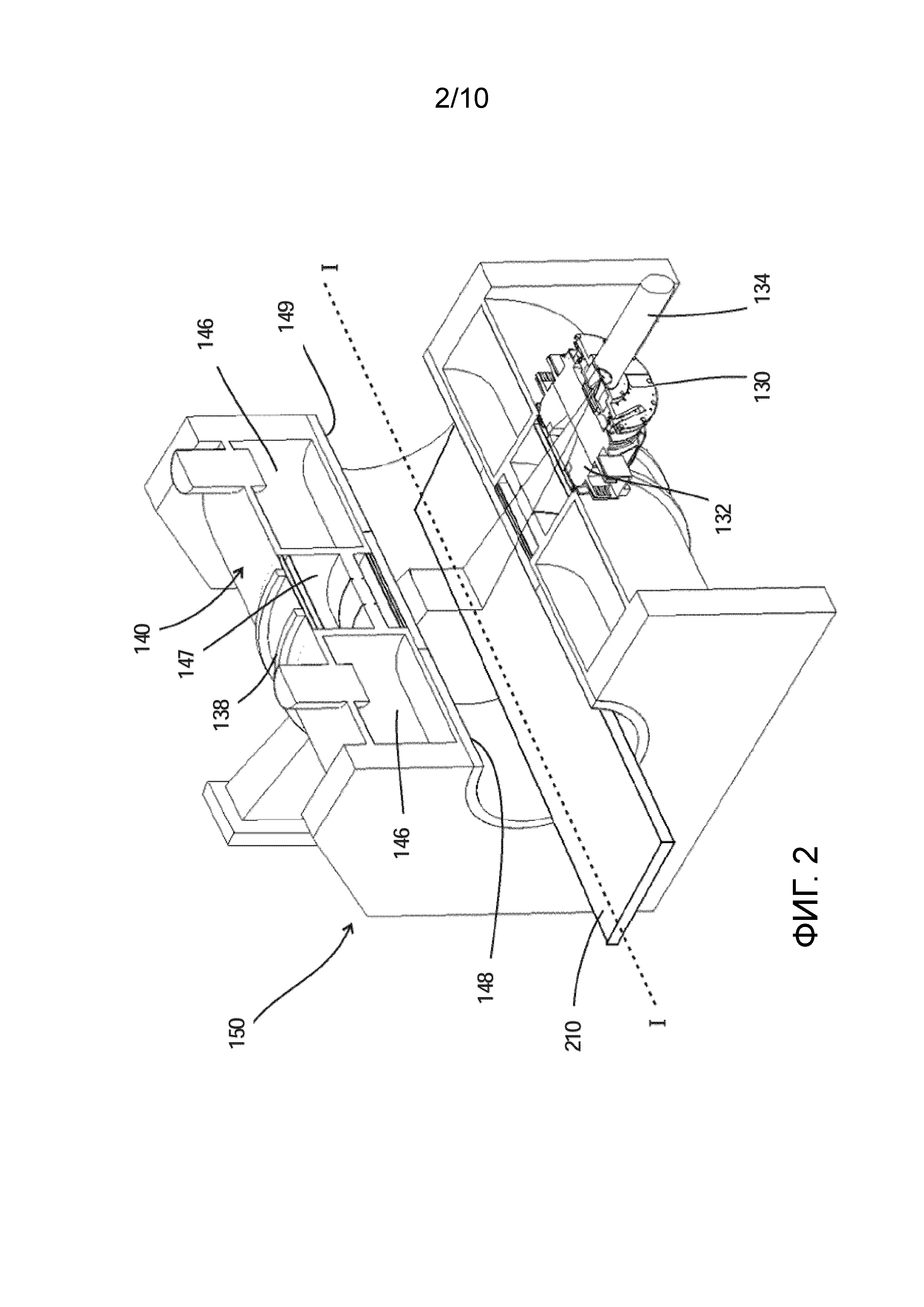

[014] Фиг. 2 иллюстрирует примерное управляемое с помощью изображений устройство радиотерапии согласно некоторым вариантам осуществления настоящего изобретения.

[015] Фиг. 3 иллюстрирует примерную модель сверточной нейронной сети (CNN) для сегментации изображения, согласно некоторым вариантам осуществления настоящего изобретения.

[016] Фиг. 4 иллюстрирует примерную систему сегментации изображения для сегментации 3D-изображений согласно некоторым вариантам осуществления настоящего изобретения.

[017] Фиг. 5 иллюстрирует примерное устройство обработки изображений для сегментации 3D-изображений согласно некоторым вариантам осуществления настоящего изобретения.

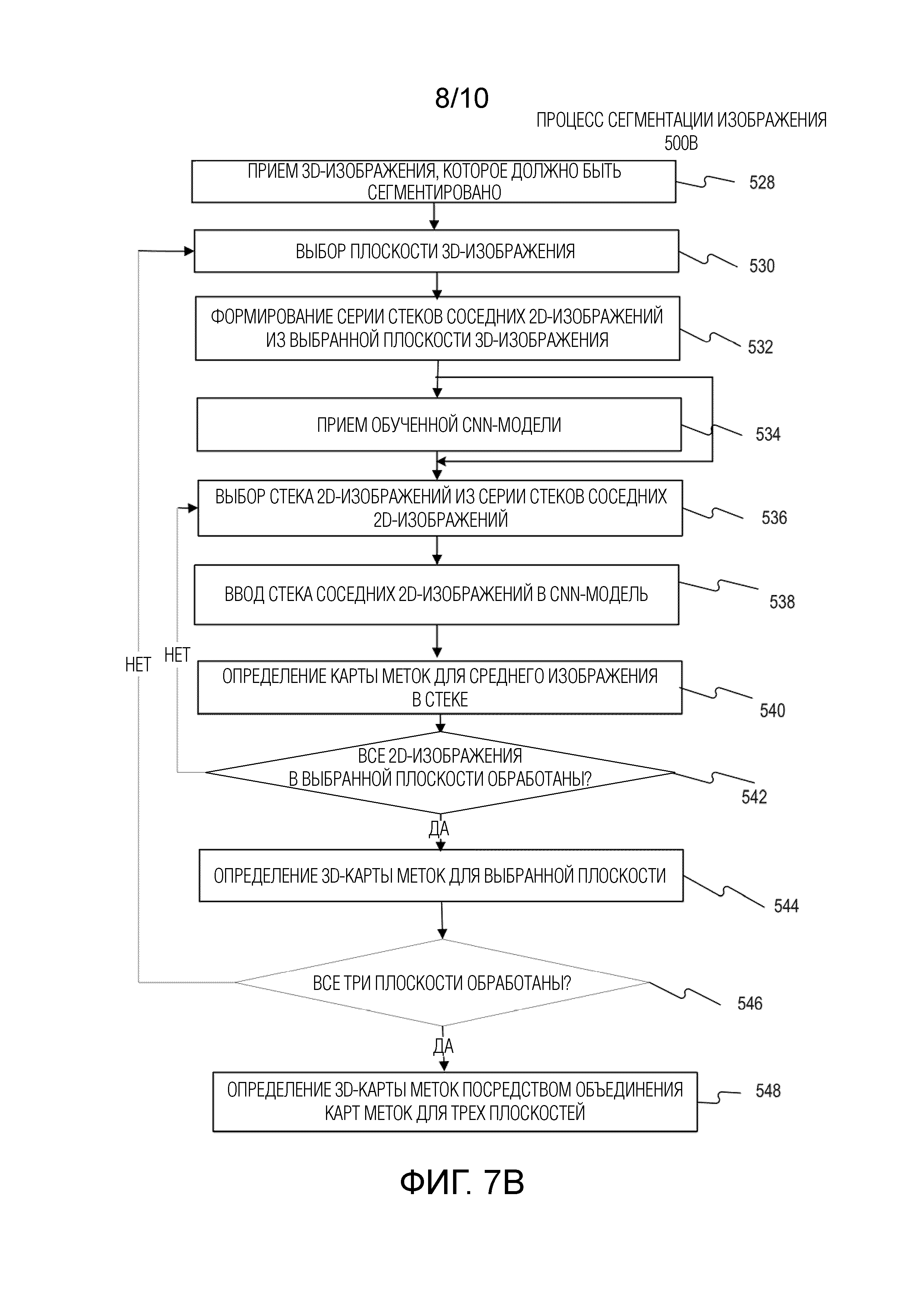

[018] Фиг. 6 - это блок-схема, иллюстрирующая примерный процесс обучения для обучения модели CNN, согласно некоторым вариантам осуществления настоящего изобретения.

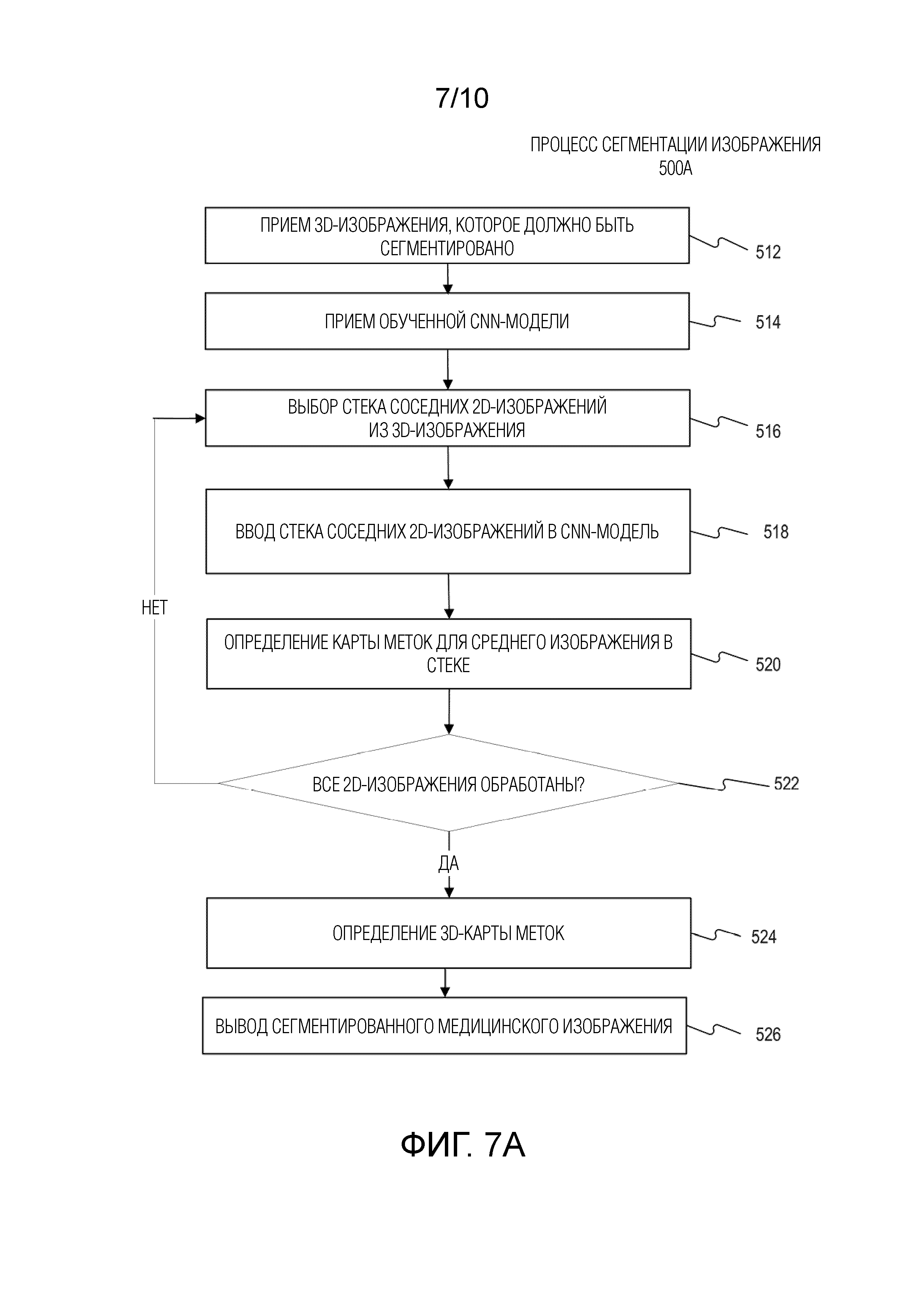

[019] Фиг. 7A - это блок-схема, иллюстрирующая примерный процесс сегментации изображения с использованием обученной модели CNN, полученной посредством процесса на фиг. 6, согласно некоторым вариантам осуществления настоящего изобретения.

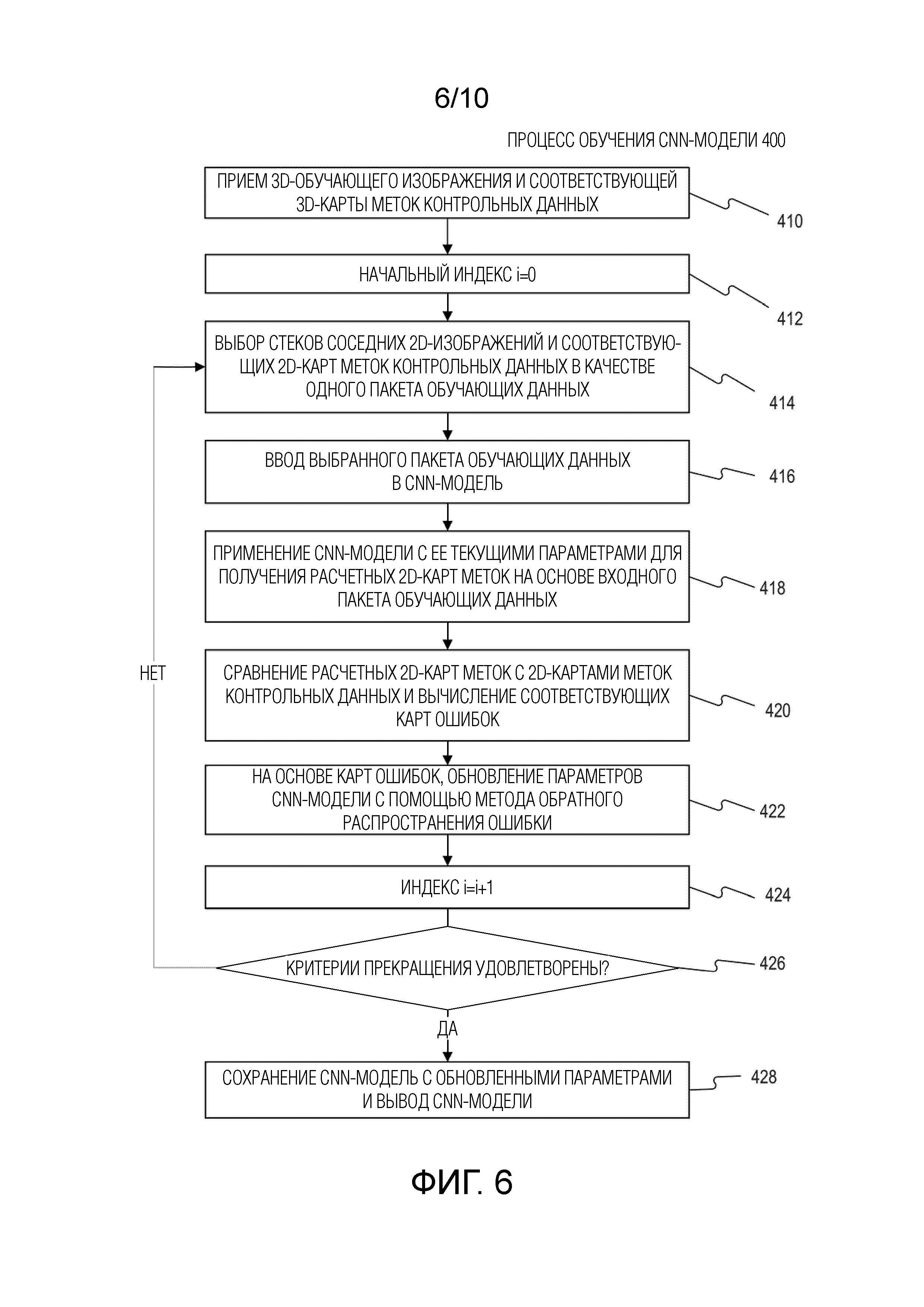

[020] Фиг. 7B - это блок-схема, иллюстрирующая другой примерный процесс сегментации изображения с использованием по меньшей мере одной обученной модели CNN, полученной посредством процесса на фиг. 6, согласно некоторым вариантам осуществления настоящего изобретения.

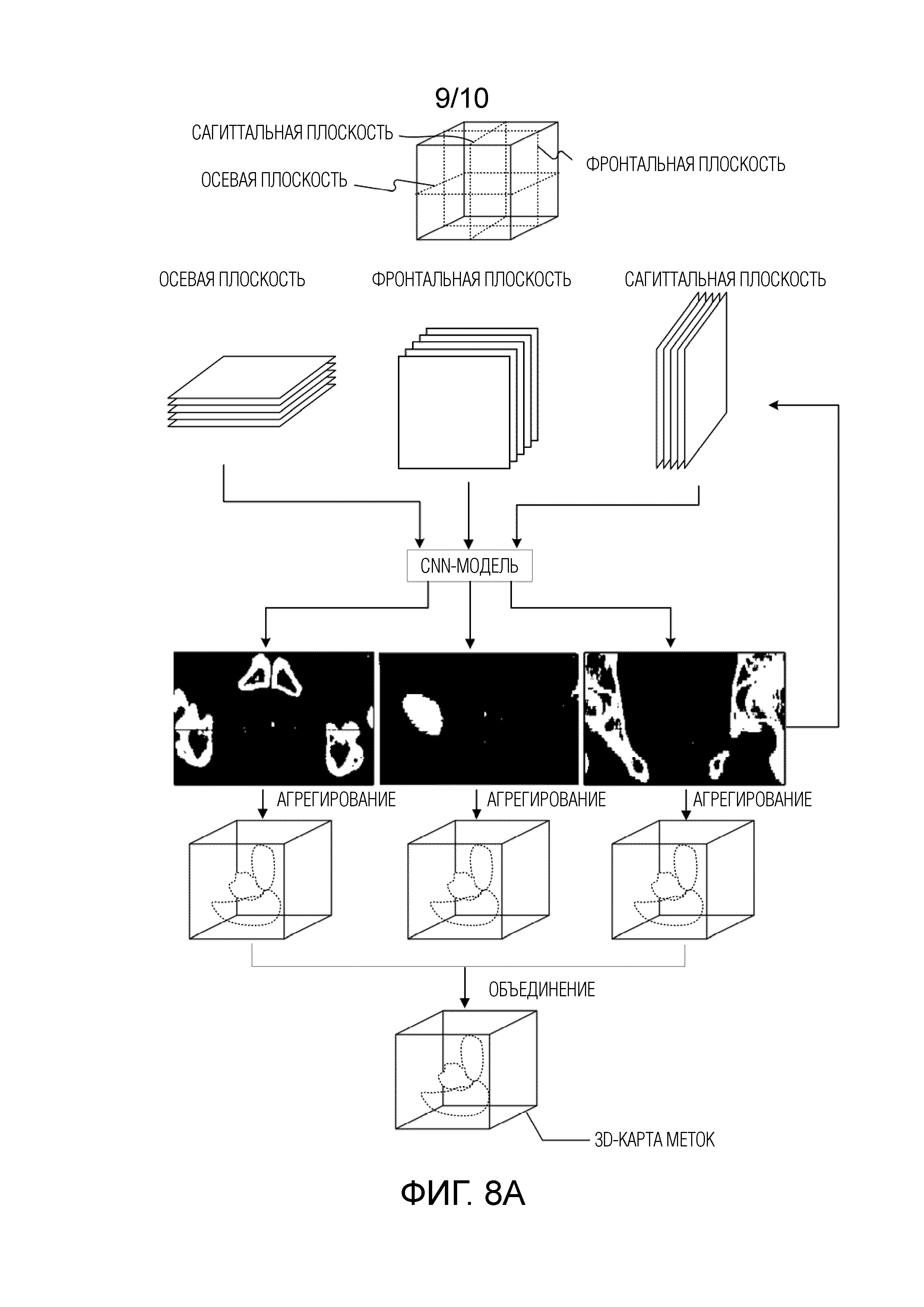

[021] Фиг. 8A иллюстрирует первый примерный процесс сегментации изображения медицинского 3D-изображения согласно некоторым вариантам осуществления настоящего изобретения.

[022] Фиг. 8B иллюстрирует второй примерный процесс сегментации изображения медицинского 3D-изображения, согласно некоторым вариантам осуществления настоящего изобретения.

Осуществление изобретения

[023] Системы, способы, устройства и процессы в соответствии с настоящим изобретением направлены на сегментацию 3D-изображения с использованием способов сегментации изображения на основе алгоритмов машинного обучения. Предпочтительно примерные варианты осуществления позволяют повысить точность и надежность сегментации 3D-изображения с использованием зависимой структурной информации о стеках смежных 2D-изображений, полученных из 3D-изображения.

[024] В контексте данного документа «медицинское 3D-изображение» или «3D-изображение», которое необходимо сегментировать или использовать в качестве обучающих данных, может означать массив данных 3D-изображения, полученный посредством любого типа методик формирования изображений, таких как CT, магнитно-резонансная визуализация (MRI), функциональная MRI (например, fMRI, DCE-MRI и диффузионная MRI), компьютерная томография с коническим лучом (CBCT), спиральная CT, позитронно-эмиссионная томография, флюоресцентная визуализация, ультразвуковая визуализация и портальная визуализация в радиотерапии и т.д. Кроме того, в контексте данного документа «алгоритм машинного обучения» означает любой алгоритм, который может обучать модель или шаблон на основании существующей информации или знания и прогнозировать или оценивать выходную информацию с использованием ввода новой информации или знания.

[025] Контролируемое обучение является ответвлением машинного обучения, которое выводит прогнозирующую модель при наличии набора обучающих данных. Каждый отдельный образец обучающих данных является парой, составляющей массив данных (например, изображение) и желаемое выходное значение или массив данных. Алгоритм контролируемого обучения анализирует обучающие данные и создает функцию прогнозирования. Функция прогнозирования, полученная посредством обучения, способна обоснованно прогнозировать или оценивать корректное выходное значение или массив данных для действительных входных данных. Функция прогнозирования может быть сформулирована на основе различных моделей машинного обучения, алгоритмов и/или процессов.

[026] Сверточная нейронная сеть (CNN) является типом алгоритма машинного обучения, который может быть обучен посредством контролируемого обучения. Архитектура модели CNN включает в себя стек четко выраженных слоев, которые преобразуют входные данные в выходные данные. Примеры различных слоев могут включать в себя один или более сверточных слоев, слоев линейного оператора (таких как функции блоков линейной ректификации (ReLu), сигмоидальные функции или гиперболические тангенсные функции), слои объединения в пул или субдискретизации, полностью соединенные слои и/или окончательные слои потерь. Каждый слой может соединять один вышестоящий слой и один нижерасположенный слой. Входные данные могут рассматриваться в качестве входного слоя, а выходные данные могут рассматриваться в качестве окончательного выходного слоя.

[027] Чтобы увеличивать производительность и способности обучения CNN-моделей, число различных слоев может быть выборочно увеличено. Число промежуточных отдельных слоев от входного слоя до выходного слоя может становиться очень большим, тем самым, увеличивая сложность архитектуры модели CNN. модели CNN с большим числом промежуточных слоев называются глубокими CNN-моделями. Например, некоторые глубокие модели CNN могут включать в себя более 20-30 слоев, а другие глубокие модели CNN могут даже включать в себя более нескольких сотен слоев. Примеры глубоких CNN-моделей включают в себя AlexNet, VGGNet, GoogleNet, ResNet и т.д.

[028] Настоящее описание применяет мощные способности обучения CNN-моделей, и, в частности, глубоких CNN-моделей, для сегментации анатомических структур 3D-изображений. В соответствии с раскрытыми вариантами осуществления, сегментация 3D-изображения выполняется с использованием обученной модели CNN, чтобы помечать каждый воксел входного 3D-изображения с анатомической структурой. Предпочтительно модель CNN для сегментации изображения в вариантах осуществления настоящего изобретения позволяет автоматически сегментировать анатомические структуры без необходимости ручного извлечения признаков.

[029] В контексте данного документа модель CNN, используемая раскрытым способом сегментации, может означать любую нейронно-сетевую модель, сформулированную, приспособленную или модифицированную на основе инфраструктуры традиционной нейронной сети. Например, модель CNN, используемая для сегментации в вариантах осуществления настоящего изобретения, может выборочно включать в себя промежуточные слои между входным и выходным слоями, такие как один или более слоев развертки, слои повышающей дискретизации или повышающего объединения в пул, слои попиксельного прогнозирования и/или слои оператора копирования и вырезания.

[030] Раскрытые способы сегментации изображения, системы, устройства и процессы в общем включают в себя две стадии: стадию обучения, которая «обучает» или «учит» модель CNN с использованием обучающих массивов данных, которые включают в себя 3D-изображения, маркированные различными анатомическими структурами для каждого воксела, и стадию сегментации, которая использует обученную модель CNN, чтобы прогнозировать анатомическую структуру каждого воксела входного 3D-изображения и/или маркировать каждый воксел входного 3D-изображения анатомической структурой.

[031] В контексте данного документа «обучение» модели CNN означает определение одного или более параметров по меньшей мере одного слоя в модели CNN. Например, сверточный слой модели CNN может включать в себя по меньшей мере один фильтр или ядро. Один или более параметров, таких как весовые коэффициенты ядра, размер, форма и структура по меньшей мере одного фильтра могут быть определены, например, посредством процесса обучения на основе обратного распространения ошибки.

[032] В соответствии с раскрытыми вариантами осуществления, для обучения модель CNN процесс обучения использует по меньшей мере один набор обучающих изображений. Каждый набор обучающих изображений может включать в себя 3D-изображение и соответствующую ему 3D-карту меток контрольных данных, которая ассоциирует анатомическую структуру с каждым из вокселов 3D-изображения. В качестве неограничивающего примера, 3D-изображение может быть разделено на последовательные стеки смежных 2D-изображений, и 3D-карта меток контрольных данных состоит из последовательных 2D-карт меток контрольных данных, соответственно связанных с последовательными стеками смежных 2D-изображений. В контексте данного документа обучающее изображение является уже сегментированным изображением, а карта меток контрольных данных обеспечивает метку известной анатомической структуры для каждого пиксела репрезентативного слоя изображения для обучающего изображения. Другими словами, пикселы карты меток контрольных данных ассоциированы с известными анатомическими структурами. Если стек смежных 2D-изображений включает в себя нечетное число изображений, карта меток контрольных данных обеспечивает метки структур среднего изображения стека. В качестве альтернативы, если стек смежных 2D-изображений включает в себя четное число изображений, карта меток контрольных данных обеспечивает метки структур одного из двух средних изображений стека.

[033] В соответствии с раскрытыми вариантами осуществления, стек смежных 2D-изображений является смежными срезами 2D-изображения вдоль выбранной анатомической плоскости, такой как осевая плоскость, сагиттальная плоскость или фронтальная плоскость. Таким образом, анатомические структуры в смежных 2D-изображениях являются пространственно зависимыми, коррелирующими или непрерывными вдоль оси, ортогональной анатомической плоскости. Преимущественно, такая зависимая структурная информация между смежными 2D-изображениями используется в раскрытых способах сегментации изображения для повышения надежности и точности результатов сегментации медицинских 3D-изображений.

[034] В соответствии с раскрытыми вариантами осуществления, стеки смежных 2D-изображений вдоль различных анатомических плоскостей используются для обучения различных CNN-моделей. В качестве неограничивающего примера, три различных набора обучающих изображений, каждый из которых включает в себя набор стеков смежных 2D-изображений вдоль анатомической плоскости, такой как осевая плоскость, сагиттальная плоскость и фронтальная плоскость, используются для обучения трех CNN-моделей, соответственно. Каждая обученная модель CNN может быть использована для сегментации 3D-изображения с использованием стеков смежных 2D-изображений, полученных из 3D-изображения вдоль соответствующей анатомической плоскости. В качестве альтернативы, стеки смежных 2D-изображений вдоль трех различных анатомических плоскостей объединяются для обучения одной модели CNN. Обученная модель CNN может быть использована для сегментации 3D-изображения с использованием стеков смежных 2D-изображений, полученных из 3D-изображения вдоль какой-либо из трех анатомических плоскостей.

[035] В соответствии с раскрытыми вариантами осуществления по меньшей мере одна обученная модель CNN используется для сегментации 3D-изображения. В качестве неограничивающего примера, 3D-изображение может быть разделено или представлено в форме множества смежных 2D-изображений. Например, серия стеков смежных 2D-изображений вдоль анатомической плоскости может быть получена из 3D-изображения, которое должно быть сегментировано. Серия стеков смежных 2D-изображений может быть последовательной и иметь одно или более перекрывающихся изображений, так что средние изображения стеков вместе практически составляют все 3D-изображение. Каждый стек в серии вводится в обученную модель CNN, чтобы определять 2D-выходную карту меток для среднего изображения в стеке. На основе 2D-карт меток для средних изображений стеков смежных 2D-изображений может быть определена 3D-карта меток. В качестве неограничивающего примера 3D-карта меток может быть получена посредством агрегирования 2D-карт меток для средних изображений согласно последовательности средних изображений вдоль оси, ортогональной анатомической плоскости стеков смежных 2D-изображений.

[036] Как описано выше, серия стеков смежных 2D-изображений вдоль различных анатомических плоскостей, таких как осевая плоскость, сагиттальная плоскость или фронтальная плоскость, может быть получена из 3D-изображения. В таких случаях, три 3D-карты меток могут быть определены на основе трех серий стеков смежных 2D-изображений для трех анатомических плоскостей, соответственно. В качестве неограничивающего примера, три 3D-карты меток могут быть определены посредством трех различных обученных CNN-моделей с использованием трех серий стеков смежных 2D-изображений для трех различных анатомических плоскостей, соответственно. В качестве другого неограничивающего примера, три 3D-карты меток могут быть определены посредством одной обученной модели CNN с использованием трех серий стеков смежных 2D-изображений для трех различных анатомических плоскостей, соответственно. Три определенные 3D-карты меток могут быть объединены, чтобы определять конечную 3D-карту меток 3D-изображения.

[037] В соответствии с раскрытыми вариантами осуществления, определенная 3D-карта меток ассоциирует анатомическую структуру с каждым вокселом 3D-изображения. В качестве неограничивающего примера, 3D-карта меток прогнозирует анатомическую структуру, которую представляет каждый воксел 3D-изображения.

[038] Раскрытые системы сегментации изображения, способы, устройства и процессы могут применяться для сегментации 3D-изображений, полученных из любого типа методик формирования изображения, включающих в себя, но не только, рентген, CT, CBCT, спиральную CT, MRI, функциональную MRI (например, fMRI, DCE-MRI и диффузионную MRI), PET, SPECT, оптическую томографию, флюоресцентное формирование изображений, ультразвуковое формирование изображений и портальное формирование изображений в радиотерапии, и т.д. Кроме того, раскрытые системы сегментации изображения, способы, устройства и процессы могут быть использованы, чтобы сегментировать 2D и 3D-изображения.

[039] В соответствии с некоторыми вариантами осуществления, описанные системы сегментации изображения могут быть частью устройства радиотерапии, как описано со ссылкой на фиг. 2. Фиг. 2 иллюстрирует примерное управляемое с помощью изображений устройство 150 радиотерапии согласно некоторым вариантам осуществления настоящего изобретения. Устройство 150 включает в себя кушетку 210, блок получения изображения, соответствующий устройству 140 получения изображения, и блок введения излучения, соответствующий устройству 130 радиотерапии.

[040] Кушетка 210 может быть использована для поддержания пациента (не показан) во время сеанса лечения и может также называться системой поддержания пациента. Кушетка 210 может быть подвижной по горизонтальной оси переноса (обозначенной "I"), так что пациент, лежащий на кушетке 210, может перемещаться в устройство 150 и/или из него. В некоторых вариантах осуществления кушетка 210 может быть поворачиваемой вокруг центральной вертикальной оси вращения, поперечной оси переноса. Кушетка 210 может иметь электропривод для перемещения в различных направлениях и вращения вдоль различных осей, чтобы правильно разместить пациента согласно плану лечения.

[041] Устройство 140 получения изображения может включать в себя MRI-машину, используемую для получения 2D или 3D MRI-изображений пациента перед, во время и/или после сеанса лечения. Устройство 140 получения изображения может включать в себя магнит 146 для формирования первичного магнитного поля для магнитно-резонансного формирования изображения. Линии магнитного поля, сформированные посредством действия магнита 146, могут проходить практически параллельно центральной оси I переноса. Магнит 146 может включать в себя одну или более катушек с осью, которая проходит параллельно оси I переноса. В некоторых вариантах осуществления одна или более катушек в магните 146 могут быть расположены так, что центральное окно 147 магнита 146 является свободным от катушек. В других вариантах осуществления катушки в магните 146 могут быть достаточно тонкими или уменьшенной плотности, так что они являются практически прозрачными для излучения длины волны, формируемой устройством 130 радиотерапии. Устройство 140 получения изображения может также включать в себя одну или более активных экранирующих катушек, которые могут формировать магнит 146 снаружи магнитного поля приблизительно равной величины и противоположной полярности, чтобы нейтрализовать магнитное поле снаружи магнит 146. Устройство 134 излучения устройства 130 радиотерапии может быть расположено в области, где магнитное поле нейтрализуется по меньшей мере до первого порядка.

[042] Устройство 140 получения изображения может также включать в себя две градиентные катушки 148 и 149, которые могут формировать градиентное магнитное поле, которое накладывается на основное магнитное поле. Катушки 148 и 149 могут формировать градиент в результирующем магнитном поле, что обеспечивает возможность пространственного кодирования протонов, так что их положение может быть определено. Градиентные катушки 148 и 149 могут быть расположены вокруг общей центральной оси с магнитом 146 и могут быть смещены друг от друга вдоль этой центральной оси. Смещение может создавать зазор, или окно, между катушками 148 и 149. В вариантах осуществления, в которых магнит 146 также включает в себя центральное окно 147 между катушками, два окна могут быть совмещены друг с другом.

[043] Предполагается, что устройство 140 получения изображения может быть устройством формирования изображения, отличным от MRI, таким как рентген, CT, CBCT, пространственная CT, PET, SPECT, оптическая томография, флюоресцентная визуализация, ультразвуковая визуализация и устройство портальной визуализации в радиотерапии, и т.д.

[044] Устройство 130 радиотерапии может включать в себя источник излучения 134, такой как источник рентгеновского излучения или линейный акселератор, и многолепестковый коллиматор (MLC) 132. Устройство 130 радиотерапии может быть установлено на шасси 138. Шасси 138 может быть непрерывно вращаемым вокруг кушетки 210, когда она введена в область лечения, и приводится в действие мощностью от одного или более моторов шасси. Датчик излучения может также быть установлен на шасси 138 при желании, предпочтительно напротив источника 134 излучения и с осью вращения шасси 138, расположенной между источником 134 излучения и датчиком. Схема управления устройства 130 радиотерапии может быть объединена в устройство 150 или располагаться удаленно от него.

[045] Во время сеанса радиотерапевтического лечения пациент может быть расположен на кушетке 210, которая может быть введена в область лечения, определенную магнитными катушками 146, 148, 149 и шасси 138. Консоль 110 управления может управлять источником 134 излучения, MLC 132 и мотором(ами) шасси для введения излучения пациенту через окно между катушками 148 и 149.

модель CNN для сегментации 3D-изображения

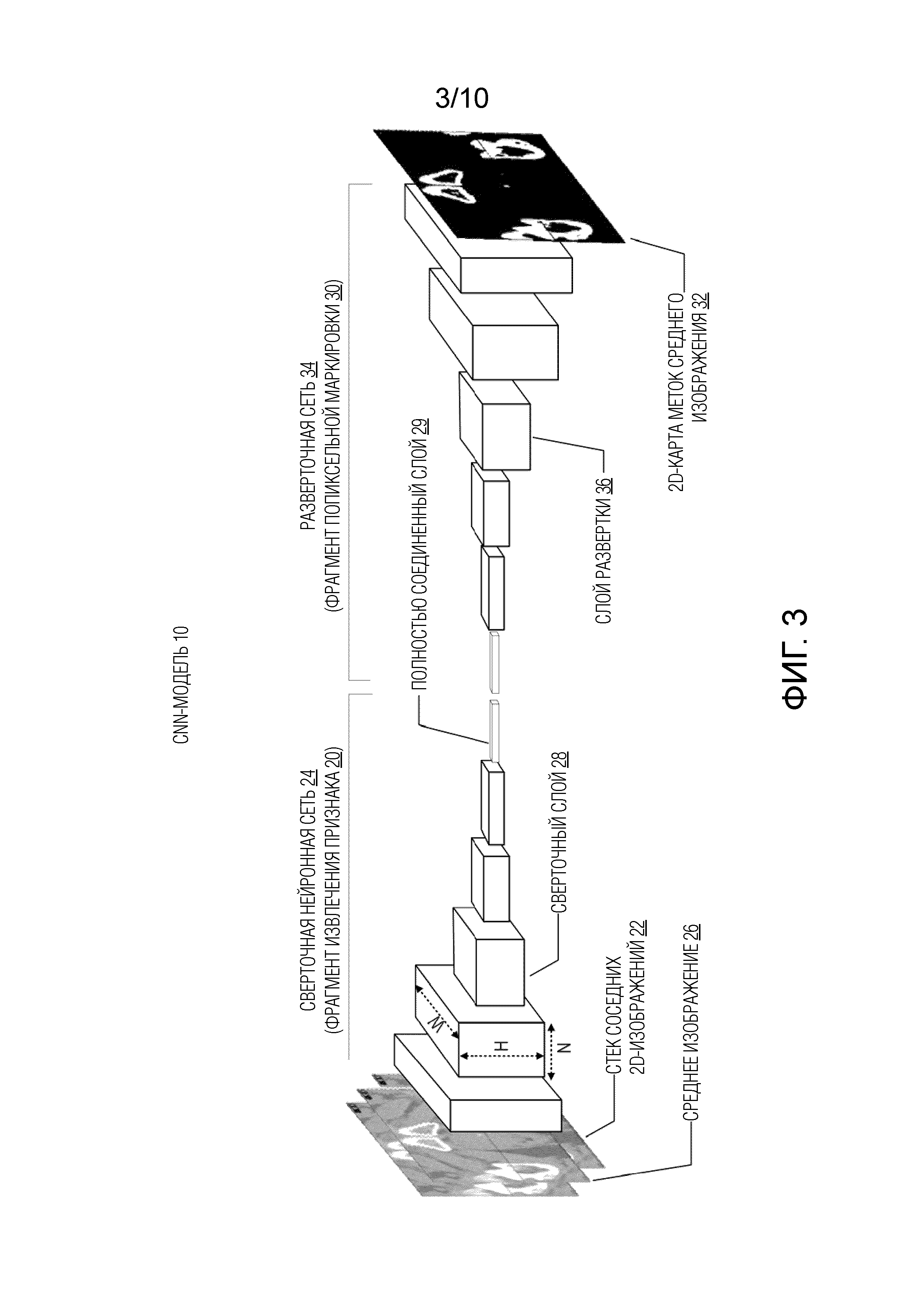

[046] Фиг. 3 иллюстрирует примерную модель CNN для сегментации изображения, согласно некоторым вариантам осуществления настоящего изобретения. Как показано на фиг. 3, модель CNN для сегментации изображения может принимать стек смежных 2D-изображений в качестве входных данных и выводит спрогнозированную 2D-карту меток для одного из изображений в середине стека. Как описано выше, если стек смежных 2D-изображений включает в себя нечетное число изображений, 2D-карта меток обеспечивает метки структур для среднего изображения стека. В качестве альтернативы, если стек смежных 2D-изображений включает в себя четное число изображений, 2D-карта меток обеспечивает метки структур одного из двух средних изображений стека.

[047] Как показано на фиг. 3, модель 10 CNN может в общем включать в себя два блока: первый блок 20 извлечения признака и второй блок 30 попиксельной маркировки. Блок 20 извлечения признака может извлекать один или более признаков входного стека смежных 2D-изображений 22. Блок извлечения признака использует сверточную нейронную сеть 24 для приема входного стека смежных 2D-изображений 22 и вывода по меньшей мере одного вектора признаков или матрицы, представляющей признаки входного стека. Блок 30 попиксельной маркировки использует выходные данные блока 20 извлечения признака, чтобы прогнозировать 2D-карту 32 меток среднего изображения 26 входного стека смежных 2D-изображений 22. Блок 30 попиксельной маркировки может быть выполнен с использованием любого подходящего подхода, такого как фрагментарный подход и подход полного сопоставления, как описано подробно дополнительно ниже.

[048] Преимущественно, использование стека смежных 2D-изображений, которые содержат зависимую структурную информацию как для обучения, так и в качестве входной информации для модели 10 CNN, повышает точность прогнозирования выходной 2D-карты 32 меток посредством модели 10 CNN. Это дополнительно повышает точность прогнозируемой 3D-карты меток для 3D-изображения, построенного из 2D-карт меток, спрогнозированных для каждого слоя изображения для 3D-изображения.

[049] Когда используется в данном документе, зависимая структурная информация может ссылаться на пространственно зависимое соотношение между анатомическими структурами, показанными в стеке смежных 2D-изображений вдоль оси, ортогональной анатомической плоскости 2D-изображений. В качестве неограничивающего примера, форма и тип анатомической структуры, представленной первым набором пикселов в первом изображении стека, могут также быть представлены вторым набором пикселов во втором изображении, смежном с первым изображением. Это обусловлено тем, что пространственное соседство первого и второго изображений вдоль оси, ортогональной анатомической плоскости, обеспечивает возможность некоторой зависимости или непрерывности анатомических структур, показанных в этих изображениях. Следовательно, форма, размер и/или тип анатомической структуры в одном изображении может обеспечивать информацию о форме, размере и/или типе анатомической структуры в другом смежном изображении вдоль той же плоскости.

[050] В качестве другого неограничивающего примера, когда стек смежных 2D-изображений включает в себя три последовательных изображения, например, первый, второй и третий слои изображения, уложенные друг на друга последовательно, анатомическая структура может быть показана как в первом наборе пикселов в первом слое изображения из стека, так и в третьем наборе пикселов в третьем слое изображения стека, но не в соответствующем втором наборе пикселов (например, пикселов, имеющих аналогичные пространственные местоположения, что и местоположения первого и/или третьего набора пикселов) второго слоя изображения, который находится между и рядом с первым и третьим слоями изображения. В таких случаях, соответствующие пикселы во втором слое изображения могут быть некорректно промаркированы. Такое нарушение непрерывности анатомической структуры в стеке из трех смежных слоев 2D-изображений может быть использовано в качестве зависимой структурной информации для обучения модели 10 CNN.

[051] В качестве другого неограничивающего примера, в стеке из трех смежных 2D-изображений, например, первого, второго и третьего слоев изображения, уложенных друг на друга в последовательности, первый набор пикселов в первом срезе изображения из стека и третий набор пикселов в третьем слое изображения могут указывать фон, но соответствующий второй набор пикселов второго слоя изображения между и рядом с первым и третьим слоями изображения может указывать анатомическую структуру. Соответствующие пикселы во втором слое изображения могут быть подвержены шуму, который формирует ложноположительный сигнал. Такое нарушение непрерывности фона в стеке из трех смежных слоев 2D-изображений может также быть использовано в качестве зависимой структурной информации для обучения модели 10 CNN.

[052] Различные типы зависимой структурной информации могут быть выборочно использованы на основе различных факторов, таких как число смежных изображений в стеке, типы, формы, размеры, положения и/или количества анатомических структур, которые должны быть сегментированы, и/или методика формирования изображения, используемая для получения изображений. Как описано выше, использование такой зависимой структурной информации стеков смежных 2D-изображений, полученных из 3D-изображения, улучшает точность сегментации 3D-изображения или формирования 3D-карты меток.

[053] Различные компоненты и признаки модели 10 CNN, используемые в вариантах осуществления настоящего изобретения, подробно описаны ниже.

Сверточная нейронная сеть для извлечения признаков

[054] В некоторых вариантах осуществления сверточная нейронная сеть 24 модели 10 CNN включает в себя входной слой, например, стек смежных 2D-изображений 22. Поскольку стек смежных 2D-изображений используется в качестве входных данных, входной слой имеет объем, чьи пространственные размеры определяются по ширине и высоте 2D-изображений, и чья глубина определяется по числу изображений в стеке. Как описано в данном документе, глубина входного слоя модели 10 CNN может быть при необходимости отрегулирована, чтобы соответствовать числу изображений во входном стеке смежных 2D-изображений 22.

[055] В некоторых вариантах осуществления, сверточная нейронная сеть 24 модели 10 CNN включает в себя один или более сверточных слоев 28. Каждый сверточный слой 28 может иметь множество параметров, таких как ширина ("W") и высота ("H"), определенные посредством верхнего входного слоя (например, размер входных данных для сверточного слоя 28), и число фильтров или ядер ("N") в слое и их размеры. Число фильтров может называться глубиной сверточного слоя. Следовательно, каждый сверточный слой 28 может быть описан с точки зрения 3D-объема, как показано на фиг. 3. Входные данные каждого сверточного слоя 28 сворачиваются с одним фильтром по всей его ширине и высоте и создают 2D-карту активации или карту признаков, соответствующую этому фильтру. Свертка выполняется для всех фильтров каждого сверточного слоя, и результирующие карты активации или карты признаков укладываются вдоль размера по глубине, формируя 3D-вывод. Выходные данные предшествующего сверточного слоя могут быть использованы в качестве входных данных для следующего сверточного слоя.

[056] В некоторых вариантах осуществления сверточная нейронная сеть 24 модели 10 CNN включает в себя один или более слоев объединения в пул (не показаны). Слой объединения в пул может быть добавлен между двумя последовательными сверточными слоями 28 в модели 10 CNN. Слой объединения в пул работает независимо на каждом глубинном срезе входных данных (например, карта активации или карта признаков из предыдущего сверточного слоя) и уменьшает свой пространственный размер посредством выполнения формы нелинейной понижающей дискретизации. Как показано на фиг. 3, функцией слоев объединения в пул является постепенное уменьшение пространственного размера извлеченных карт активации или карт признаков, чтобы уменьшать количество параметров и вычисления в сети и, следовательно, также управлять чрезмерным обучением. Число и размещение слоев объединения в пул может быть определено на основе различных факторов, таких как проект архитектуры сверточной сети, размер входных данных, размер сверточных слоев 28 и/или применение модели 10 CNN.

[057] Различные нелинейные функции могут быть использованы для реализации слоев объединения в пул. Например, может быть использовано максимальное объединение в пул. Максимальное объединение в пул может делить слой изображения входных данных на множество перекрывающихся или неперекрывающихся подобластей с заданным крупным шагом. Для каждой подобласти максимальное объединение в пул выводит максимальное значение. Эти понижает дискретизацию каждого слоя входных данных как вдоль их ширины, так и их высоты, в то в время как размер по глубине остается неизменным. Другие подходящие функции могут быть использованы для реализации слоев объединения в пул, такие как усредненное объединение в пул или даже L2-нормированное объединение в пул.

[058] В различных вариантах осуществления модель 10 CNN может выборочно включать в себя один или более дополнительных слоев в своей сверточной нейронной сети 24. В качестве неограничивающего примера, ReLu-слой (не показан) может быть выборочно добавлен после сверточного слоя, чтобы формировать промежуточную карту активации или карту признаков. ReLu-слой может увеличивать нелинейные свойства функции прогнозирования и всей модели 10 CNN без влияния на соответствующие размеры сверточных слоев 28. Кроме того, ReLu-слой может уменьшать или устранять насыщение во время процесса обучения с обратным распространением ошибки.

[059] В качестве другого неограничивающего примера, один или более полностью соединенных слоев 29 могут быть добавлены после сверточных слоев и/или слоев объединения в пул. Полностью соединенные слои имеют полное соединение со всеми картами активации или картами признаков предыдущего слоя. Например, полностью соединенный слой может брать выходные данные последнего сверточного слоя или последнего слоя объединения в пул в качестве входных данных в векторной форме и выполнять высокоуровневое определение и вывод вектора признаков, размещенных вдоль размера глубины. Выходной вектор может называться выходным слоем. Вектор может содержать информацию анатомических структур во входном стеке изображений 22 модели 10 CNN.

[060] В качестве дополнительного неограничивающего примера, слой потерь (не показан) может быть включен в модель 10 CNN. Слой потери может быть последним слоем в сверточной нейронной сети 24 или модели 10 CNN. Во время обучения модели 10 CNN слой потери может определять, как сетевое обучение выбраковывает отклонение между спрогнозированной 2D-картой меток и 2D-картой меток контрольных данных. Слой потерь может быть реализован посредством различных подходящих функций потерь. Например, функция Softmax может быть использована в качестве конечного слоя потерь модели 10 CNN.

Подходы попиксельной маркировки

[061] Как описано выше, во втором блоке модели 10 CNN попиксельная маркировка выполняется с использованием одного или более признаков, извлеченных посредством сверточной нейронной сети 24 в качестве входных данных для формирования спрогнозированной 2D-карты 32 меток. 2D-карта меток может обеспечивать структурные метки средних изображений стека смежных 2D-изображений.

[062] В некоторых вариантах осуществления фрагментарный подход используется для прогнозирования 2D-карты 32 меток среднего изображения 26 входного стека смежных 2D-изображений 22. Каждое изображение в стеке смежных 2D-изображений может быть аналогично разделено на перекрывающиеся или неперекрывающиеся прямоугольные участки, каждый из которых имеет центральный пиксел. Это формирует стек смежных участков 2D-изображений. Стек участков 2D-изображений может быть использован как для обучающих данных, так и входных данных для модели 10 CNN. Участки могут быть спроектированы таким образом, что центральные пикселы участков вместе составляют практически все 2D-изображение. модель 10 CNN может классифицировать центральный пиксел среднего участка каждого стека участков, например, прогнозировать анатомическую структуру, представленную центральным пикселом. Например, модель 10 CNN может прогнозировать вектор признаков центрального пиксела среднего участка в стеке, тем самым позволяя классифицировать анатомическую структуру для центрального пиксела. Такая классификация выполняется многократно до тех пор, пока все центральные пикселы средних участков всех стеков смежных участков 2D-изображений не будут классифицированы или маркированы, тем самым добиваясь сегментации среднего изображения стека смежных 2D-изображений.

[063] В вышеописанном фрагментарном подходе попиксельная маркировка среднего изображения 26 входного стека смежных 2D-изображений 22 выполняется, когда все центральные пикселы, составляющие все среднее изображение 26, классифицированы.

[064] В других вариантах осуществления подход полного составления карты используется для прогнозирования 2D-карты 32 меток среднего изображения 26 входного стека смежных 2D-изображений 22. В таких случаях, 2D-карта 32 меток среднего изображения 26 формируется в качестве выходных данных модели 10 CNN на основе входного стека смежных 2D-изображений 22. Сверточная нейронная сеть 24 в модели 10 CNN используется для извлечения карты активации или карты признаков в качестве выходных данных, которые принимаются структурой попиксельной маркировки, которая включает в себя один или более операционных слоев для прогнозирования 2D-карты меток. В таких случаях, конечный слой сверточной нейронной сети 24 может быть сверточным слоем, который выводит карту активации или карту признаков.

[065] В качестве неограничивающего примера, слой попиксельного прогнозирования (не показан) может быть добавлен в модель 10 CNN для выполнения попиксельной маркировки. Слой попиксельного прогнозирования преобразует грубую выходную карту признаков (например, вектор признаков) сверточной нейронной сети 24 в плотную (например, обеспечивающую больше информации для каждого пиксела) спрогнозированную попиксельную 2D-карту 32 меток среднего изображения 26 входного стека смежных 2D-изображений 22. Различные функции могут быть использованы для реализации слоя попиксельного прогнозирования, такие как обратная повышающая дискретизация или разъединение пула (например, билинейная или нелинейная интерполяция), и обратная свертка (развертка).

[066] В качестве неограничивающего примера, сеть 34 развертки добавлена в модель 10 CNN для выполнения попиксельной маркировки. Как показано на фиг. 3, сеть 34 развертки может быть зеркальной версией сверточной нейронной сети 24 модели 10 CNN. В противоположность сверточной нейронной сети 24, которая постепенно уменьшает пространственные размеры извлеченных карт активации или карт признаков, сеть 34 развертки укрупняет промежуточные карты активации или карты признаков с использованием выбора слоев 36 развертки и/или слоев разъединения пула (не показаны). Слой разъединения пула (например, слой повышающей дискретизации) может быть использован для размещения пикселов в карте признаков обратно в их предыдущей или первоначальное местоположение в пуле, тем самым, формируя укрупненную, однако разреженную карту активации или карту признаков. Слой развертки может быть использован, чтобы ассоциировать один пиксел входной карты активации или карты признаков во множество выходных пикселов, тем самым, укрупняя и увеличивая плотность карты активации или карты признаков. Следовательно, сеть 34 развертки может быть обучена и использована вместе со сверточной нейронной сетью 24 для прогнозирования 2D-карты меток.

[067] Как будет понятно специалистам в области техники, другие подходящие способы для выполнения попиксельной маркировки могут быть адаптированы, модифицированы и/или использованы в вариантах осуществления настоящего изобретения.

[068] В соответствии с вариантами осуществления настоящего изобретения, способы сегментации изображения, системы, устройства и/или процессы на основе вышеописанных моделей CNN включают в себя две стадии: стадию обучения, которая «обучает» или «учит» модель CNN с использованием обучающих массивов данных, которые включают в себя 3D-изображения, помеченные различными анатомическими структурами для каждого воксела, и стадию сегментации, которая использует обученную модель CNN, чтобы прогнозировать анатомическую структуру каждого воксела входного 3D-изображения и/или помечать каждый воксел входного 3D-изображения анатомической структурой. Способы сегментации изображения, системы, устройства и/или процессы на основе вышеописанных моделей CNN подробно описаны ниже.

Система сегментации изображения на основе модели CNN

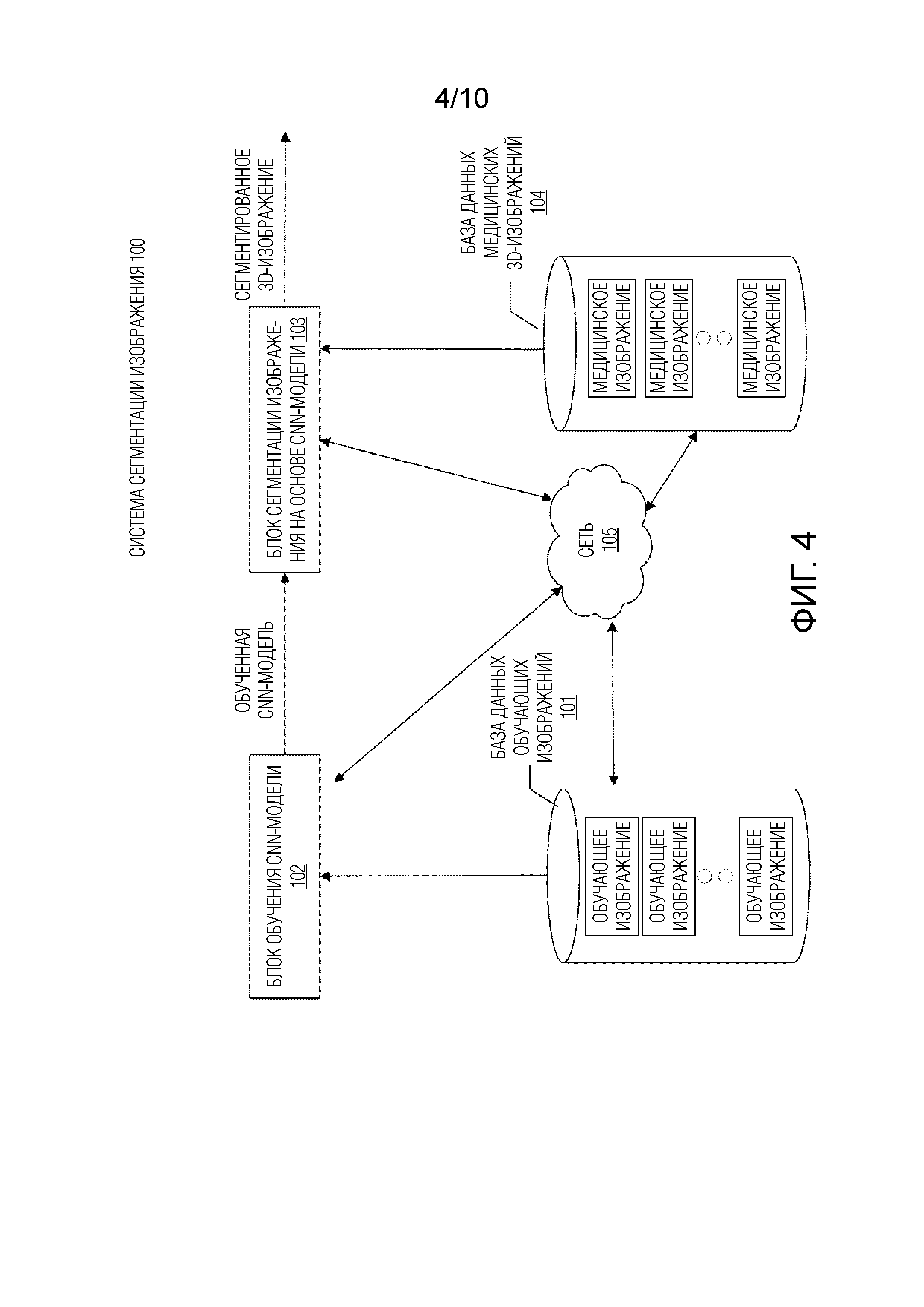

[069] Фиг. 4 иллюстрирует примерную систему 100 сегментации изображения для сегментации 3D-изображений на основе по меньшей мере одной модели CNN, согласно некоторым вариантам осуществления настоящего изобретения. Как показано на фиг. 4, система 100 сегментации изображения может включать в себя компоненты для выполнения двух стадий: стадии обучения и стадии сегментации. Чтобы выполнять стадию обучения, система 100 сегментации изображения может включать в себя базу 101 данных обучающих изображений и блок 102 обучения модели CNN. Чтобы выполнять стадию сегментации, система 100 сегментации изображения может включать в себя блок 103 сегментации изображения на основе модели CNN и базу 104 данных медицинских изображений. В некоторых вариантах осуществления система 100 сегментации изображения может включать в себя больше или меньше компонентов, показанных на фиг. 4. Например, когда модель CNN для сегментации изображения предварительно обучена и предусмотрена, система 100 сегментации изображения может включать в себя только блок 103 сегментации и базу 104 данных медицинских изображений. Система 100 сегментации изображения может необязательно включать в себя сеть 105. В некоторых вариантах осуществления, сеть 105 может быть заменена проводными системами или устройствами обмена данными.

[070] В некоторых вариантах осуществления различные компоненты системы 100 сегментации изображения могут быть расположены удаленно друг от друга или в различных пространствах и быть соединены через сеть 105, как показано на фиг. 4. В некоторых альтернативных вариантах осуществления некоторые компоненты системы 100 сегментации изображения могут быть расположены на одном участке или внутри одного устройства. Например, база 101 данных обучающих изображений может быть расположена на участке с блоком 102 обучения модели CNN или быть частью блока 102 обучения модели CNN. В качестве другого примера, блок 102 обучения модели CNN и блок 103 сегментации может быть внутри одного и того же компьютера или устройства обработки.

[071] Как показано на фиг. 4, блок 102 обучения модели CNN может связываться с базой 101 данных обучающих изображений, чтобы принимать один или более наборов обучающих изображений. Наборы обучающих изображений, сохраненных в базе 101 данных обучающих изображений, могут быть получены из базы данных медицинских изображений, например, базы данных медицинских изображений, содержащей ранее полученные медицинские изображения во время сеансов лечения радиотерапией. Каждый набор обучающих изображений может включать в себя 3D-изображение и соответствующую ему 3D-карту меток контрольных данных, которая ассоциирует анатомическую структуру с каждым из вокселов 3D-изображения. 3D-изображение может быть выборочно разделено на один или более последовательных стеков смежных 2D-изображений. 3D-карта меток контрольных данных может быть разделена на последовательные 2D-карты меток контрольных данных, соответственно соответствующими последовательным стекам смежных 2D-изображений, и пикселы 2D-карт меток контрольных данных ассоциируются с известными анатомическими структурами. Число смежных 2D-изображений в каждом стеке может быть определено на основе различных факторов, таких как размер 3D-изображения, конкретная инфраструктура модели CNN, соотношение между анатомическими структурами в смежных 2D-изображениях вдоль оси, ортогональной 2D-изображению, и/или применение сегментации.

[072] В некоторых вариантах осуществления стек смежных 2D-изображений включает в себя нечетное число изображений, такое как 3, 5, 7 или любое подходящее нечетное число. В таких случаях, карта меток контрольных данных обеспечивает метку известной анатомической структуры для каждого пиксела среднего изображения стека. В других вариантах осуществления стек смежных 2D-изображений включает в себя четное число изображений, такое как 2, 4, 6 или любое подходящее четное число. В таких случаях, карта меток контрольных данных обеспечивает метку известной анатомической структуры для каждого пиксела одного из двух средних изображений стека.

[073] В соответствии с раскрытыми вариантами осуществления, обучающие изображения могут быть получены с использованием различных методик формирования изображения, включающих в себя MRI, функциональное MRI (например, fMRI, DCE-MRI и диффузионное MRI), CT, CBCT, спиральную CT, PET, SPECT, рентген, оптическую томографию, флюоресцентное формирование изображений, ультразвуковое формирование изображений и портальное формирование изображений в радиотерапии и т.д. В некоторых вариантах осуществления обучающие данные могут быть собраны из онкологической информационной системы. Например, обучающие изображения могут быть получены посредством устройства 140 получения изображения.

[074] Блок 102 обучения модели CNN может использовать обучающие изображения, полученные из базы 101 данных обучающих изображений, чтобы обучать модель CNN для выполнения сегментации изображения для новых 3D-изображений. Блок 102 обучения модели CNN может включать в себя процессор и постоянный машиночитаемый носитель (описанный подробно в связи с фиг. 5). Процессор может выполнять обучение посредством выполнения инструкций процесса обучения, сохраненных на машиночитаемом носителе. Блок 102 обучения модели CNN может дополнительно включать в себя входной и выходной интерфейсы (описанные подробно в связи с фиг. 5) для связи с базой 101 данных обучающих изображений, сетью 105 и/или пользовательским интерфейсом (не показан). Пользовательский интерфейс может быть использован для выбора наборов обучающих изображений, регулировки одного или более параметров процесса обучения (например, числа смежных слоев изображения в каждом стеке), выбора или модификации инфраструктуры модели CNN и/или ручной или полуавтоматической сегментации изображения для обучения. Ниже с дополнительными подробностями описаны примеры процесса обучения со ссылкой на фиг. 6.

[075] В соответствии с некоторыми вариантами осуществления, блок 102 обучения модели CNN может быть реализован аппаратными средствами (например, как описано на фиг. 5), специально запрограммированными посредством программного обеспечения, которое выполняет процесс обучения (например, как описано на фиг. 6).

[076] Блок 103 сегментации может принимать по меньшей мере одну обученную модель CNN от блока 102 обучения модели CNN. Блок 103 сегментации может включать в себя процессор и постоянный машиночитаемый носитель (описанный подробно в связи с фиг. 5). Процессор может выполнять сегментацию 3D-изображения, выполняя инструкции процесса сегментации изображения, сохраненные на носителе. Блок 103 сегментации может дополнительно включать в себя входной и выходной интерфейсы (обсуждаемые подробно в связи с фиг. 5) для связи с базой 104 данных медицинских изображений, сетью 105 и/или пользовательским интерфейсом (не показан). Пользовательский интерфейс может быть использован для выбора 3D-изображения, которое должно быть сегментировано, инициирования процесса сегментации, отображения сегментированного 3D-изображения или 3D-карты меток и/или выполнения дополнительного анализа на основе сегментированного изображения или 3D-карты меток. Ниже с дополнительными подробностями описаны примеры процесса сегментации изображения со ссылкой на фиг. 7A-8B.

[077] В соответствии с некоторыми вариантами осуществления, блок 103 сегментации может быть реализован аппаратными средствами (например, как описано на фиг. 5), специально запрограммированными посредством программного обеспечения, которое выполняет процесс сегментации изображения (например, как описано на фиг. 7A и 7B).

[078] Блок 103 сегментации может связываться с базой 104 данных медицинских изображений, чтобы принимать одно или более 3D-изображений. 3D-изображения, сохраненные в базе 104 данных медицинских изображений, могут быть получены из медицинской базы данных изображений, которая содержит, например, 2D и/или 3D-изображения сеансов лечения радиотерапией. Как описано в данном документе, 3D-изображения могут быть восстановлены из изображений 2D-проекций, полученных посредством устройств формирования медицинских изображений, таких как устройство 140 получения изображения. Эти 3D-изображения обычно еще не являются сегментированными.

[079] Блок 103 сегментации может использовать по меньшей мере одну обученную модель CNN, принятую от блока 102 обучения модели CNN, чтобы прогнозировать анатомическую структуру, которую представляет каждый воксел 3D-изображения. Когда сегментация изображения завершена, блок 103 сегментации может выводить 3D-карту меток, ассоциирующую каждый воксел 3D-изображения с анатомической структурой. 3D-карта меток может быть отображена в пользовательском интерфейсе и/или сохранена в базе 104 данных медицинских изображений для дальнейшего использования в планировании лечения. В некоторых вариантах осуществления сегментированное изображение может быть автоматически сохранено в базе 101 данных обучающих изображений и становиться обучающим изображением.

[080] В соответствии с раскрытыми вариантами осуществления, 3D-изображения, которые должны быть сегментированы, могут быть получены с использованием различных методик формирования изображения, включающих в себя MRI, функциональное MRI (например, fMRI, DCE-MRI и диффузионное MRI), CT, CBCT, спиральную CT, PET, SPECT, рентген, оптическую томографию, флюоресцентное формирование изображений, ультразвуковое формирование изображений и портальное формирование изображений в радиотерапии и т.д. В некоторых вариантах осуществления база 104 данных медицинских изображений может быть интегрированной частью блока 103 сегментации или расположена на том же участке блока 103 сегментации, как, например, в радиотерапевтическом процедурном кабинете.

[081] Сеть 105 может обеспечивать соединения между любыми из вышеописанных компонентов в системе 100 сегментации изображения. Например, сеть 105 может быть локальной вычислительной сетью (LAN), беспроводной сетью, облачным вычислительным окружением (например, программным обеспечением в качестве услуги, платформой в качестве услуги, инфраструктурой в качестве услуги), клиент-серверной системой, глобальной вычислительной сетью (WAN) и т.д.

Устройство обработки изображения на основе модели CNN

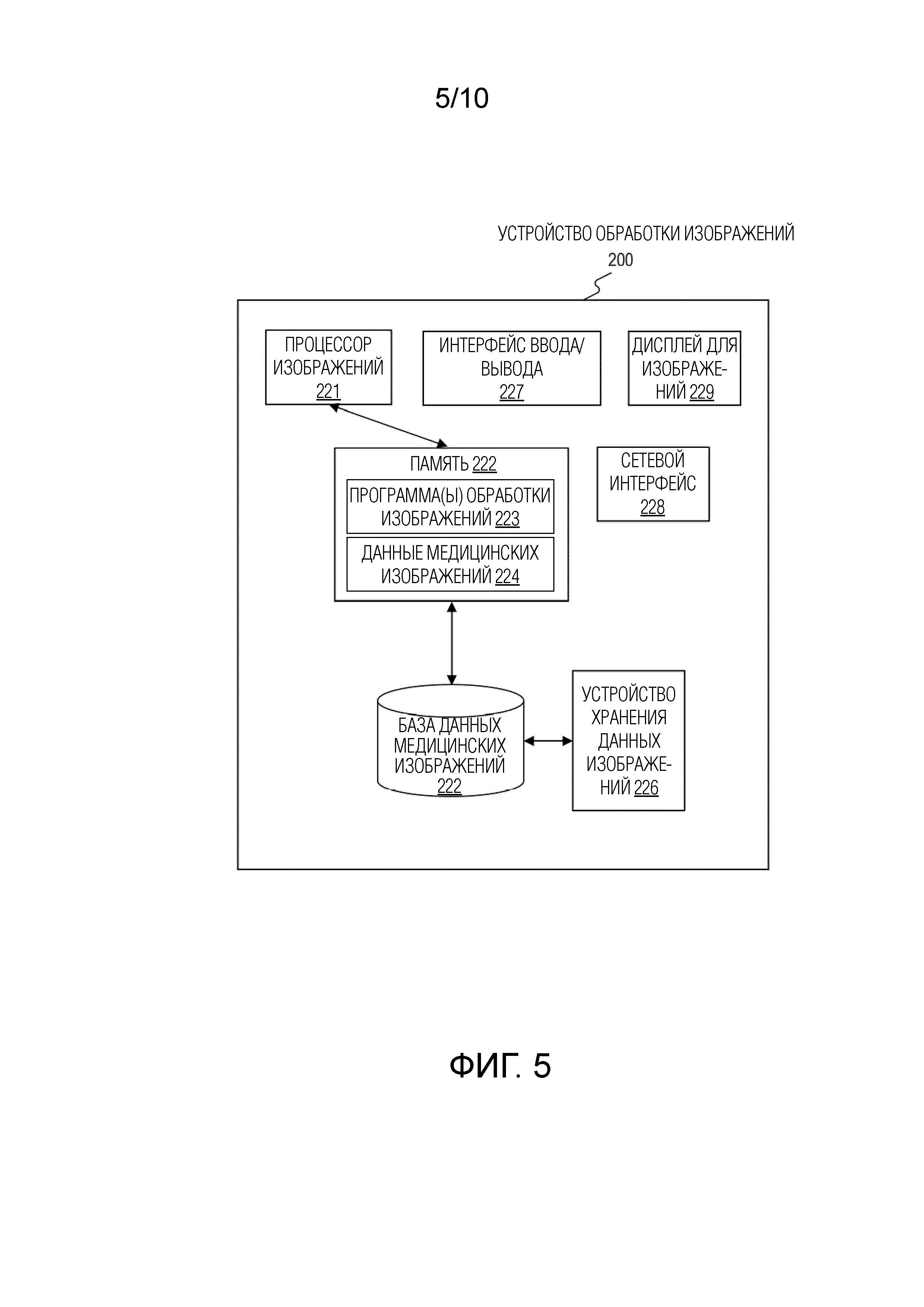

[082] Фиг. 5 иллюстрирует примерное устройство 200 обработки изображения согласно некоторым вариантам осуществления настоящего изобретения. Устройство 200 обработки изображения может быть вариантом осуществления блока 102 обучения модели CNN, или блока 103 сегментации, или сочетанием обоих. Как будет понятно специалистам в области техники, в некоторых вариантах осуществления, устройство 200 обработки изображения может быть специализированным компьютером или компьютером общего назначения. Например, устройство 200 обработки изображения может быть компьютером, изготовленным по заказу для больниц, чтобы выполнять задачи получения изображения и обработки изображения.

[083] Как показано на фиг. 5, устройство 200 обработки изображения может включать в себя процессор 221 изображений, память 222, базу 225 данных медицинских изображений, устройство 226 хранения данных изображений, интерфейс 227 ввода/вывода, сетевой интерфейс 228 и дисплей 229 для изображений.

[084] Процессор 221 изображений может быть одним или более устройствами обработки общего назначения, таким как микропроцессор, центральный процессор (CPU), графический процессор (GPU) и т.д. Процессор 221 изображений может также быть одним или более специализированными устройствами обработки, такими как специализированная интегральная схема (ASIC), программируемая пользователем вентильная матрица (FPGA), цифровой сигнальный процессор (DSP), система на кристалле (SoC) и т.д.

[085] Процессор 221 изображений может быть соединен с возможностью обмена данными с памятью 222 и выполнен с возможностью выполнения машиноисполняемых инструкций, сохраненных в ней. Память 222 может быть постоянным машиночитаемым носителем, таким как постоянное запоминающее устройство (ROM), оперативное запоминающее устройство (RAM), оперативное запоминающее устройство с фазовым переходом (PRAM), статическое оперативное запоминающее устройство (SRAM), динамическое оперативное запоминающее устройство (DRAM), электрически стираемое программируемое постоянное запоминающее устройство (EEPROM), другие типы оперативных запоминающих устройств (RAM), флеш-диск или другие формы флеш-памяти, кэш, регистр, статическая память, постоянное запоминающее устройство на компакт дисках (CD-ROM), цифровой универсальный диск (DVD) или другое оптическое запоминающее устройство, кассетная лента или другие магнитные запоминающие устройства или любой другой постоянный носитель, который может быть использован для хранения информации или инструкций, приспособленный для осуществления доступа посредством компьютерного устройства, и т.д.

[086] В некоторых вариантах осуществления память 222 может хранить машиноисполняемые инструкции, такие как одна или более программ 223 обработки изображения, также как данные, используемые или формируемые во время выполнения компьютерных программ, такие как данные 224 медицинских изображений. Процессор 221 изображений может выполнять программы 223 обработки изображений, чтобы реализовывать функциональные возможности блока 102 обучения модели CNN и/или блока 103 сегментации. Процессор 221 изображений может также отправлять и/или принимать данные 224 медицинских изображений из памяти 222. Например, процессор 221 изображений может принимать данные обучающих изображений или данные медицинских изображений, сохраненные в памяти 222. Процессор 221 изображений может также формировать промежуточные данные, такие как обновленные параметры модели CNN, и/или промежуточные 2D и/или 3D-сегментированные изображения или карты меток, и отправлять их в память 222.

[087] Устройство 200 обработки изображений может необязательно включать в себя базу 225 данных медицинских изображений, которая включает в себя одну или обе из базы 101 данных обучающих изображений и базы 104 данных медицинских изображений. Специалист в области техники поймет, что база 225 данных медицинских изображений может включать в себя множество устройств, расположенных либо централизованным, либо распределенным образом. Процессор 221 изображений может связываться с базой 225 данных медицинских изображений, чтобы считывать изображения в память 222 или сохранять сегментированные изображения из памяти 222 в базу 225 данных медицинских изображений.

[088] Устройство 226 хранения данных изображений может быть дополнительным запоминающим устройством, доступным для хранения данных, ассоциированных с задачами обработки изображений, выполняемыми посредством процессора 221 изображений. В некоторых вариантах осуществления устройство 226 хранения данных изображений может включать в себя постоянный машиночитаемый или считываемый компьютером носитель данных. В то время как машиночитаемый или считываемый компьютером носитель данных в варианте осуществления может представлять собой один носитель, выражение «машиночитаемый носитель данных» или «считываемый компьютером носитель данных» следует понимать как включающее в себя один носитель или множество носителей (например, централизованную или распределенную базу данных и/или ассоциированные кэши и серверы), которые хранят один или более наборов машиноисполняемых инструкций или данных. Выражение «машиночитаемый носитель данных» или «считываемый компьютером носитель данных» также следует понимать как включающие в себя любой носитель, который приспособлен для хранения или кодирования набора инструкций для выполнения посредством машины или компьютера, и которые предписывают машине или компьютеру выполнять какой-либо один или более способов настоящего изобретения. Выражение «машиночитаемый носитель данных» или «считываемый компьютером носитель данных» должны соответственно включать в себя, не ограничиваясь, твердотельные запоминающие устройства, оптический и магнитный носитель.

[089] Интерфейс 227 ввода/вывода может быть выполнен с обеспечением возможности приема и/или передачи данных посредством устройства 200 обработки изображений. Интерфейс 227 ввода/вывода может включать в себя одно или более цифровых и/или аналоговых устройств связи, которые позволяют устройству 200 обработки изображений связываться с пользователем или другими машинами и устройствами. Например, интерфейс 227 ввода/вывода может включать в себя клавиатуру и мышь для того, чтобы пользователь вводил входные данные в устройство 200 обработки изображений.

[090] Сетевой интерфейс 228 может включать в себя сетевой адаптер, кабельный разъем, последовательный разъем, USB-разъем, параллельный разъем, адаптер высокоскоростной передачи данных, такой как оптоволокно, USB 3.0, thunderbolt и т.п., адаптер беспроводной сети, такой как WiFi-адаптер, телекоммуникационный (3G, 4G/LTE и т.п.) адаптер и т.д. Устройство 200 обработки изображений может быть соединено с сетью 105 через сетевой интерфейс 228. Дисплей 229 для изображений может быть любым устройством отображения, подходящим для отображения медицинских изображений. Например, дисплей 229 для изображений может быть LCT, CRT или LED-дисплеем.

Примерные процессы обучения модели CNN

[091] Примерные процессы обучения, выполняемые посредством способов сегментации изображения, систем и устройств настоящего изобретения, описаны подробно ниже со ссылками на фиг. 6.

[092] Фиг. 6 - это блок-схема, иллюстрирующая примерный процесс 400 обучения для обучения модели CNN, согласно некоторым вариантам осуществления настоящего изобретения. В некоторых вариантах осуществления процесс 400 обучения может быть выполнен посредством блока 102 обучения модели CNN.

[093] Процесс 400 обучения может начинаться, когда блок 102 обучения модели CNN принимает набор обучающих изображений (этап 410). Как описано выше, набор обучающих изображений может включать в себя 3D-обучающее изображение и его соответствующую 3D-карту меток контрольных данных. Например, 3D-обучающее изображение может показывать тазовую область, область головы, сердечную область, область печени или другую анатомическую область пациента. В некоторых вариантах осуществления обучающее изображение может быть такой же или аналогичной интересующей областью, что и изображение, которое должно быть сегментировано.

[094] Как показано на фиг. 6, чтобы устанавливать начальную точку итерации для обучения модели CNN, на этапе 412, индекс для отслеживания числа итераций устанавливается, например, в ноль. На этапе 414 блок 102 обучения модели CNN может выбирать, например, случайным образом, один или более стеков смежных 2D-изображений из 3D-обучающего изображения(ий) и соответствующие 2D-карты меток контрольных данных и использовать выбранные изображения и карты совместно как один пакет обучающих данных для обучения модели CNN. Например, серия последовательных стеков смежных 2D-изображений вдоль анатомической плоскости может быть получена из 3D-обучающего изображения. Последовательные стеки могут иметь одно или более перекрывающихся изображений, так что средние изображения последовательности стеков могут практически составлять все 3D-обучающее изображение. Кроме того, блок 102 обучения модели CNN может принимать соответствующую 2D-карту меток контрольных данных среднего изображения каждого из выбранных стеков смежных 2D-изображений. Например, как описано выше, 3D-карта меток контрольных данных может быть разделена на серию последовательных 2D-карт меток контрольных данных, соответственно соответствующих последовательным стекам смежных 2D-изображений. 2D-карта меток обеспечивает метку известной анатомической структуры для каждого пиксела среднего изображения выбранного стека смежных 2D-изображений. Следовательно, каждый пиксел 2D-карты меток ассоциируется либо с фоном, либо одной из известных анатомических структур, содержащихся в выбранном стеке смежных 2D-изображений. Как описано выше, стек смежных 2D-изображений содержит зависимую структурную информацию между ними вдоль оси, ортогональной анатомической плоскости.

[095] В некоторых вариантах осуществления один или более стеков смежных 2D-изображений, выбранных на этапе 414, может быть вдоль выбранной плоскости из трех анатомических плоскостей, таких как осевая плоскость, сагиттальная плоскость или фронтальная плоскость. В таких обстоятельствах, процесс 400 может выводить обученную модель CNN для этой выбранной плоскости, например, для сегментации 3D-изображения, разделенного на слои вдоль этой выбранной плоскости. В некоторых вариантах осуществления процесс 400 может быть повторен, чтобы выводить три различных модели CNN, обученных для сегментации слоев 3D-изображений вдоль трех анатомических плоскостей, соответственно.

[096] В других вариантах осуществления один или более стеков смежных 2D-изображений, выбранных на этапе 414, может быть вдоль двух или более выбранных анатомических плоскостей. Процессы 400 могут быть выполнены, чтобы выводить одну обученную модель CNN, которая может быть использована для сегментации изображений вдоль одной из двух или более выбранных анатомических плоскостей. В других вариантах осуществления один или более стеков смежных 2D-изображений, выбранных на этапе 414, может быть вдоль любой из трех анатомических плоскостей, например по меньшей мере один стек смежных 2D-изображений выбирается для каждой анатомической плоскости. Процессы 400 могут выполняться, чтобы получать одну обученную модель CNN, которая может быть использована для сегментации изображений вдоль любой из трех анатомических плоскостей. В таких случаях, выходная модель CNN обучается с использованием объединенных стеков смежных 2D-изображений вдоль всех трех анатомических плоскостей.

[097] Этапы 414-422 могут выполняться итеративно более чем один раз, чтобы обучать модель CNN до тех пор, пока модель CNN не выведет удовлетворительно оцененные 2D и/или 3D-карты меток. Число итераций может быть определено по различным критериям остановки. В некоторых вариантах осуществления может быть использовано максимальное число итераций. В каждой итерации новый пакет обучающих данных может случайным образом выбираться и использоваться для обучения модели CNN, до тех пор, пока максимальное число итераций не будет достигнуто. в качестве альтернативы,В качестве дополнения или альтернативы, ожидаемая точность может быть задана прежде обучения модели CNN. Пакетный выбор и обновление параметров модели CNN выполняются циклически до тех пор, пока точность выходных 2D и/или 3D-карт меток не будет удовлетворять ожидаемой точности.

[098] Чтобы устанавливать начальную точку итерации для обучения модели CNN, на этапе 412, как показано на фиг. 6, индекс для отслеживания числа итераций устанавливается, например, в ноль. На этапе 414 пакет обучающих данных выбирается, например, случайным образом, как описано выше. На этапе 416 блок 102 обучения модели CNN может вводить выбранный пакет обучающих данных в модель CNN для обучения. На этапе 418 блок 102 обучения модели CNN может применять модель CNN с ее текущими параметрами, например, весовыми коэффициентами фильтров, чтобы получать оцененные 2D-карты меток, соответствующие входным стекам смежных 2D-изображений.

[099] На этапе 420 блок 102 обучения модели CNN может сравнивать расчетные 2D-карты меток с 2D-картами меток контрольных данных, выбранными на этапе 412, и вычислять соответствующие карты ошибок. На этапе 422 блок 102 обучения модели CNN может определять или обновлять параметры одного или более слоев модели CNN на основе полученных карт ошибок. Например, метод обратного распространения ошибки может быть использован для определения или обновления параметров одного или более слоев модели CNN на основе различия между 2D-картами меток контрольных данных и выходными расчетными 2D-картами меток. Метод обратного распространения ошибки может оптимизировать параметры, минимизируя функцию потерь, например, относительно всех параметров в модели CNN.

[0100] На этапе 424 блок 102 обучения модели CNN может увеличивать индекс для отслеживания номера итерации на единицу. На этапе 426 блок 102 обучения модели CNN может определять, удовлетворяются ли критерии для прекращения итерации. Как описано выше, в некоторых вариантах осуществления, блок 102 обучения модели CNN может определять, равен ли индекс или больше заданного максимального числа индекса. В качестве дополнения или альтернативы, блок 102 обучения модели CNN может определять, удовлетворяет ли точность расчетных 2D-карт меток или превышает ожидаемую точность, например, посредством определения того, меньше ли функция потерь, чем пороговое значение. Если блок 102 обучения модели CNN определяет, что критерии для прекращения итерации не были удовлетворены (этап 426: Нет), процесс 400 обучения может возвращаться к этапу 414, чтобы в очередной раз выбирать новый пакет обучающих данных для обучения модели CNN. Если блок 102 обучения модели CNN определяет, что критерии для прекращения итерации были удовлетворены (этап 426: Да), процесс 400 обучения может переходить к этапу 428, который может сохранять модель CNN с обновленными параметрами и/или выводить обученную модель CNN.

[0101] В некоторых вариантах осуществления более одного набора данных обучающих изображений (например, более одного 3D-обучающего изображения и соответствующие 3D-карты меток контрольных данных) используются для обучения модели CNN. В таких случаях, при выборе пакета обучающих данных на этапе 414, можно сначала случайным образом выбирать один или более наборов данных 3D-обучающих изображений, а затем случайным образом выбирать один или более стеков смежных 2D-изображений и соответствующие 2D-карты меток контрольных данных из каждого из выбранных наборов данных 3D-изображений. Этапы 414-426 могут затем продолжаться аналогично тому, как описано выше.

Примерные процессы сегментации изображения на основе модели CNN

[0102] Примерные процессы сегментации изображения, выполняемые посредством способов сегментации изображения, систем и устройств настоящего изобретения, подробно описаны ниже со ссылками на фиг. 7A-8B.

[0103] Фиг. 7A - это блок-схема, иллюстрирующая примерный процесс 500A сегментации изображения с использованием обученной модели CNN, полученной посредством процесса на фиг. 6, согласно некоторым вариантам осуществления настоящего изобретения. Процесс 500A сегментации изображения может быть выполнен посредством блока 103 сегментации. Как показано на фиг. 7A, процесс 500A сегментации изображения может начинаться, когда блок 103 сегментации принимает 3D-изображение, которое должно быть сегментировано (этап 512). 3D-изображение может быть медицинским 3D-изображением, например, медицинским 3D-изображением, показывающим тазовую область, область головы, сердечную область, область печени или другую анатомическую область пациента. На этапе 514 блок 103 сегментации может принимать обученную модель CNN.

[0104] На этапе 516 блок 103 сегментации может выбирать стек смежных 2D-изображений из серии стеков смежных 2D-изображений, сформированных из 3D-изображения. Как описано выше, серия стеков смежных 2D-изображений может быть последовательной и иметь одно или более перекрывающихся изображений, так что средние изображения стеков вместе практически составляют все 3D-изображение. На этапе 518 стек в серии вводится в обученную модель CNN. На этапе 520 блок 103 сегментации может определять 2D-выходную карту меток среднего изображения в стеке. На этапе 522 блок 103 сегментации может определять, были ли все стеки смежных 2D-изображений введены в обученную модель CNN. Если блок 103 сегментации определяет, что не все стеки смежных 2D-изображений, сформированные из 3D-изображения, используются (этап 522: Нет), процесс 500A сегментации изображения может возвращаться к этапу 516. Если блок 103 сегментации определяет, что все стеки смежных 2D-изображений, сформированные из 3D-изображения, используются (этап 522: Да), процесс 500A сегментации изображения может переходить к этапу 524.

[0105] На этапе 524 3D-карта меток может быть определена на основе 2D-карт меток средних изображений стеков смежных 2D-изображений. Например, 3D-карта меток может быть получена посредством агрегирования 2D-карт меток для средних изображений согласно последовательности средних изображений вдоль оси, ортогональной анатомической плоскости стеков 2D-изображений. Необязательно, процесс 500A сегментации изображения может включать в себя этап 526. На этапе 526 блок 103 сегментации выводит сегментированное 3D-изображение. Например, блок 103 сегментации может отображать сегментированное 3D-изображение или 3D-карту меток для дальнейшего анализа или наблюдения.

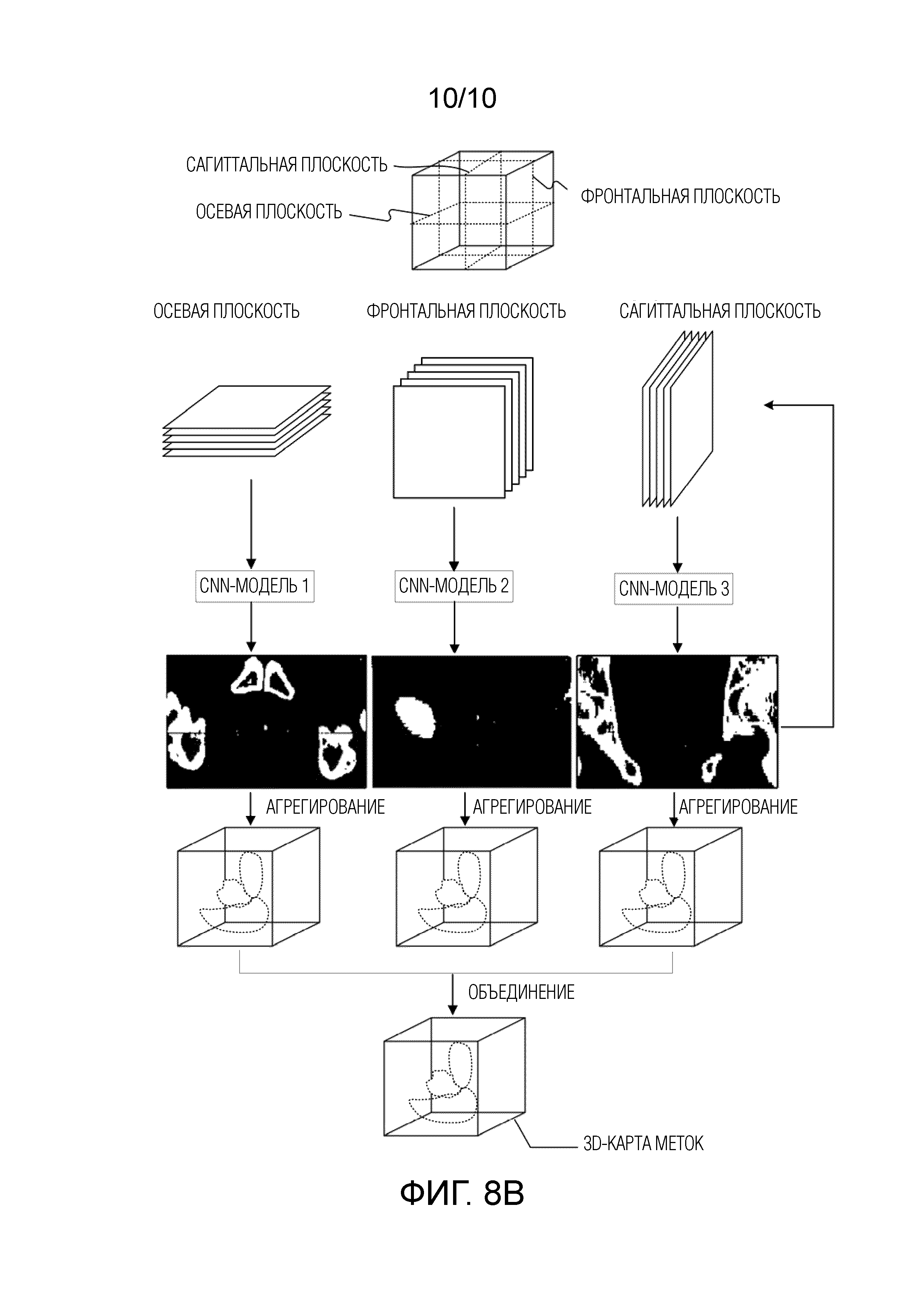

[0106] Фиг. 7B - это блок-схема, иллюстрирующая другой примерный процесс 500B сегментации изображения с использованием одной или более обученных моделей CNN, полученных посредством процесса на фиг. 6, согласно некоторым вариантам осуществления настоящего изобретения. Процесс 500B сегментации изображения может быть выполнен посредством блока 103 сегментации. Процесс 500B сегментации изображения может включать в себя аналогичные этапы, что и этапы в процессе 500A сегментации изображения. Процесс 500B сегментации изображения может начинаться, когда блок 103 сегментации принимает 3D-изображение, которое должно быть сегментировано (этап 528). 3D-изображение может быть медицинским 3D-изображением, например, медицинским 3D-изображением, показывающим тазовую область, область головы, сердечную область, область печени или другую анатомическую область пациента.

[0107] На этапе 530 блок 103 сегментации может выбирать плоскость 3D-изображения, принятую на этапе 528, для получения стеков смежных 2D-изображений. Например, если 3D-изображение является медицинским 3D-изображением, этап 530 может выбирать одну из трех анатомических плоскостей, таких как осевая плоскость, сагиттальная плоскость и фронтальная плоскость. На этапе 532 блок 103 сегментации может формировать серию стеков смежных 2D-изображений из 3D-изображения вдоль выбранной анатомической плоскости.

[0108] На этапе 534 блок 103 сегментации может принимать одну или более обученных CNN-моделей. В некоторых вариантах осуществления принятая обученная модель CNN может быть обучена с использованием стеков смежных 2D-изображений вдоль той же анатомической плоскости, что и выбранная на этапе 530. В таких случаях, когда выбранная плоскость на этапе 530 изменяется, другая обученная модель CNN, соответствующая анатомической плоскости, может быть принята и использована для выполнения сегментации изображения. В других вариантах осуществления обученная модель CNN может быть обучена с использованием стеков смежных 2D-изображений вдоль всех трех анатомических плоскостей 3D-изображения. В таких случаях, одинаковая обученная модель CNN может быть использована для выполнения сегментации изображения для стеков смежных 2D-изображений вдоль любой выбранной анатомической плоскости или любых стеков смежных 2D-изображений, объединенных из трех анатомических плоскостей.

[0109] Этапы 536-542 являются аналогичным этапам 516-522 процесса 500A сегментации изображения. На этапе 536 блок 103 сегментации может выбирать стек смежных 2D-изображений из серии стеков смежных 2D-изображений, сформированных на этапе 532. На этапе 538 стек в серии вводится в обученную модель CNN. На этапе 540 блок 103 сегментации может определять 2D-выходную карту меток среднего изображения в стеке. На этапе 542 блок 103 сегментации может определять, были ли все стеки смежных 2D-изображений введены в обученную модель CNN. Если блок 103 сегментации определяет, что не все стеки смежных 2D-изображений, сформированные из 3D-изображения вдоль выбранной анатомической плоскости, используются (этап 542: Нет), процесс 500B сегментации изображения может переходить обратно к этапу 536. Если блок 103 сегментации определяет, что все стеки смежных 2D-изображений, сформированные из 3D-изображения вдоль выбранной анатомической плоскости, используются (этап 542: Да), процесс 500B сегментации изображения может переходить к этапу 544.

[0110] На этапе 544 3D-карта меток может быть определена на основе 2D-карт меток средних изображений стеков смежных 2D-изображений. Например, 3D-карта меток может быть получена посредством агрегирования 2D-карт меток для средних изображений согласно последовательности средних изображений вдоль оси, ортогональной анатомической плоскости стеков 2D-изображений. Кроме того, процесс 500B сегментации изображения может включать в себя этап 546. На этапе 546 блок 103 сегментации определяет, все ли три серии стеков смежных 2D-изображений вдоль всех трех плоскостей (например, осевой плоскости, сагиттальной плоскости и фронтальной плоскости) были использованы для сегментации 3D-изображения. Если блок 103 сегментации определяет, что не все три серии стеков 2D-изображений, соответствующие всем трем плоскостям, были использованы (этап 546: Нет), процесс 500B сегментации изображения может переходить обратно к этапу 530, чтобы выбирать другую анатомическую плоскость. Если блок 103 сегментации определяет, что все три серии стеков 2D-изображений, соответствующие всем трем плоскостям, были использованы (этап 546: Да), процесс 500B сегментации изображения может переходить к этапу 548.

[0111] На этапе 548 блок 103 сегментации определяет окончательную 3D-карту меток. Окончательная 3D-карта меток может быть определена посредством объединения трех 3D-карт меток, определенных для трех анатомических плоскостей. В некоторых вариантах осуществления значение воксела объединенной 3D-карты меток может быть определено большинством голосов. Например, если две из трех 3D-карт меток маркируют воксел 3D-изображения как анатомическую структуру, соответствующий воксел объединенной 3D-карты меток определяется как ассоциированный с той же анатомической структурой. В других вариантах осуществления воксел объединенной 3D-карты меток определяется на основе максимальной вероятности или возможности, рассчитанной для соответствующих вокселов в трех 3D-картах меток. Например, если первая 3D-карта меток определяет, что воксел представляет мочевой пузырь с вероятностью 0,5, вторая 3D-карта меток определяет, что воксел представляет предстательную железу с вероятностью 0,4, и третья 3D-карта меток определяет, что воксел представляет прямую кишку с вероятностью 0,2, воксел тогда будет промаркирован в объединенной 3D-карте меток как представляющий мочевой пузырь. Как описано в данном документе, любые подходящие способы могут быть использованы для объединения трех 3D-карт меток, определенных в процессе 500B сегментации изображения.

[0112] Как описано выше, модель CNN может быть обучена с использованием стеков смежных 2D-изображений вдоль трех анатомических плоскостей. В таких случаях, когда процесс 500B сегментации изображения выполняет этап 530, чтобы выбирать вторую анатомическую плоскость, и этап 532, чтобы формировать серию стеков смежных 2D-изображений вдоль выбранной анатомической плоскости, процесс 500B сегментации изображения может пропускать этап 534 и переходить к этапу 536. Процесс 500B сегментации изображения для сегментации медицинского 3D-изображения дополнительно иллюстрируется на фиг. 8A и 8B.