Результат интеллектуальной деятельности: НАЗНАЧЕНИЕ ОЦЕНКИ РЕЛЕВАНТНОСТИ ДЛЯ ИСКУССТВЕННЫХ НЕЙРОННЫХ СЕТЕЙ

Вид РИД

Изобретение

Настоящая заявка относится к назначению оценки релевантности для искусственных нейронных сетей. Такое назначение оценки релевантности может использоваться, например, для идентификации области, представляющей интерес (ROI).

Компьютерные программы способны успешно решать многие сложные задачи, такие как автоматическая классификация изображений и текста или оценка кредитоспособности человека. Алгоритмы машинного обучения особенно успешны, потому что они учатся на основе данных, т.е. программа получает большой маркированный (или слабо маркированный) набор для обучения, и после некоторой фазы обучения она может выполнять обобщение на новые ненаблюдавшиеся примеры. Многие банки имеют систему, которая классифицирует кредитоспособность (например, на основе возраста, адреса, дохода и т.д.) лица, которое подает заявку на получение кредита. Основным недостатком таких систем является интерпретируемость, т.е. система обычно не предоставляет информацию о том, почему и как она приняла решение (например, почему кто-то классифицируется как некредитоспособный); знания и отношения, которые определяют решение классификации, скорее являются ʺнеявнымиʺ.

Понимание и интерпретация решений классификации имеет большое значение во многих приложениях, поскольку позволяет проверять обоснование системы и предоставляет дополнительную информацию эксперту-человеку, например, банкиру, венчурному инвестору или врачу. Методы машинного обучения в большинстве случаев имеют недостаток, заключающийся в их действии по принципу черного ящика, не предоставляя никакой информации о том, что заставило их прийти к определенному решению. В общем случае сложные алгоритмы имеют гораздо лучшую производительность, чем простые (линейные) методы (при наличии достаточного количества данных обучения), однако им особенно не хватает интерпретируемости. В последнее время, классификаторы типа нейронных сетей становятся очень популярными и обеспечивают отличные результаты. Методы этого типа состоят из последовательности нелинейных отображений и особенно трудно интерпретируются.

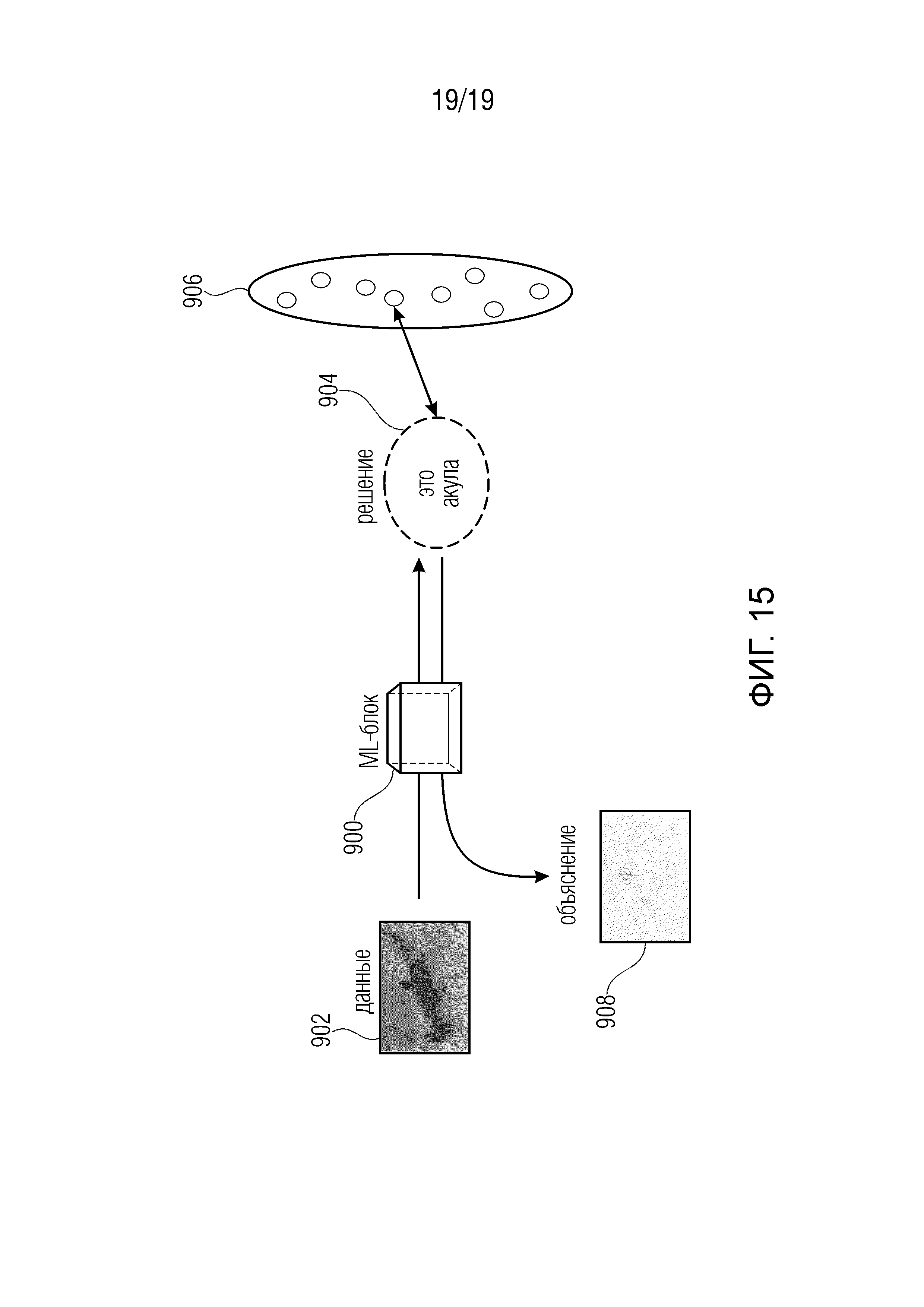

В типичной задаче классификации изображений, например, может быть задано изображение (например, изображение акулы). См. фиг. 15. Алгоритм 900 машинного обучения (ML) классифицирует изображение 902 как принадлежащее к определенному классу 904 (например, 'изображения акулы'). Отметим, что набор 906 классов (например, акулы, лица, ночная жизнь, на улице) определен априори. Алгоритм 900 является черным ящиком, потому что он не сообщает пользователю, почему он пришел к решению о том, что изображение принадлежит к классу 'изображения акулы'. Было бы интересно объяснить это решение классификации на пиксельном уровне, например, чтобы увидеть, что изображение проклассифицировано как принадлежащее к классу 'изображения акулы', главным образом из-за плавника акулы. Такая ʺкарта релевантностиʺ проиллюстрирована на 908.

Классификация изображений стала ключевым компонентом многих приложений компьютерного зрения, например, поиска изображений [15], робототехники [10], медицинской визуализации [50], обнаружения объекта в радиолокационных изображениях [17] или обнаружения лица [49]. Нейронные сети [6] широко используются для этих задач и входят в число лучших конкурирующих предложений по классификации и ранжированию изображений, таких как ImageNet [11]. Однако, как и многие методы машинного обучения, эти модели часто не имеют прямой интерпретации предсказаний классификатора. Другими словами, классификатор действует как черный ящик и не предоставляет подробной информации о том, почему он достигает определенного решения классификации. То есть возможность интерпретации фиг. 15 недоступна.

Этот недостаток интерпретируемости обусловлен нелинейностью различных отображений, которые обрабатывают пикселы необработанных изображений в их представление признаков и из них в конечную функцию классификатора. Это является значительным недостатком в приложениях классификации, поскольку это мешает эксперту-человеку тщательно проверять решение классификации. Простой ответ ʺдаʺ или ʺнетʺ иногда имеет ограниченное значение в приложениях, где такие вопросы, как, где что-то происходит или как это структурировано, являются более релевантными, чем двоичная или действительнозначная одномерная оценка простого присутствия или отсутствия определенной структуры.

Несколько работ посвящены теме объяснения нейронных сетей. Работа [54] посвящена анализу решений классификаторов в нейронах, применимых также к пиксельному уровню. Здесь выполняется послойная инверсия вниз от выходных уровней к входным пикселам для архитектуры сверточных сетей [23]. Эта работа специфична для архитектуры сверточных нейронных сетей со слоями нейронов с выпрямленными линейными активационными функциями. См. [42], где устанавливается интерпретация работы в [54] как приближение к частным производным относительно пикселов во входном изображении. В высокоуровневом смысле, работа в [54] использует метод из своей собственной предшествующей работы в [55], которая решает задачи оптимизации, чтобы восстановить вход изображения, как проецировать отклики в направлении к входам, [54] использует выпрямленные линейные блоки, чтобы проецировать информацию из развернутых карт по направлению к входам с одной целью - гарантировать, что карты признаков будут неотрицательными.

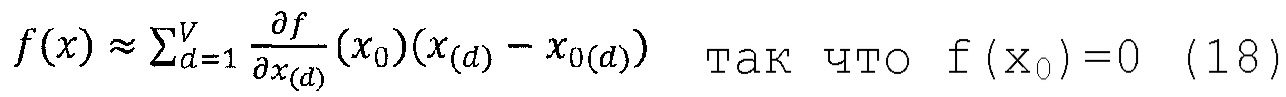

Другой подход, лежащий между частными производными во входной точке x и полным рядом Тейлора вокруг другой точки x0, представлен в [42]. Эта работа использует точку x0 иную, чем входная точка x, для вычисления производной и остаточного смещения, которые не заданы дополнительно, но избегает по неопределенной причине использования полного линейного весового члена x-x0 ряда Тейлора. Количественное определение входных переменных с использованием модели нейронной сети также изучалось в конкретных областях, таких как экологическое моделирование, где [16, 34] исследовали большой ансамбль возможных анализов, включая вычисления частных производных, анализ возмущений, анализ весов и изучение влияния включения и удаления переменных во время обучения. Другой подход к пониманию решений в нейронной сети заключается в том, чтобы подгонять более интерпретируемую модель (например, дерево решений) к функции, на которой обучается нейронная сеть [41], и извлекать правила, изученные этой новой моделью.

Тем не менее, по-прежнему существует потребность в надежной, простой в реализации и широко применимой концепции для реализации задачи назначения оценки релевантности для искусственных нейронных сетей.

Соответственно, задачей настоящего изобретения является предоставление концепции для назначения оценки релевантности набору элементов, к которым применяется искусственная нейронная сеть, каковая концепция применима к более широкому набору искусственных нейронных сетей и/или снижает вычислительные усилия.

Эта задача решается предметом независимых пунктов формулы изобретения.

Основное новшество настоящей заявки состоит в том, что задача назначения оценки релевантности набору элементов, к которым применяется искусственная нейронная сеть, может быть получена путем перераспределения начального значения релевантности, полученного из выхода сети, на набор элементов посредством обратного распространения начальной оценки релевантности через искусственную нейронную сеть, чтобы получить оценку релевантности для каждого элемента. В частности, это обратное распространение применимо к более широкому набору искусственных нейронных сетей и/или при более низких вычислительных затратах, за счет выполнения его таким образом, что, для каждого нейрона, предварительно перераспределенные оценки релевантности набора соседних вниз по потоку (нисходящих) нейронов соответствующего нейрона распределяются по набору соседних вверх по потоку (восходящих) нейронов соответствующего нейрона в соответствии с функцией распределения.

Предпочтительные реализации и применения настоящего изобретения в соответствии с различными вариантами осуществления являются предметом зависимых пунктов формулы изобретения, и предпочтительные варианты осуществления настоящей заявки описаны ниже более подробно в отношении фигур, среди которых

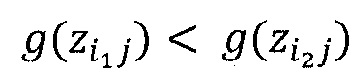

Фиг. 1а показывает схему примера предсказания с использованием искусственной нейронной сети, к которой может быть применено назначение оценки релевантности с использованием обратного распространения в соответствии с вариантами осуществления настоящего изобретения;

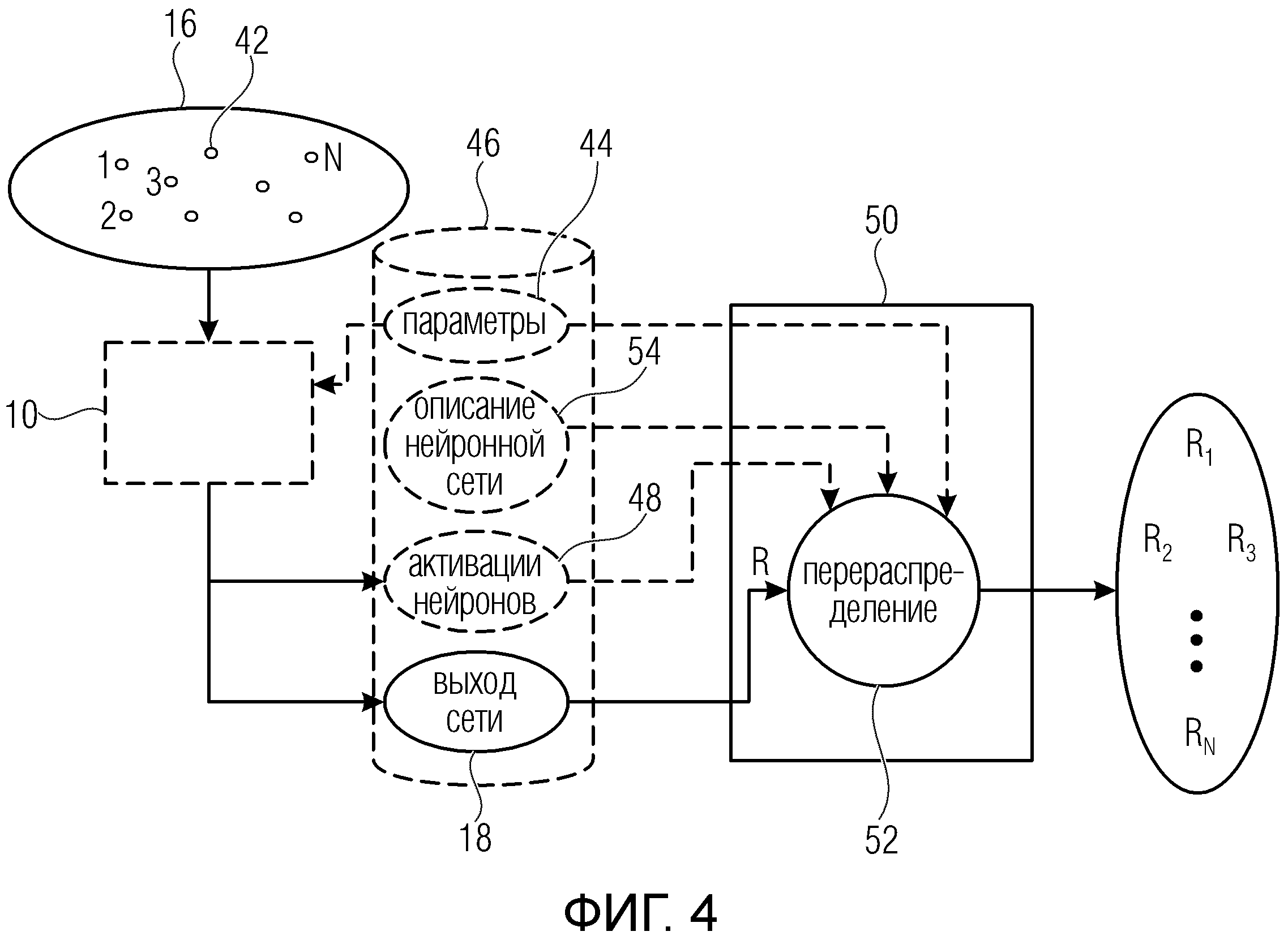

Фиг. 2а показывает схему, иллюстрирующую процесс обратного распространения, используемый в соответствии с вариантами осуществления настоящей заявки, использующими в качестве примера искусственную нейронную сеть, показанную на фиг.1, в качестве основы;

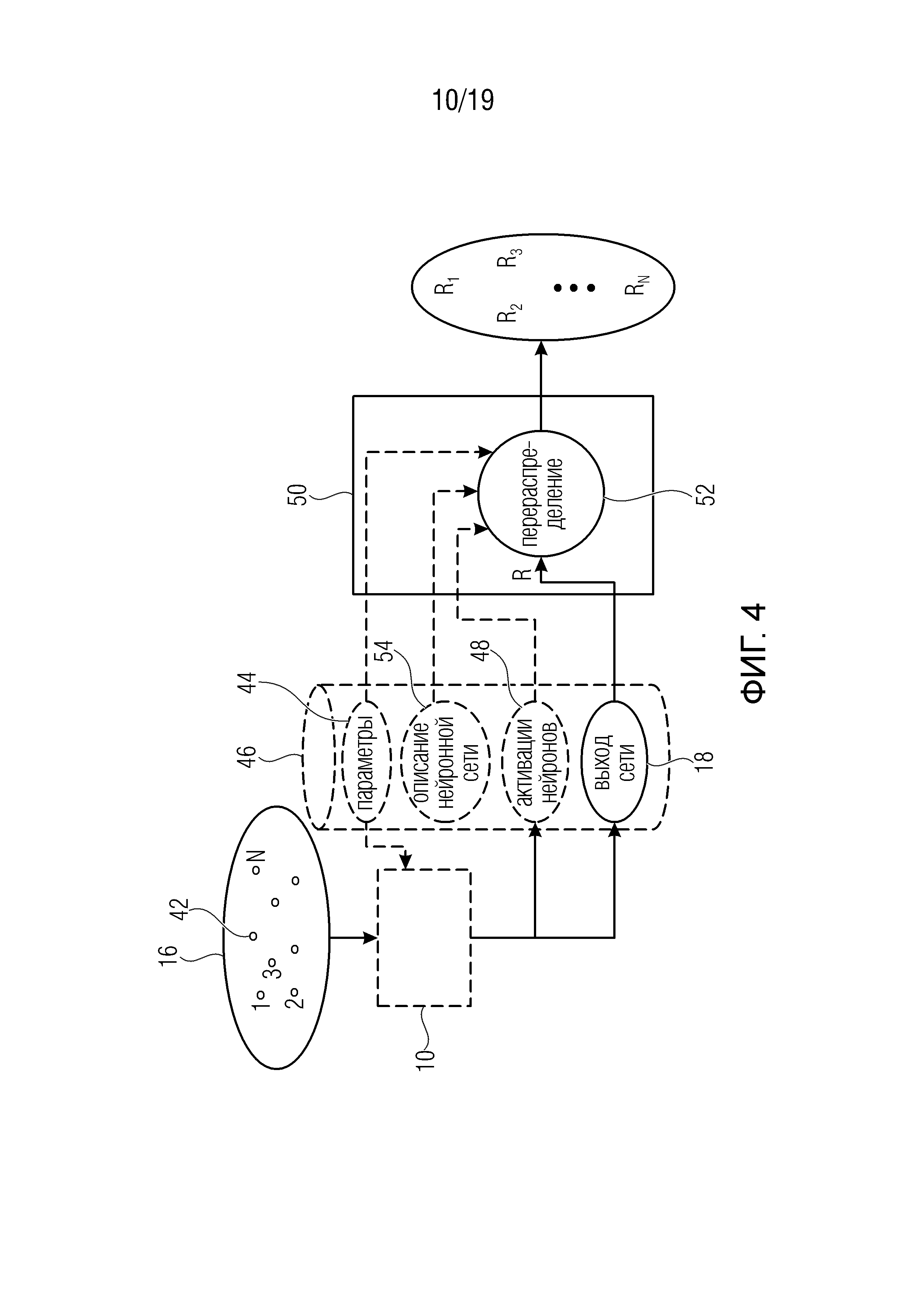

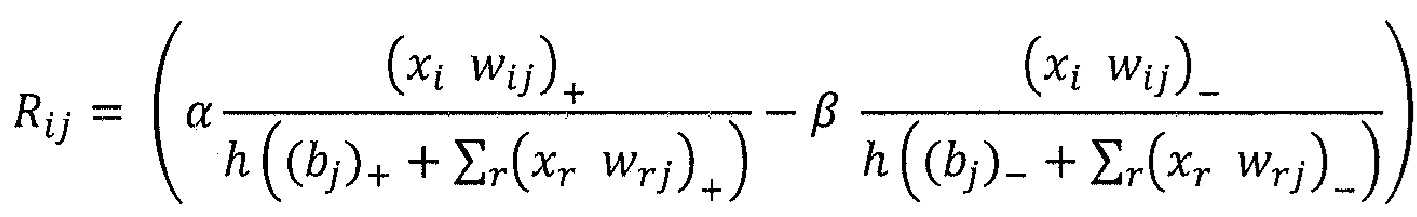

Фиг. 1b и 2b показывают модификацию фиг. 1a и 2a, согласно которой сеть и назначение релевантности действуют на картах признаков, а не на пикселах изображения;

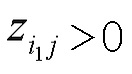

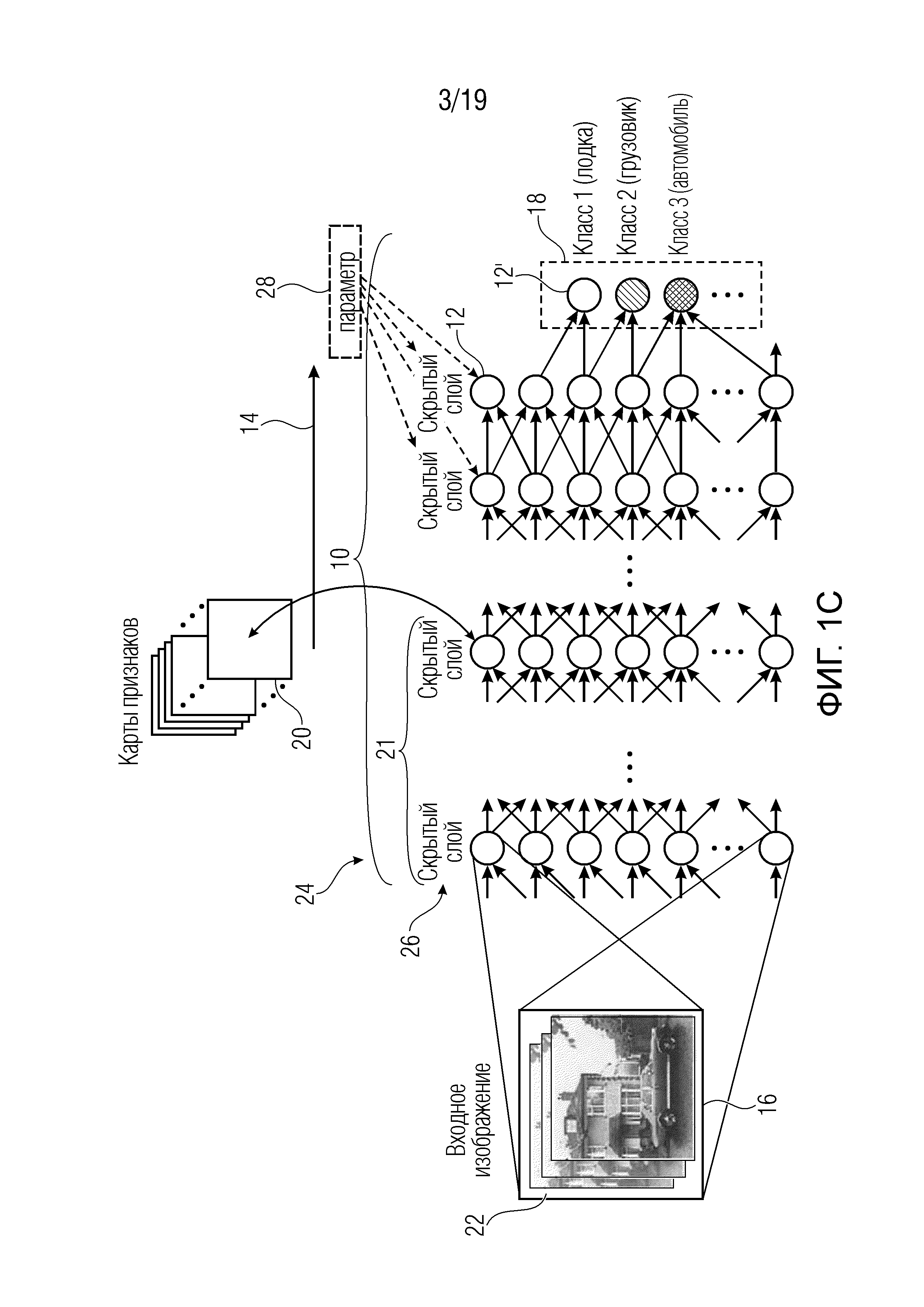

Фиг. 1с и 2с показывают возможность применения фиг. 1а и 2а на цветных изображениях;

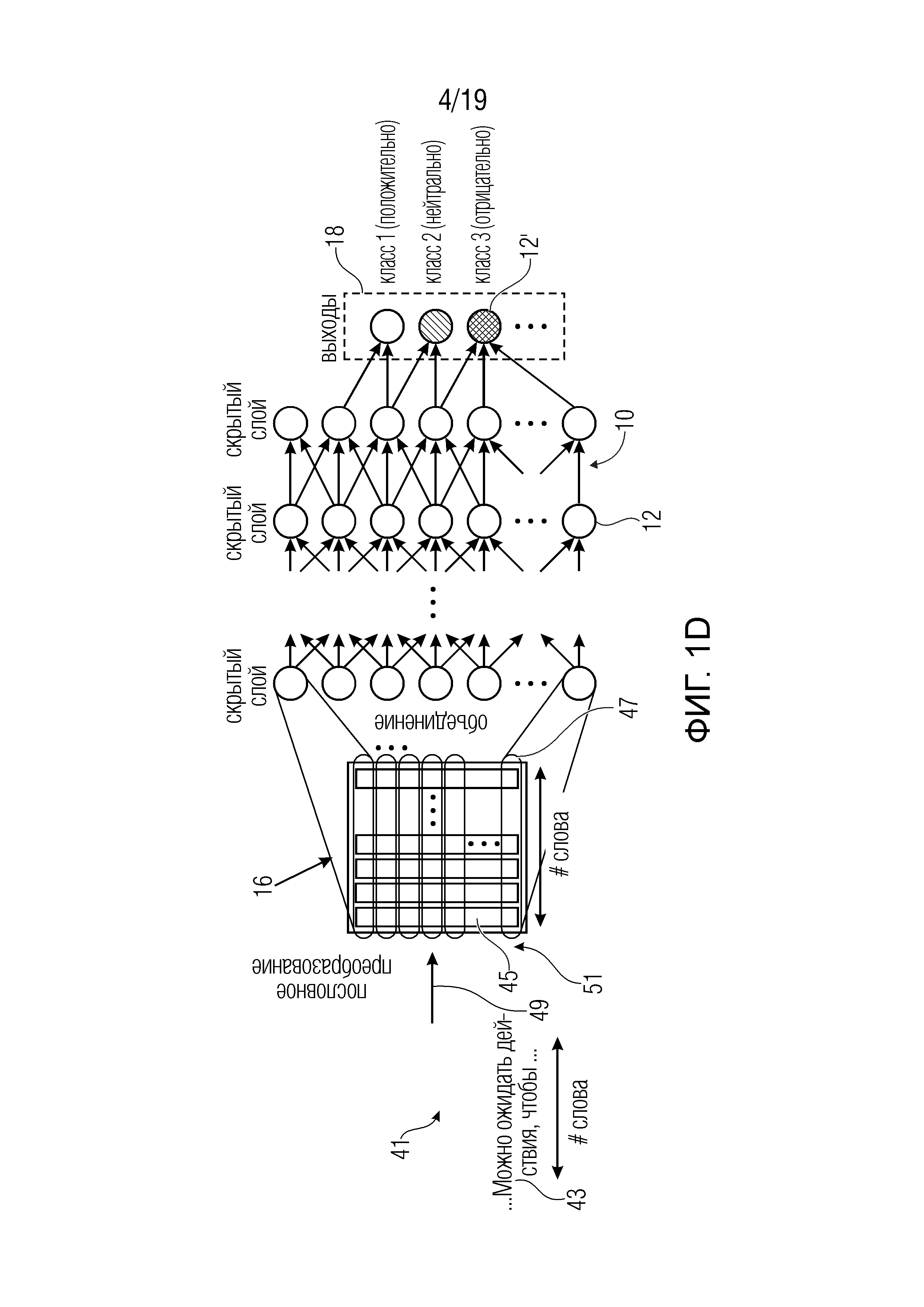

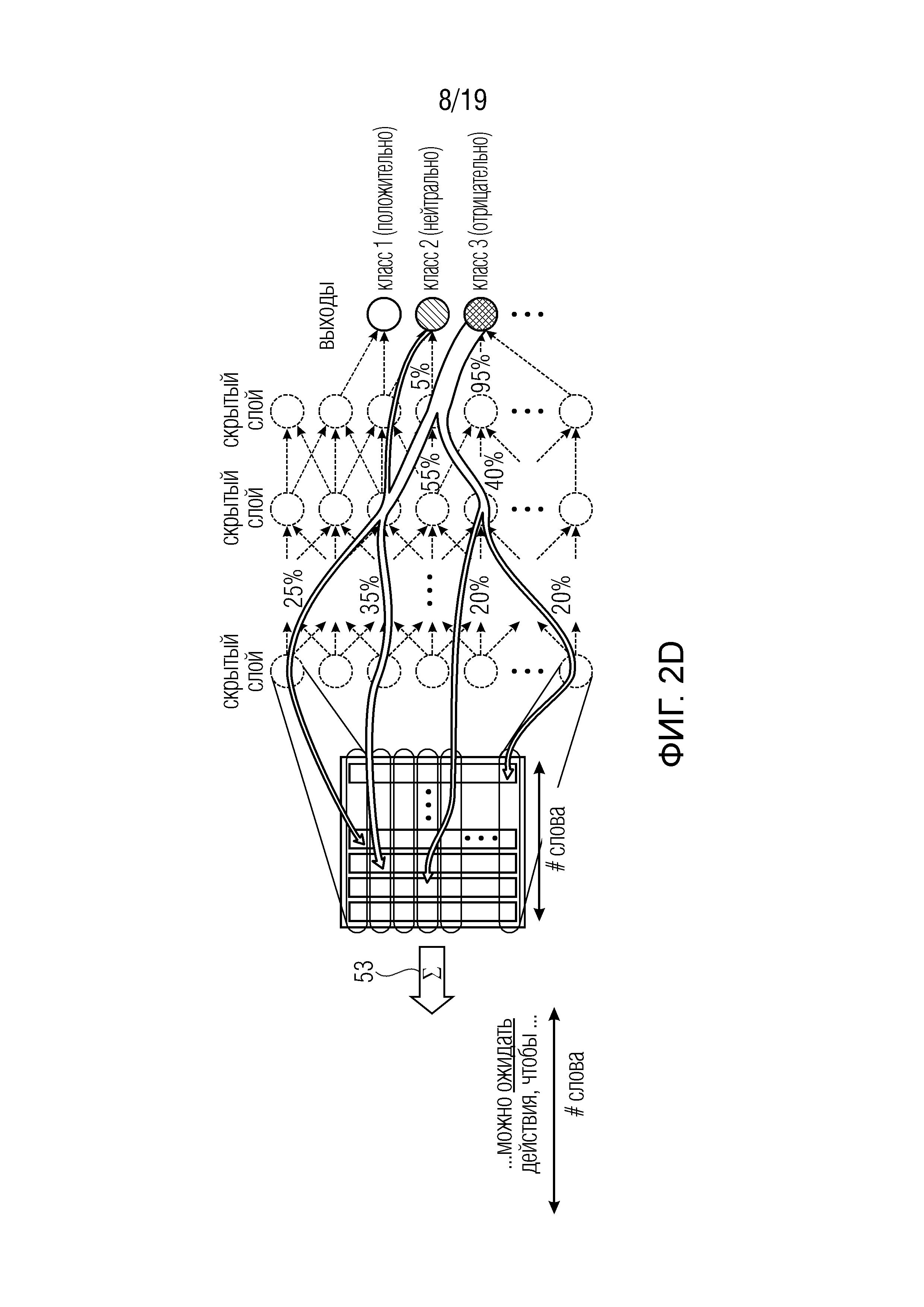

Фиг. 1d и 2d показывают модификацию фиг. 1a и 2a, согласно которым сеть и назначение релевантности действуют на текстах, а не на изображениях;

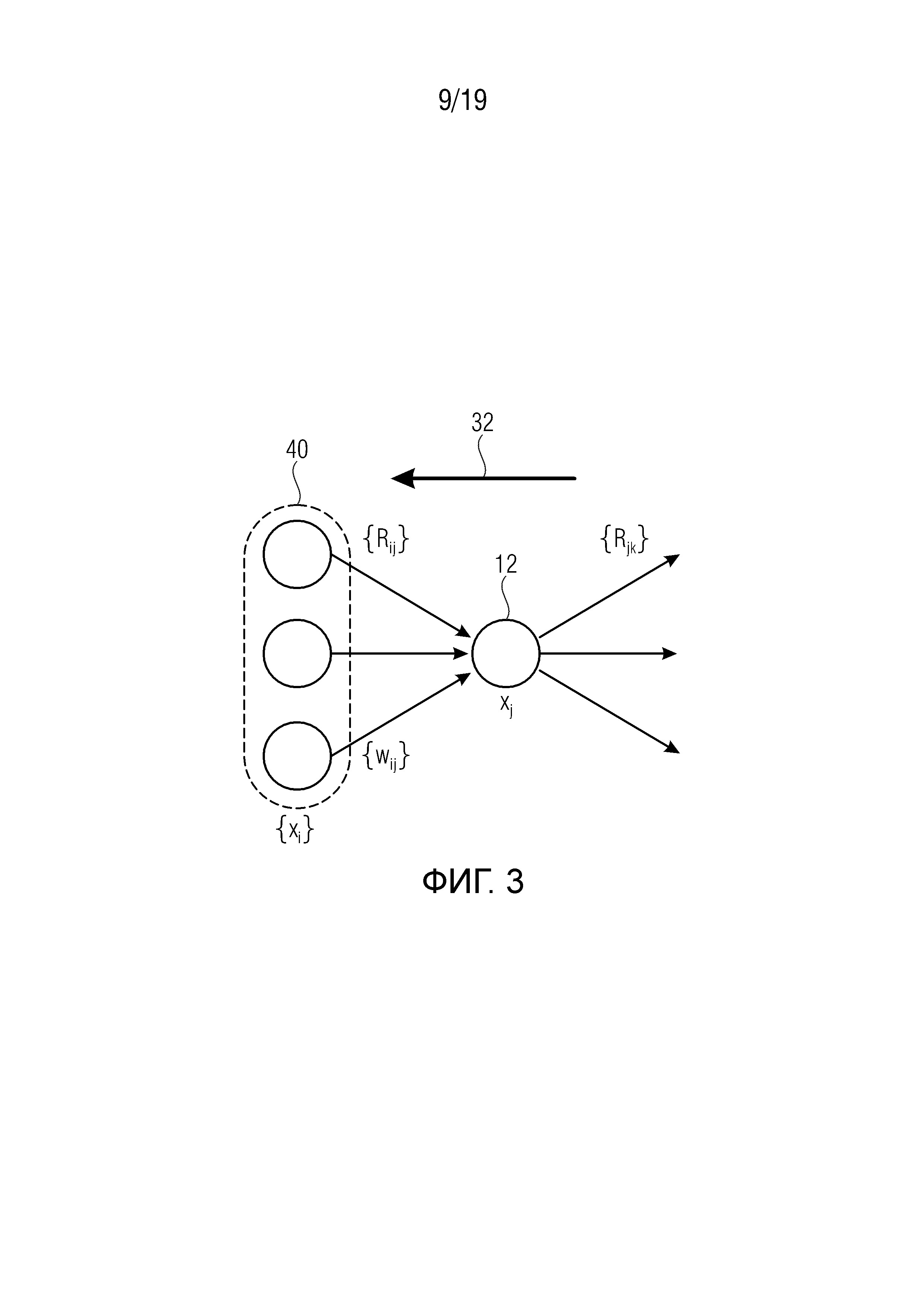

Фиг. 3 схематично иллюстрирует промежуточный нейрон искусственной нейронной сети и его соединение с соседними вверх по потоку (восходящими) и вниз по потоку (нисходящими) нейронами, причем также показаны три восходящих соседних нейрона;

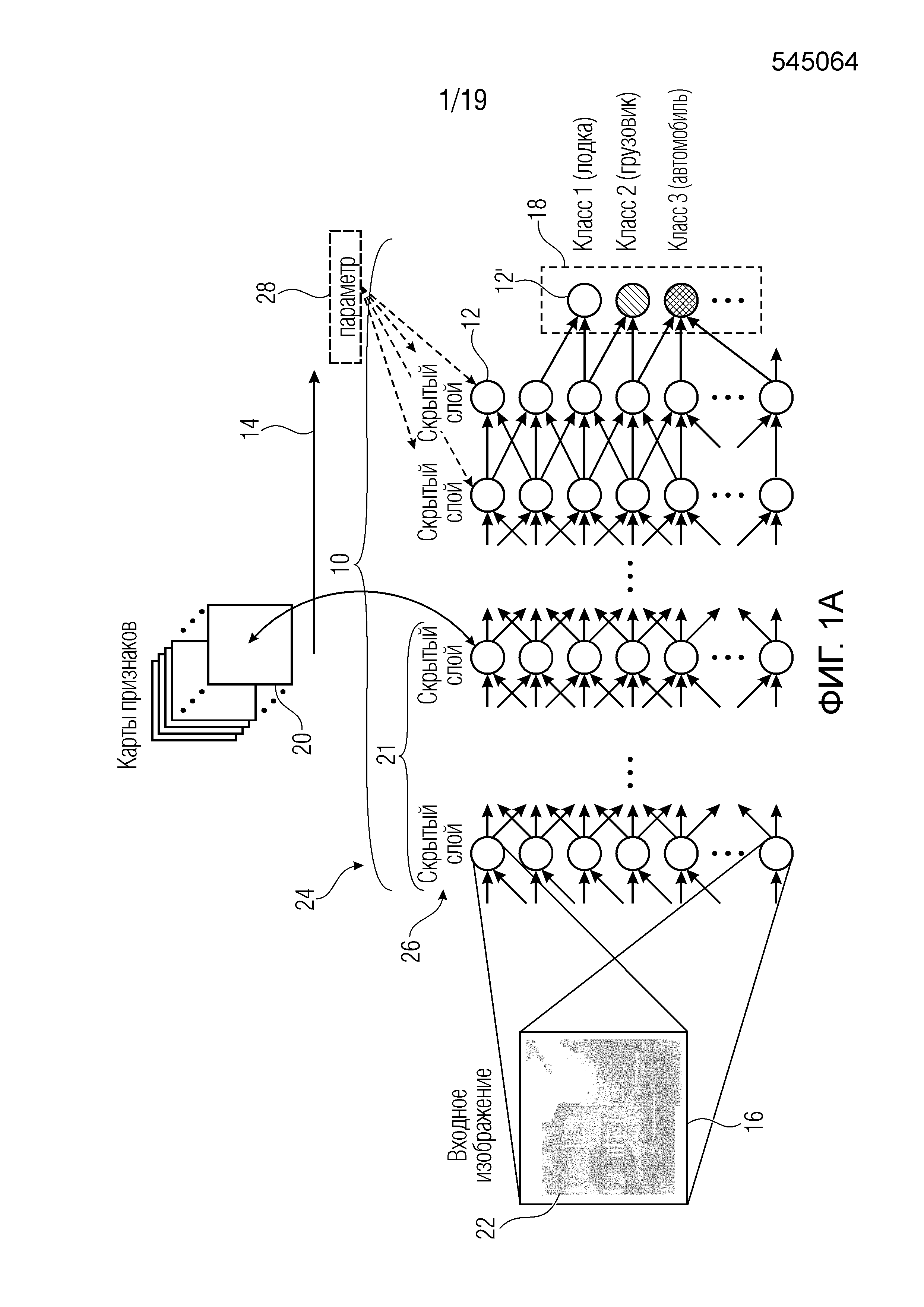

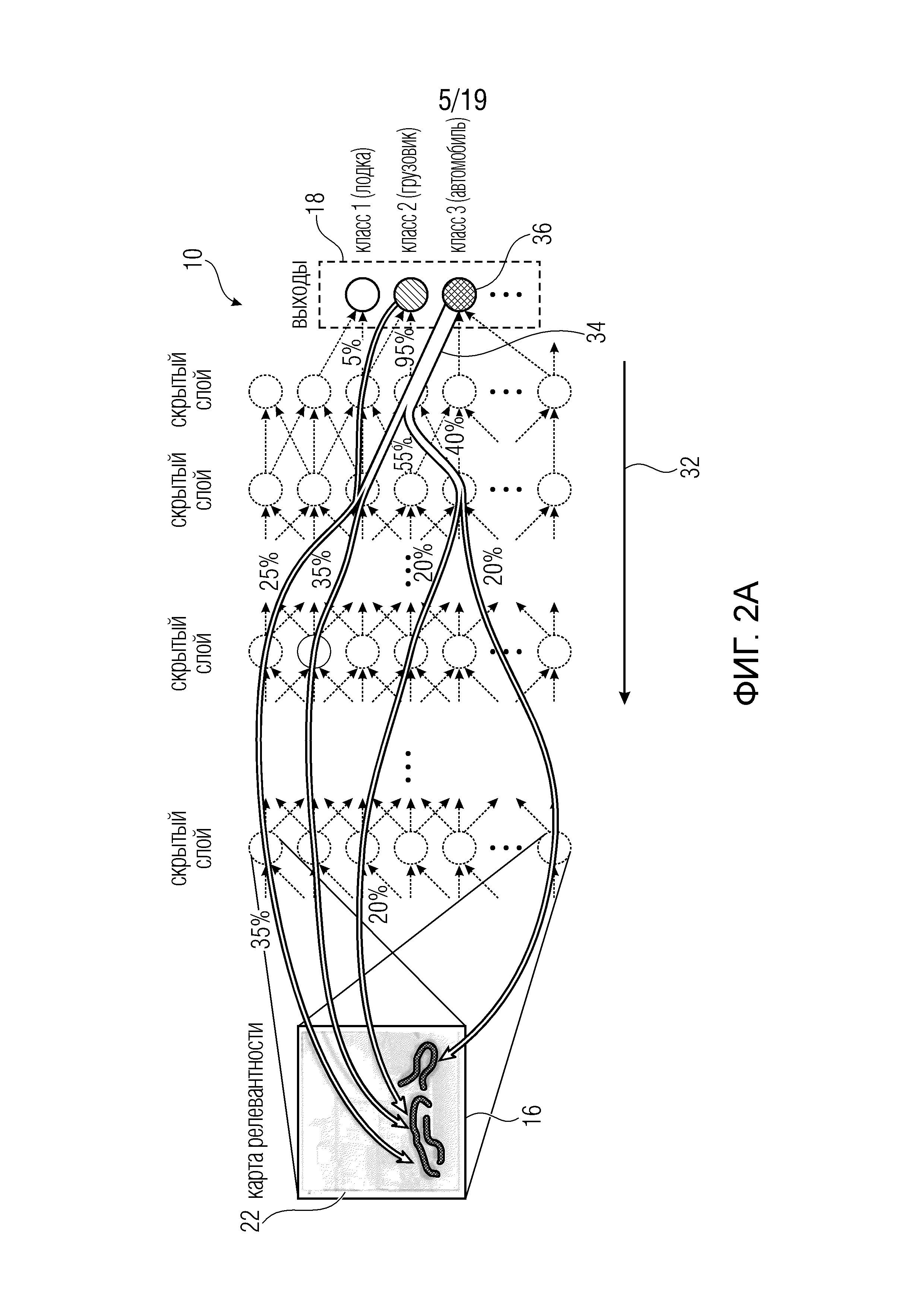

Фиг. 4 показывает блок-схема устройства для назначения значений релевантности множеству элементов в соответствии с вариантом осуществления;

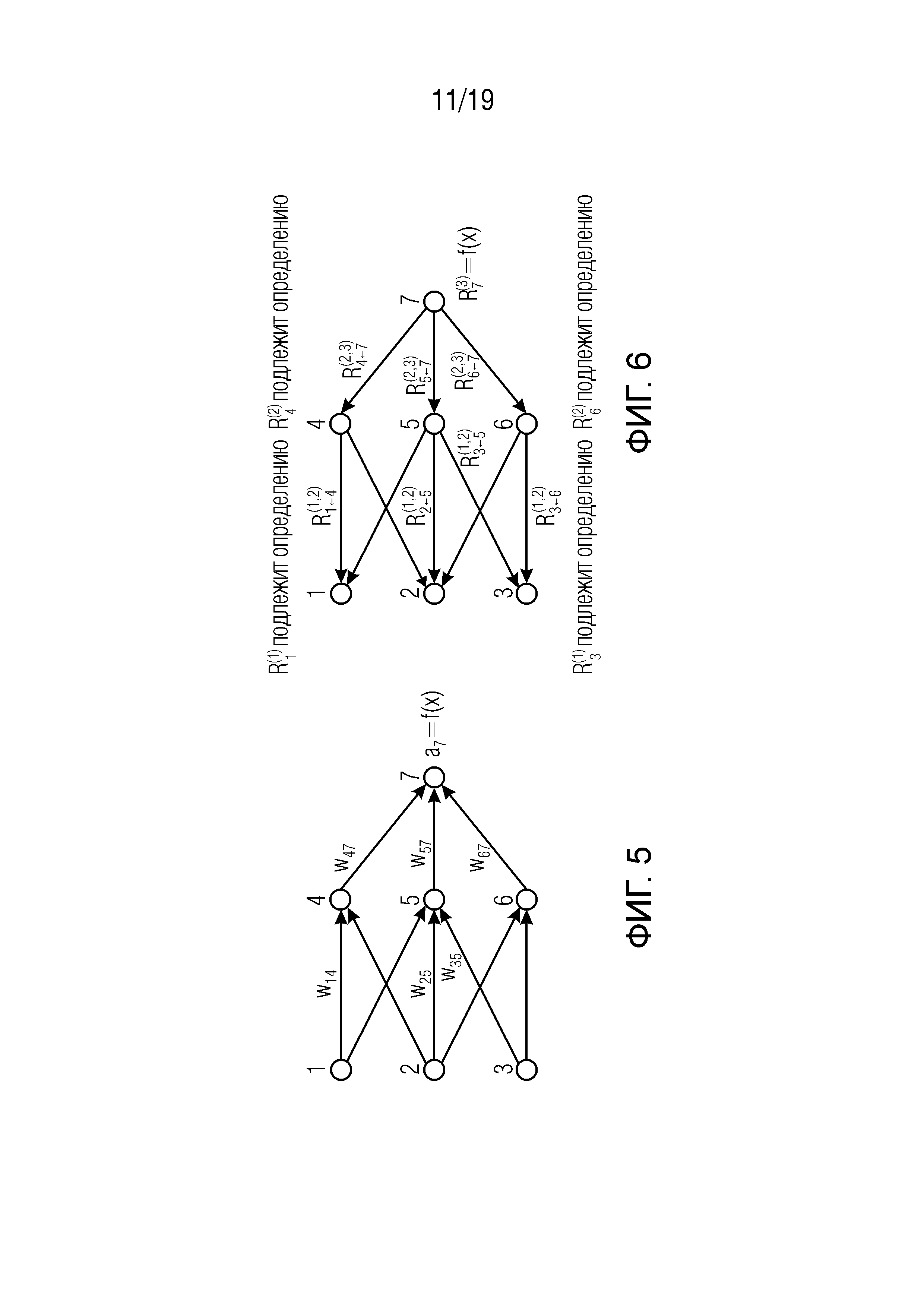

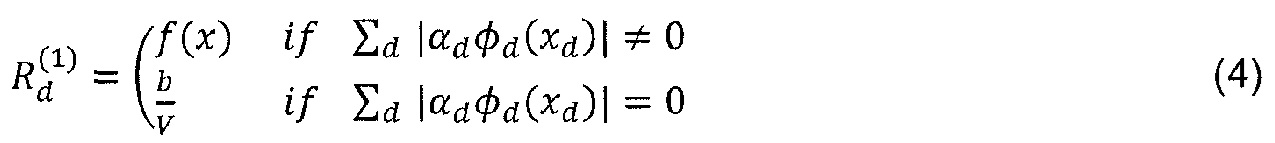

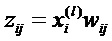

Фиг. 5 показывает классификатор в форме нейронной сети во время предсказания, wij являются весами соединения; ai является активацией нейрона i;

Фиг. 6 показывает классификатор нейронной сети, показанный на фиг.5, в течение времени вычисления послойной релевантности.  является релевантностью нейрона i, которая должна быть вычислена. Чтобы облегчить вычисление

является релевантностью нейрона i, которая должна быть вычислена. Чтобы облегчить вычисление  , вводим сообщения

, вводим сообщения  .

.  - это сообщения, которые необходимо вычислить таким образом, чтобы сохранялась послойная релевантность в уравнении (2). Сообщения отправляются из нейрона i к его входным нейронам j через соединения, используемые для классификации, например, 2 является входным нейроном для нейронов 4, 5, 6. Нейрон 3 является входным нейроном для 5, 6. Нейроны 4, 5, 6 являются входными для нейрона 7;

- это сообщения, которые необходимо вычислить таким образом, чтобы сохранялась послойная релевантность в уравнении (2). Сообщения отправляются из нейрона i к его входным нейронам j через соединения, используемые для классификации, например, 2 является входным нейроном для нейронов 4, 5, 6. Нейрон 3 является входным нейроном для 5, 6. Нейроны 4, 5, 6 являются входными для нейрона 7;

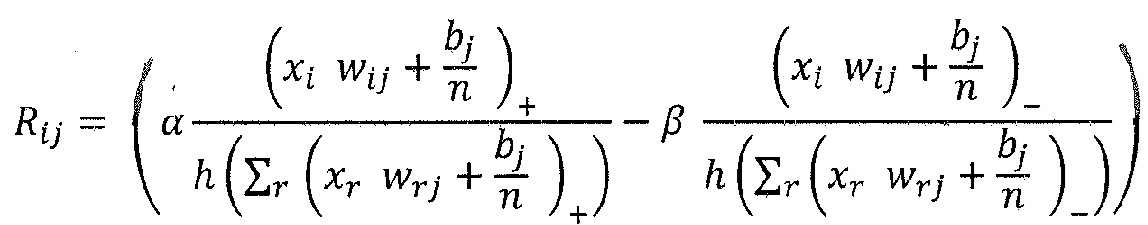

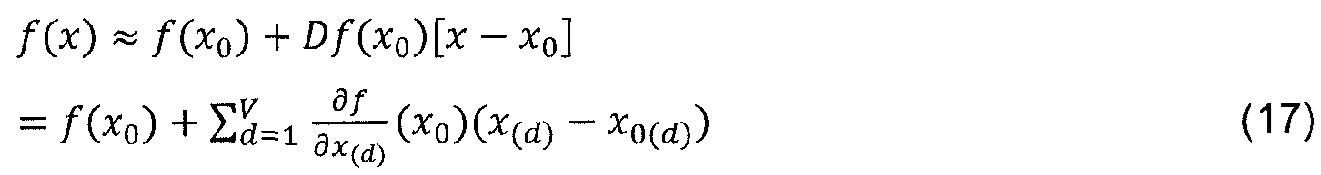

Фиг. 7 показывает примерную действительнозначную функцию предсказания для классификации с пунктирной черной линией, являющейся границей решения, которая отделяет синие точки в области -0.8 от зеленых точек в области 0.6-0.9. Первые точки обозначены отрицательно, последние точки обозначены положительно. На левой стороне изображен локальный градиент функции классификации в точке предсказания, а на правой стороне показана аппроксимация Тейлора относительно корневой точки на границе решения;

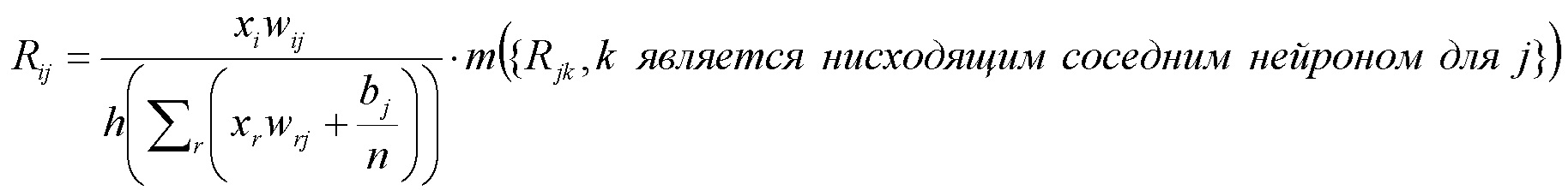

Фиг. 8 иллюстрирует пример для многослойной нейронной сети, аннотированной различными переменными и индексами, описывающими нейроны и взвешенные соединения. Слева: прямой проход. Справа: обратный проход;

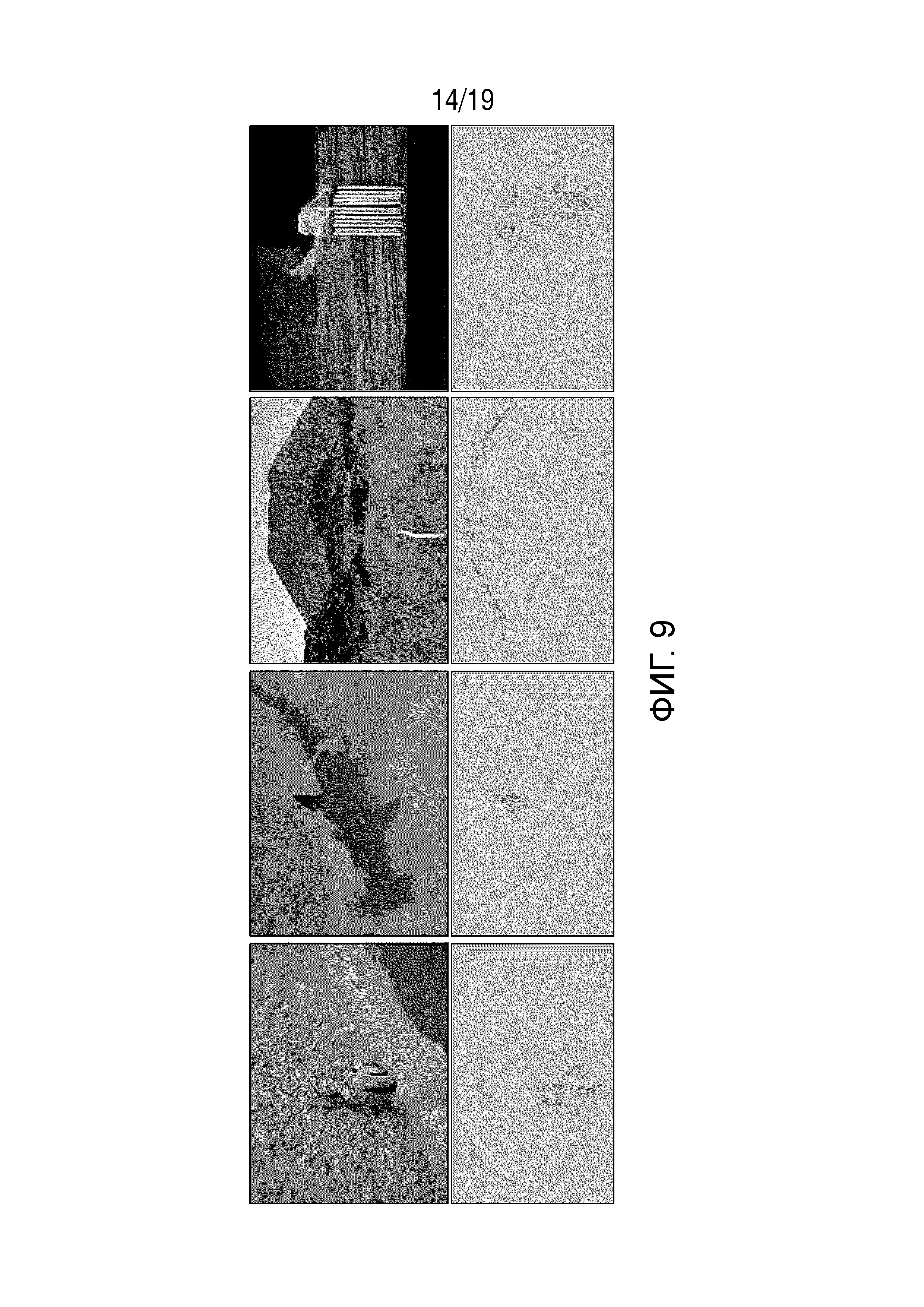

Фиг. 9 иллюстрирует попиксельную декомпозицию для нейронной сети, обученной распознавать 1000 классов из набора данных ImageNet.

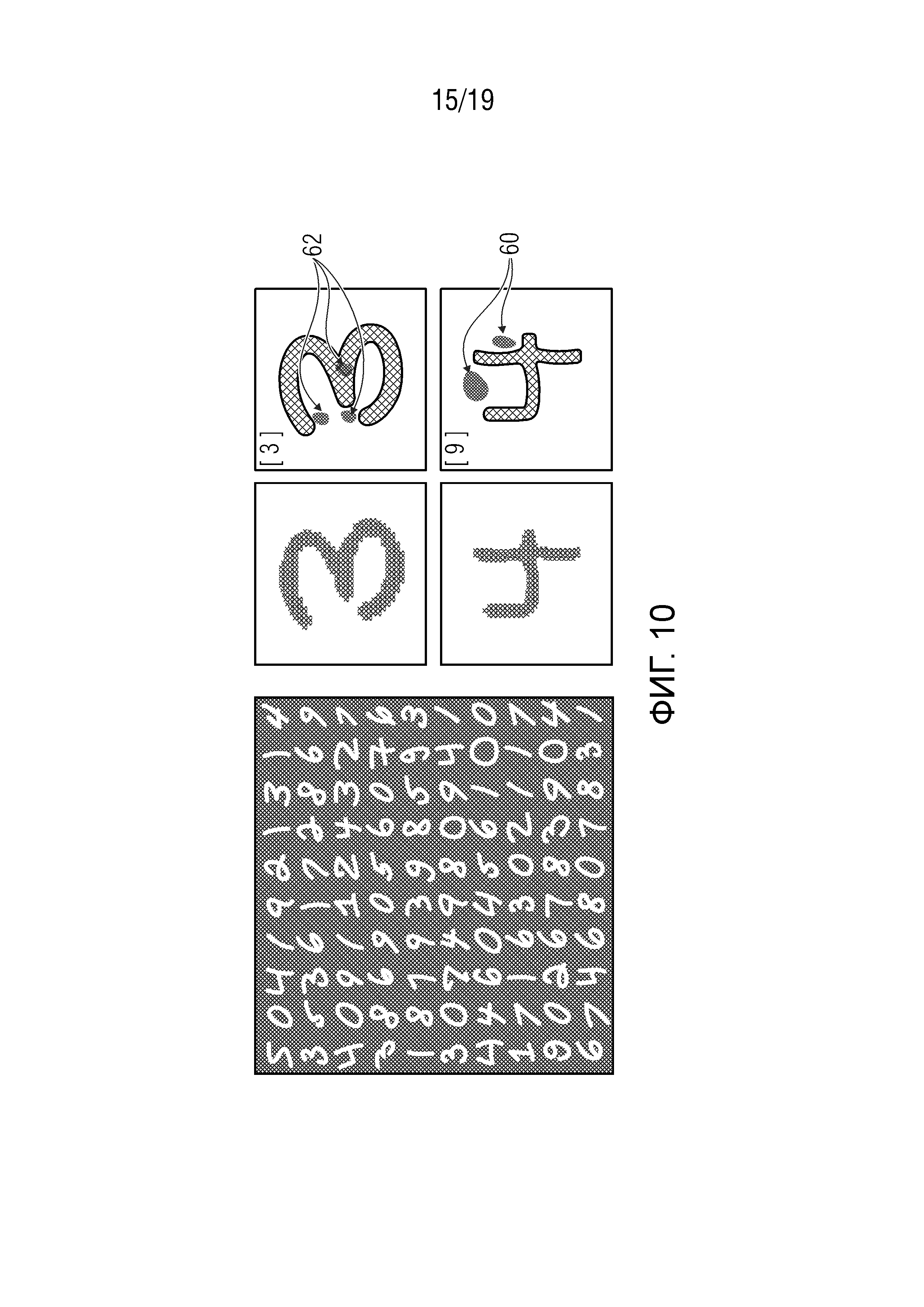

Фиг. 10 показывает эксперимент, согласно которому концепция вариантов осуществления настоящей заявки была применена к набору данных MNIST (Объединенный национальный институт стандартов и технологий), который содержит изображения чисел от 0 до 9, в качестве примера показывая, с правой стороны, тепловые карты, иллюстрирующие в качестве примера части вокруг чисел ʺ3ʺ и ʺ4ʺ, которые имеют высокую релевантность, чтобы распознавать эти числа как ʺ3ʺ и отличить соответствующее число от ʺ9ʺ соответственно;

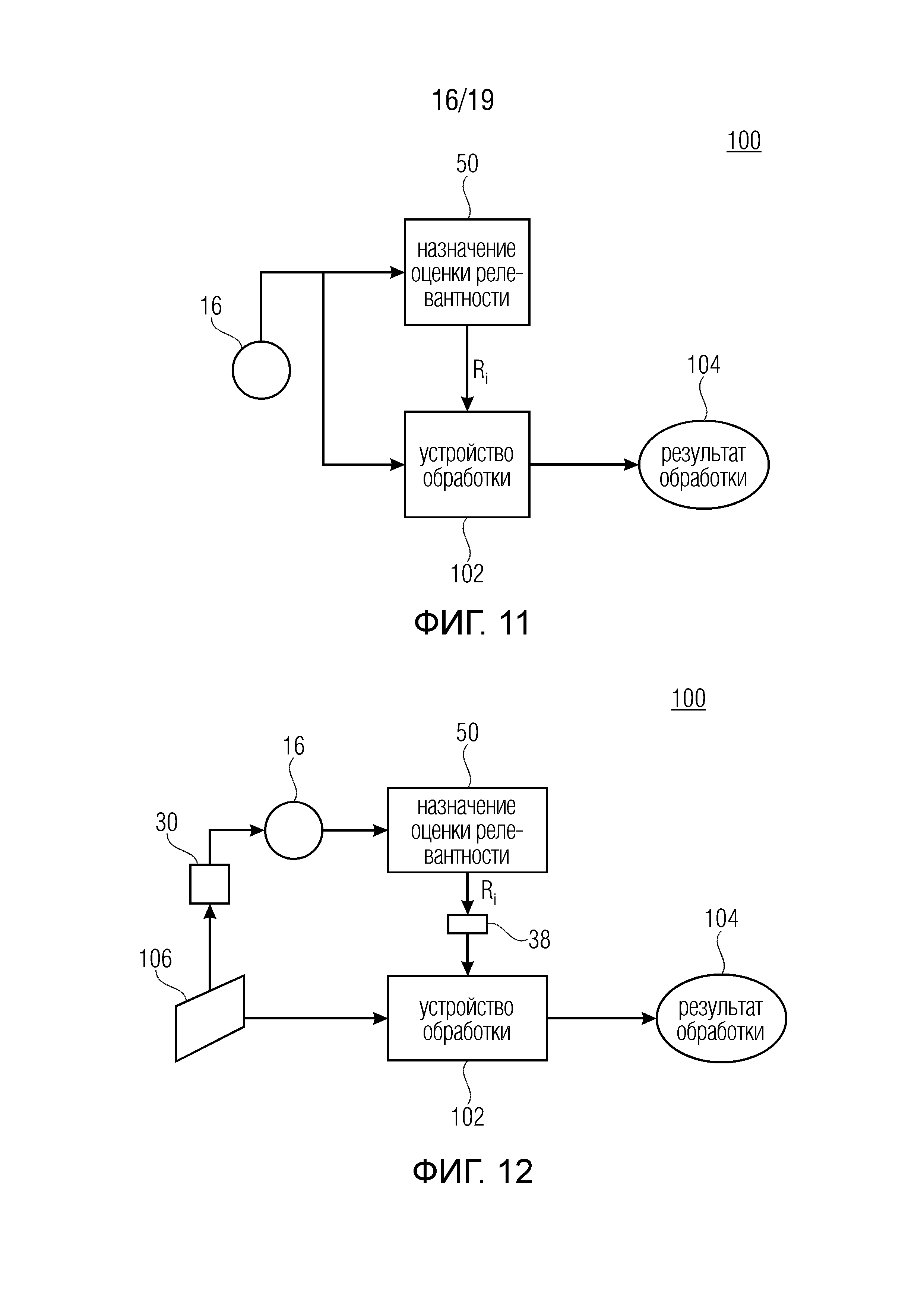

Фиг. 11 показывает блок-схему системы обработки данных в соответствии с вариантом осуществления;

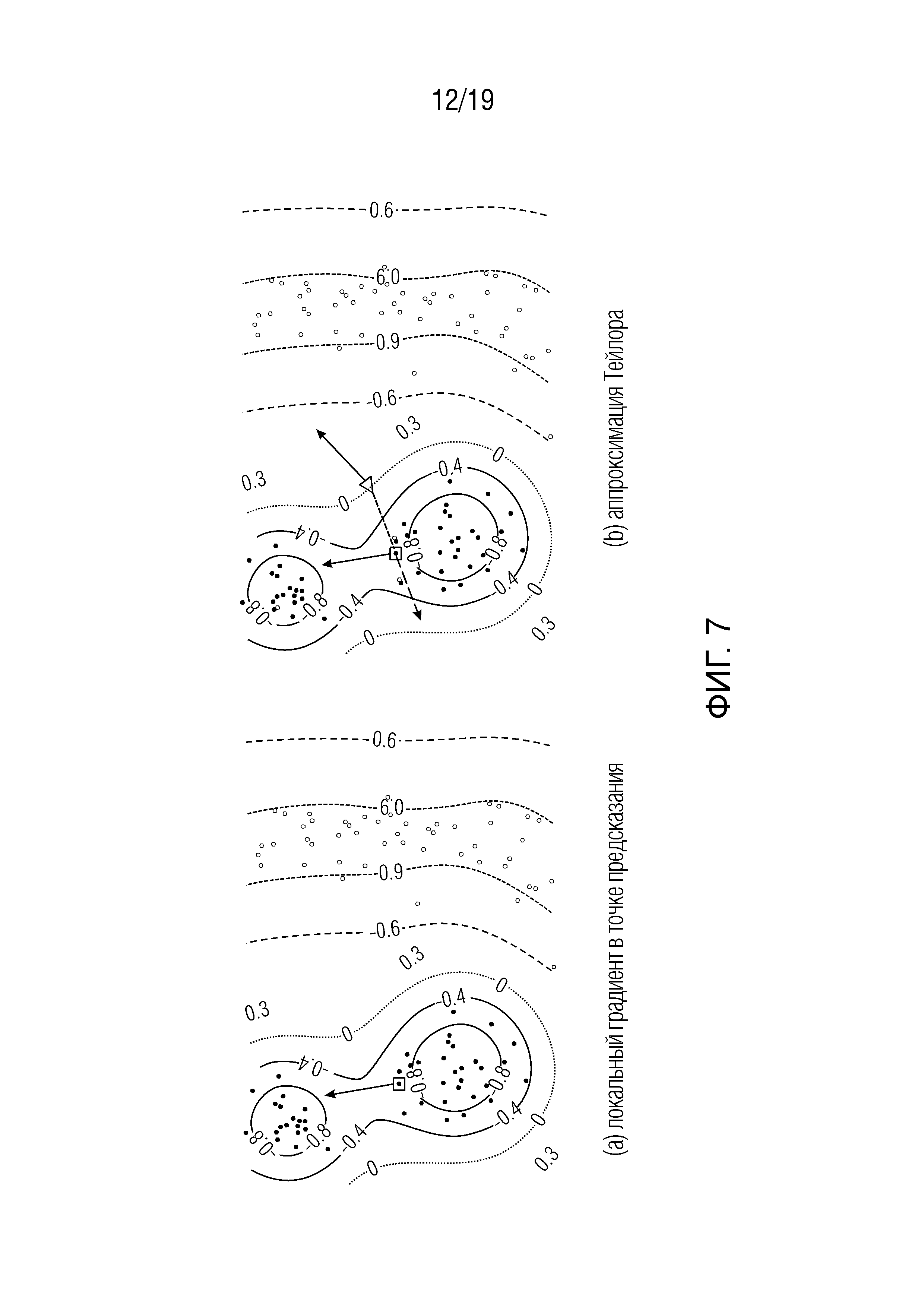

Фиг. 12 показывает блок-схему системы обработки данных в соответствии с вариантом осуществления, отличающимся от фиг. 11, в котором обработка выполняется на данных, из которых был получен набор элементов;

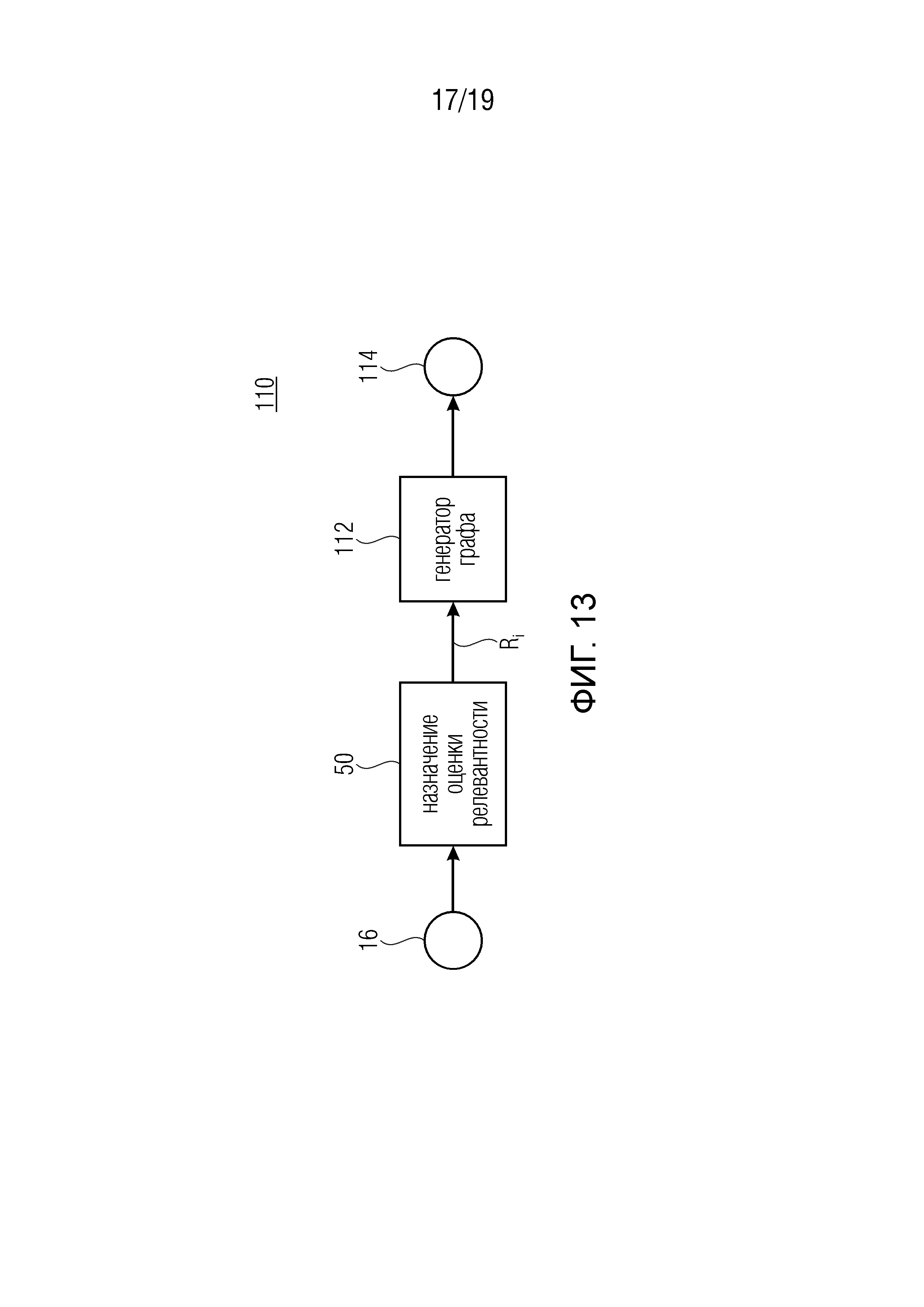

Фиг. 13 показывает блок-схему системы выделения (высвечивания) ROI в соответствии с вариантом осуществления;

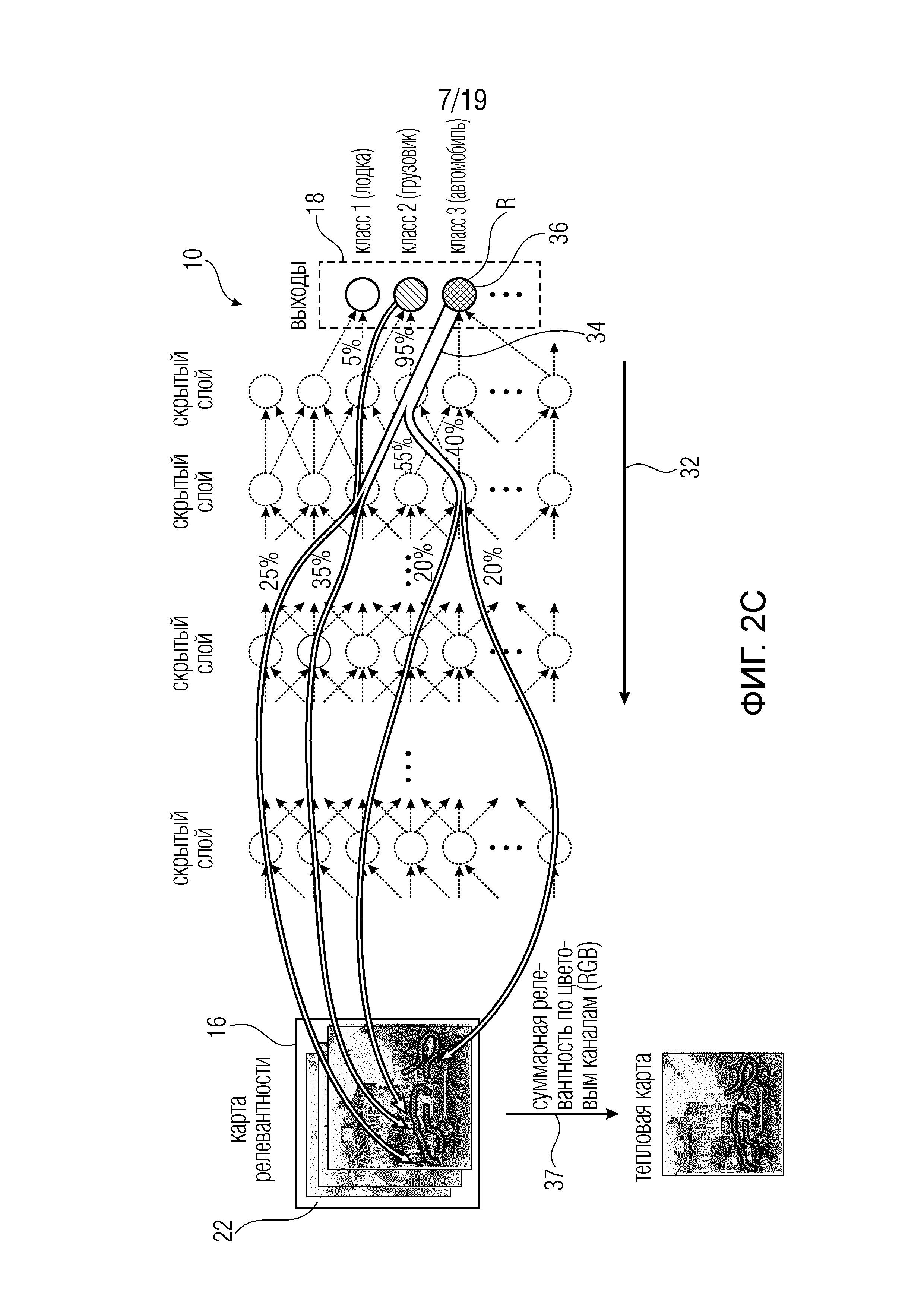

Фиг. 14 показывает систему оптимизации нейронной сети в соответствии с вариантом осуществления; и

Фиг. 15 показывает схему, иллюстрирующую задачу назначения оценки релевантности относительно искусственной нейронной сети и отношение к обычной задаче предсказания искусственной нейронной сети.

Прежде чем описывать различные варианты осуществления настоящей заявки в отношении блок-схем, концепции, лежащие в основе этих вариантов осуществления, в первую очередь должны быть описаны путем краткого введения в искусственные нейронные сети и затем путем объяснения идей, лежащих в основе концепции вариантов осуществления.

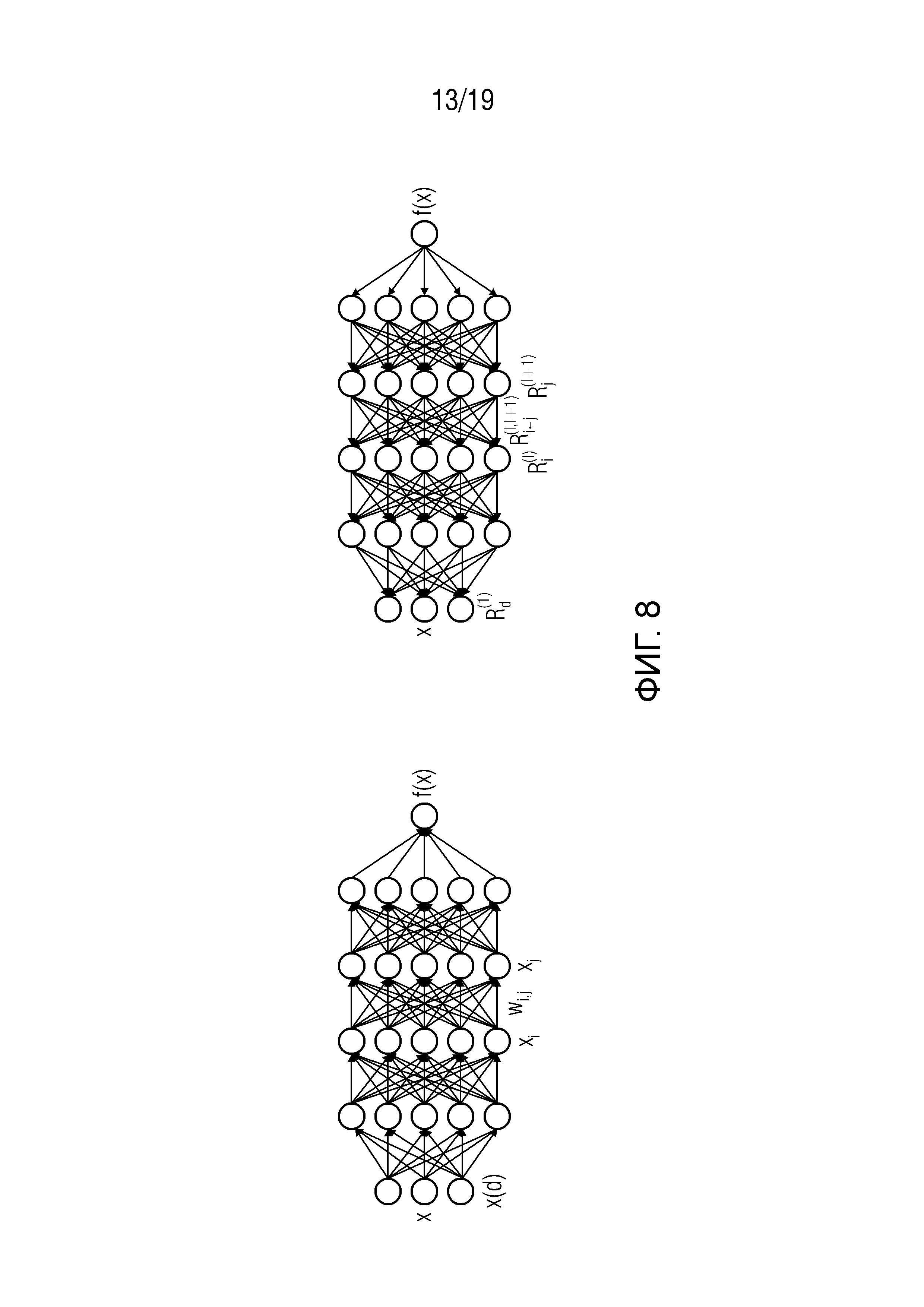

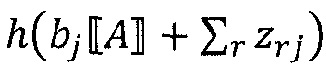

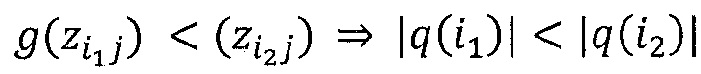

Нейронная сеть представляет собой граф взаимосвязанных нелинейных блоков обработки (процессоров), которые могут обучаться, чтобы аппроксимировать комплексные отображения между входными данными и выходными данными. Отметим, что входными данными является, например, изображение (набор пикселов), а выходом является, например, решение классификации (в простейшем случае +1/-1, что означает ʺдаʺ, в изображении есть акула, или ʺнетʺ, в изображении нет акулы). Каждый нелинейный процессор (или нейрон) состоит из взвешенной линейной комбинации своих входов, к которым применяется нелинейная функция активации. Используя индекс i для обозначения нейронов, входящих в нейрон с индексом j, нелинейная функция активации определяется как:

где g(⋅) - нелинейная монотонно возрастающая функция активации, wij - вес, связывающий нейрон i с нейроном j, и bj - член смещения. Нейронная сеть определяется ее структурой связности, ее нелинейной функцией активации и ее весами.

В нижеследующих вариантах осуществления используется концепция, которая может называться и называется в последующем описании распространением релевантности. Она перераспределяет доказательство (основание) для конкретной структуры в данных, как моделируется выходными нейронами, обратно на входные нейроны. Таким образом, она стремится дать объяснение своего собственного предсказания с точки зрения входных переменных (например, пикселов). Отметим, что эта концепция работает для любого типа (не имеющей петель) нейронной сети, независимо от количества слоев, типа функции активации и т.д. Таким образом, ее можно применять ко многим популярным моделям, так как многие алгоритмы могут быть описаны в терминах нейронных сетей.

Ниже приведена иллюстрация процедуры распространения релевантности для сети, состоящей из слоев свертки/субдискретизации, за которыми следует последовательность полностью связанных слоев.

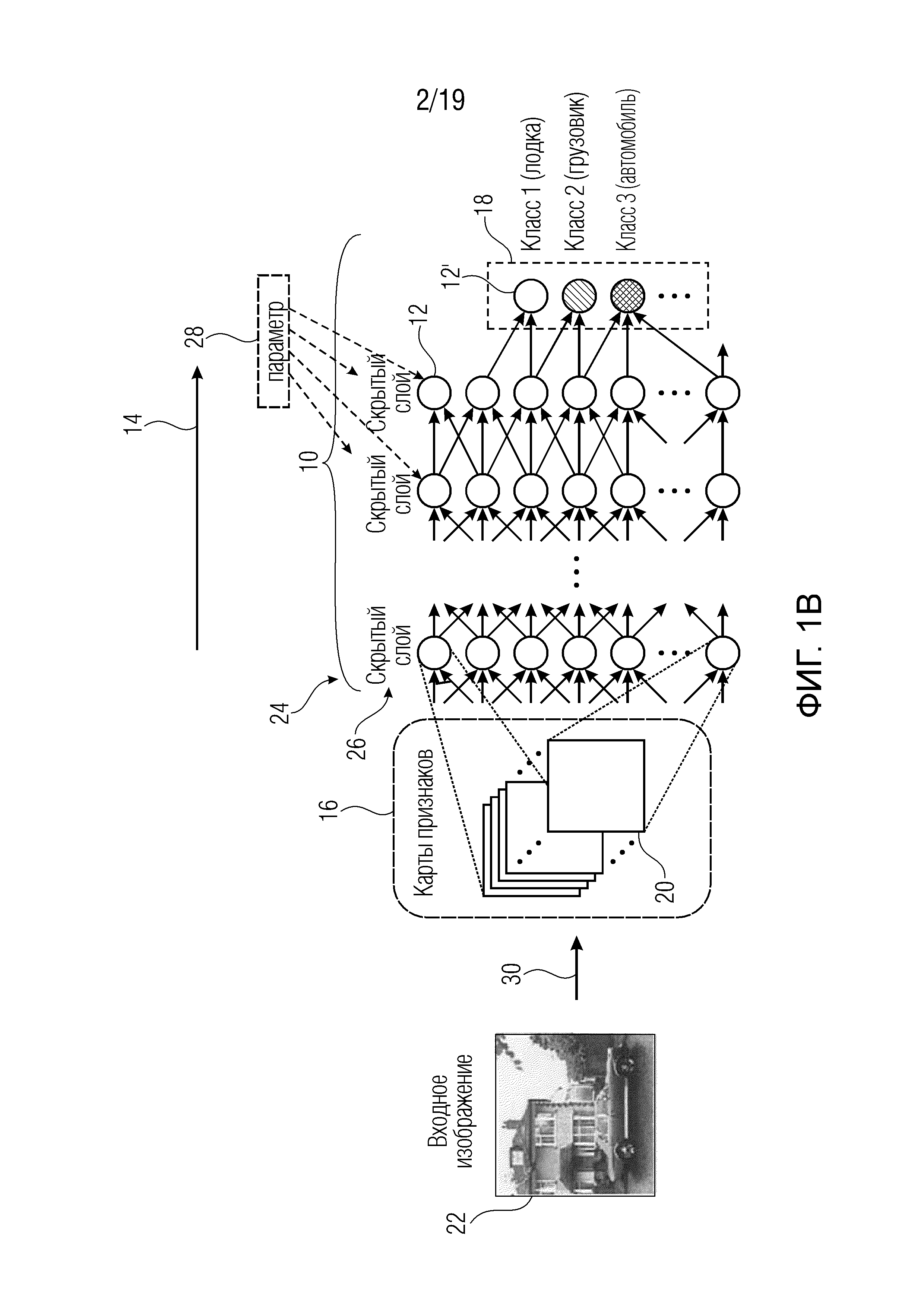

В частности, фиг. 1а показывает пример искусственной нейронной сети упрощенным примерным образом. Искусственная нейронная сеть 10 состоит из нейронов 12, которые изображены на фиг. 1 как круги. Нейроны 12 взаимосвязаны друг с другом или взаимодействуют друг с другом. Как правило, каждый нейрон соединен с расположенными ниже по потоку (нисходящими) соседними (или последующими) нейронами, с одной стороны, и расположенными выше по потоку (восходящими) соседними (или предшествующими) нейронами, с другой стороны. Термины ʺвосходящийʺ, ʺпредшествующийʺ, ʺнисходящийʺ и ʺпоследующийʺ относятся к общему направлению 14 распространения, вдоль которого работает нейронная сеть 10, когда она применяется к набору 16 элементов, чтобы отображать набор 16 элементов на выход 18 сети, то есть выполнять предсказание.

Как показано на фиг. 1а, набор 16 элементов может, например, быть набором пикселов 22, формирующих изображение путем ассоциирования каждого пиксела с пиксельным значением, соответствующим цвету или интенсивности сцены, в пространственном местоположении, соответствующем положению соответствующего пиксела в массиве пикселов изображения 22. В этом случае, набор 16 представляет собой упорядоченный набор элементов, а именно, массив пикселов. В этом случае, элементы будут соответствовать отдельным пиксельным значениям, т.е. каждый элемент будет соответствовать одному пикселу. Дальше будет пояснено, что настоящая заявка не ограничивается полем изображений. Скорее, набор 16 элементов может представлять собой набор элементов без какого-либо порядка, определенного среди элементов. Комбинации между ними также могут иметь место.

Первый или самый нижний слой 24 нейронов 12 образует своего рода вход искусственной нейронной сети 10. То есть, каждый нейрон 12 этого нижнего слоя 24 принимает в качестве своих входных значений по меньшей мере поднабор из набора 16 элементов, то есть, по меньшей мере поднабор пиксельных значений. Объединение поднаборов элементов из набора 16, значения которых вводятся в некоторый нейрон 12 нижнего слоя 24, равно, например, набору 16, т.е., в случае фиг. 1а всему изображению 22. Иными словами, для каждого элемента набора 16, его значение вводится по меньшей мере в один из нейронов 12 нижнего слоя 24.

На противоположной стороне нейронной сети 10, то есть на ее нисходящей/выходной стороне, сеть 10 содержит один или несколько выходных нейронов 12', которые отличаются от нейронов 12 тем, что у первых нет нисходящих соседних/последующих нейронов. После применения к набору 16 и после завершения обработки, значения, хранящиеся в каждом выходном нейроне 12', образуют выход 18 сети. То есть, выход сети может, например, быть скаляром. В этом случае будет присутствовать только один выходной нейрон 12', и его значение после операции сети 10 будет формировать выход сети. Как проиллюстрировано на фиг. 1, такой выход сети может, например, быть мерой вероятности того, что набор 16 элементов, то есть в случае фиг. 1a изображение 22, принадлежит к определенному классу или нет. Выход 18 сети может, однако, альтернативно быть вектором. В этом случае существует более одного выходного нейрона 12', и значение каждого из этих выходных нейронов 12', как получено в конце операции сети 10, формирует соответствующий компонент выходного вектора сети. На фиг. 1 показано, например, что каждый компонент выхода 18 сети является мерой, измеряющей вероятность того, что набор 16 принадлежит к соответствующему классу, ассоциированному с соответствующим компонентом, например, к классу изображений ʺпоказывающих лодкуʺ, ʺпоказывающих грузовикʺ и ʺпоказывающих автомобильʺ. Другие примеры также возможны и будут представлены ниже.

Таким образом, суммируя вышеизложенное, нейронная сеть включает в себя нейроны 12, связанные между собой, чтобы отображать, в операции прямого распространения или нормальной операции, набор 16 элементов на нейронный выход. Подобно выходным нейронам 12', значение которых в конце операции сети формирует выход 18 сети, элементы набора 16, то есть пикселы изображения 22 в примерном случае фиг. 1a, могут рассматриваться как входные нейроны сети 10 с нейронами 12 и слоями, образованными при этом, являющимися промежуточными нейронами или промежуточными слоями, соответственно. В частности, входные нейроны могут соответственно рассматриваться как восходящие соседние или предшествующие нейроны промежуточных нейронов 12, а именно, таковых из слоя 24, так же как выходные нейроны 12' могут образовывать нисходящие соседние/последующие нейроны промежуточных нейронов 12, образующих, например, самый высокий промежуточный слой сети 10 или, если интерпретировать один или несколько выходных нейронов 12' как образующие самый верхний слой сети 10, второй по высоте слой сети 10.

Фиг. 1 показывает упрощенный пример нейронной сети 10, согласно которому нейроны 12 сети 10 строго упорядочены в слоях 26 в том смысле, что слои 26 образуют последовательность слоев с восходящими соседними/последующими нейронами определенного нейрона 12, все из которых являются членами непосредственно более низкого слоя относительно слоя, к которому принадлежит соответствующий нейрон 12, и все нисходящие соседние/последующие нейроны являются членами непосредственно более высокого слоя. Однако фиг. 1 не следует истолковывать как ограничение типа нейронных сетей 10, к которым могут быть применены варианты осуществления настоящего изобретения, описанные далее ниже, в отношении этой проблемы. Скорее, это строго многослойное расположение нейронов 12 может быть модифицировано в соответствии с альтернативными вариантами осуществления, например, когда восходящие соседние/предшествующие нейроны представляют собой поднабор из нейронов более чем одного предшествующего слоя, и/или нисходящие соседние/последующие нейроны представляют собой поднабор из нейронов более чем одного более высокого слоя.

Более того, хотя на фиг. 1 предполагается, что каждый нейрон 12 будет пересекаться только один раз во время операции прямого распространения сети 10, один или несколько нейронов 12 могут пересекаться два или более раз. Другие возможности варьирования будут рассмотрены ниже.

Как описано выше, при применении сети 10 к набору 16, то есть изображению 22 в примерном случае согласно фиг. 1а, сеть 10 выполняет операцию прямого распространения. Во время этой операции, каждый нейрон 12, который принял все свои входные значения от своих восходящих соседних/предшествующих нейронов, вычисляет, посредством соответствующей нейронной функции, выходное значение, которое называется его активацией. Эта активация, обозначенная xj в приведенном выше примерном уравнении, формирует затем входное значение каждого из нисходящих соседних/последующих нейронов. С помощью этой меры, значения элементов набора 16 распространяются через нейроны 12, чтобы завершиться в выходных нейронах 12'. Точнее, значения элементов набора 16 формируют входные значения нейронов 12 нижнего слоя сети 10, и выходные нейроны 12' принимают активации их восходящих соседних/предшествующих нейронов 12 в качестве входных значений и вычисляют их выходные значения, то есть выход 18 сети, посредством соответствующей нейронной функции. Нейронные функции, ассоциированные с нейронами 12 и 12' сети 10, могут быть равны между всеми нейронами 12 и 12' или могут различаться среди них, при этом ʺравенствоʺ означает, что нейронные функции являются параметризируемыми и параметры функции могут различаться среди нейронов, не препятствуя равенству. В случае варьирующихся/различных нейронных функций, эти функции могут быть равны между нейронами одного и того же слоя сети 10 или могут даже отличаться между нейронами в пределах одного слоя.

Таким образом, сеть 10 может быть реализована, например, в форме компьютерной программы, работающей на компьютере, то есть в программном обеспечении, но реализация в аппаратной форме, например, в виде электрической схемы, также будет осуществима. Каждый нейрон 12 вычисляет, как описано выше, активацию на основе своих входных значений, используя нейронную функцию, которая, например, представлена в приведенном выше явном примере как нелинейная скалярная функция g(⋅) линейной комбинации входных значений. Как описано, нейронные функции, ассоциированные с нейронами 12 и 12', могут быть параметризируемыми функциями. Например, в одном из конкретных примеров, описанных ниже, нейронные функции для нейрона j являются параметризируемыми с использованием смещения bj и веса wij для всех входных значений i соответствующего нейрона. Эти параметры проиллюстрированы на фиг. 1а c использованием пунктирного блока 28. Эти параметры 28 могут быть получены путем обучения сети 10. С этой целью сеть 10, например, повторно применяется к тренировочному (обучающему) набору для наборов 16 элементов, для которого известен корректный выход сети, то есть обучающему набору маркированных изображений в иллюстративном случае согласно фиг. 1а. Однако также могут существовать и другие возможности. Даже комбинация может быть осуществимой. Варианты осуществления, описанные ниже, не ограничиваются каким-либо источником или способом определения параметров 28. На фиг. 1а иллюстрируется, например, что восходящая (передняя) часть 21 сети 10, состоящая из слоев 26, продолжающихся от набора 16, т.е. входа сети, до промежуточного скрытого слоя, была искусственно сгенерирована или обучена, чтобы эмулировать извлечение признака изображения 22 посредством сверточных фильтров, например, так, что каждый нейрон (нисходящего) последующего слоя представляет собой значение признака из карт 20 признаков. Каждая карта 20 признаков, например, ассоциирована с определенной характеристикой или признаком или импульсным откликом или тому подобным. Соответственно, каждая карта 20 признаков может, например, рассматриваться как разреженно (суб-) дискретизированная отфильтрованная версия входного изображения 22, причем одна карта 20 признаков различается по ассоциированному признаку/характеристике/импульсному отклику ассоциированного фильтра от другой карты признаков. Если, например, набор 16 имеет Χ⋅Y элементов, а именно, пикселов, то есть X столбцов и Y строк пикселов, каждый нейрон будет соответствовать одному значению признака одной карты 20 признаков, значение которого будет соответствовать локальной оценке признака, ассоциированной с определенной частью изображения 22. В случае N карт признаков с Р⋅Q выборками оценок признаков, например, P столбцами и Q строками значений признаков, число нейронов в нисходящем последующем слое части 21 будут равно, например, N⋅P⋅Q, которое может быть меньше или больше, чем Χ⋅Y. Для установки нейронных функций или параметризации нейронных функций нейронов внутри части 21 можно было бы использовать перевод (преобразование) описаний признаков или фильтров, лежащих в основе карт 20 признаков, соответственно. Однако вновь отметим, что существование такой ʺпереведеннойʺ, а не ʺобученнойʺ части 21 сети не является обязательным для настоящей заявки и ее вариантов осуществления, и что такая часть может альтернативно отсутствовать. В любом случае, устанавливая, что, возможно, нейронные функции нейронов 12 могут быть равны среди всех нейронов или равны среди нейронов одного слоя или т.п., нейронная функция может, однако, быть параметризируемой, и хотя параметризируемая нейронная функция может быть одинаковой среди этих нейронов, параметр(ы) функции этой нейронной функции может (могут) варьироваться среди этих нейронов. Количество промежуточных слоев также является произвольным и может быть равно одному или больше одного.

Подводя итог вышеизложенному, применение сети 10 в нормальном рабочем режиме выглядит следующим образом: входное изображение 22, в своей роли в качестве набора 16, подвергается воздействию или вводится в сеть 10. То есть, пиксельные значения изображения 22 образуют входные значения для нейронов 12 первого слоя 24. Эти значения распространяются, как описано, вдоль прямого направления 14 по сети 10 и дают в результате выход 18 сети. В случае входного изображения 22, показанного на фиг. 1, например, выход 18 сети будет, например, указывать, что это входное изображение 22 относится к третьему классу, то есть к классу изображений, показывающих автомобиль. Более точно, в то время как выходной нейрон, соответствующий классу ʺавтомобильʺ, завершался бы высоким значением, другие выходные нейроны, иллюстративно соответствующие в данном случае классам ʺгрузовикʺ и ʺлодкаʺ, завершались бы в низких (меньших) значениях.

Однако, как описано во вводной части спецификации настоящей заявки, информация о том, показывает ли или нет изображение 22, то есть набор 16, автомобиль или тому подобное, может оказаться недостаточной. Скорее, было бы предпочтительнее иметь информацию на уровне детализации пикселов, указывающую, какие пикселы, т.е. элементы набора 16, были релевантны для решения 10 сети, а какие нет, например, какие пикселы отображают автомобиль, а какие нет. Эта задача решается с помощью вариантов осуществления, описанных ниже.

В частности, на фиг. 2а иллюстративно показано, как варианты осуществления настоящего изобретения, описанные более подробно ниже, действуют для выполнения задачи назначения значения релевантности элементам набора 16, который в иллюстративном случае фиг. 2а представляет собой область пикселов. В частности, фиг. 2а иллюстрирует, что это назначение оценки релевантности выполняется посредством процесса обратного распространения (распространения назад релевантности), в соответствии с которым значение R релевантности, например, обратно распространяется через сеть 10 по направлению к входу сети, то есть набору 16 элементов, тем самым получая оценку Ri релевантности для каждого элемента i набора 16 для каждого пиксела изображения. Например, для изображения, содержащего Χ⋅Y пикселов, i могло бы находиться в пределах {1… Χ⋅Y}, причем каждый элемент/пиксел i соответствует, например, позиции (xi, yi) пиксела. При выполнении этого обратного распространения вдоль направления 32 обратного распространения, которое проходит противоположно направлению 14 прямого распространения согласно фиг. 1, варианты осуществления, описанные ниже, подчиняются определенным ограничениям, которые теперь объясняются более подробно и называются сохранением релевантности и перераспределением релевантности.

Короче говоря, назначение оценки релевантности начинается с завершенного применения искусственной нейронной сети 10 к набору 16. Как объяснялось выше, это применение завершается в выходе 18 сети. Начальное значение R релевантности выводится из этого выхода 18 сети. В примерах, описанных ниже, например, выходное значение одного выходного нейрона 12' используется в качестве этого значения R релевантности. Вывод из выхода сети может, однако, также выполняться по-разному, используя, например, монотонную функцию, примененную к выходу сети. Другие примеры приведены ниже.

В любом случае, это значение релевантности затем распространяется по сети 10 в обратном направлении, то есть 32, указывающем в противоположном направлении по сравнению с направлением 14 прямого распространения, вдоль которого сеть 10 работает, когда применяется к набору 16, чтобы дать в результате выход 18 сети. Обратное распространение выполняется таким образом, что для каждого нейрона 12 сумма предварительно перераспределенных значений релевантности набора нисходящих соседних нейронов соответствующего нейрона распределяется по набору восходящих соседних нейронов соответствующего нейрона, так что релевантность ʺпо существу сохраняетсяʺ. Например, функция распределения может быть выбрана так, что начальное значение R релевантности равно сумме оценок Ri релевантности элементов i набора 16 после завершения обратного распространения либо точно, то есть R=ΣRi, либо через монотонную функцию f(), т.е. R=f(ΣRi). Далее обсуждаются некоторые общие соображения относительно функции распределения и того, как они должны быть предпочтительно выбраны.

При обратном распространении нейронные активации нейронов 12 используются для направления обратного распространения. То есть, активации нейронов искусственной нейронной сети 10 при применении сети 10 к набору 16 для получения выхода 18 сети предварительно сохраняются и повторно используются для того, чтобы направлять процедуру обратного распространения. Как будет описано более подробно ниже, для аппроксимации обратного распространения можно использовать аппроксимацию Тейлора. Таким образом, как показано на фиг. 2а, процесс обратного распространения можно рассматривать как распределение начального значения релевантности R, начиная с выходного нейрона(ов), к входной стороне сети 10 вдоль направления 32 обратного распространения. Посредством этой меры, пути 34 потока релевантности 34 повышенной релевантности, выводимые из выходного нейрона 36 к входной стороне сети 10, а именно, входным нейронам, формируются самим набором 16 элементов. Пути время от времени разветвляются во время прохода через сеть 10, как показано в качестве примера на фиг. 2. Пути, наконец, заканчиваются в горячих точках повышенной релевантности в пределах набора 16 элементов. В конкретном примере использования входного изображения 22, как показано на фиг. 2а, оценки Ri релевантности указывают, на пиксельном уровне, области повышенной релевантности в изображении 22, то есть области в изображении 22, которые играли главную роль в завершении операции сети 10 в соответствующем выходе 18 сети. В дальнейшем описании, вышеупомянутые свойства сохранения релевантности и перераспределения релевантности обсуждаются более подробно с использованием приведенного выше примера для нелинейных функций активации в качестве нейронных функций для нейронов сети 10.

Свойство 1: Сохранение релевантности

Первое основное свойство модели распространения релевантности предполагает, что доказательство (основание) не может быть создано или потеряно. Это применимо как в глобальном масштабе (т.е. от выхода нейронной сети обратно к входу нейронной сети), так и в локальном масштабе (т.е. на уровне отдельных нелинейных процессоров). Такое ограничение сводится к применению законов цепей Кирхгоффа к нейронной сети и замене физического понятия ʺэлектрический токʺ на понятие ʺсемантическое доказательствоʺ. В частности, см. фиг. 3.

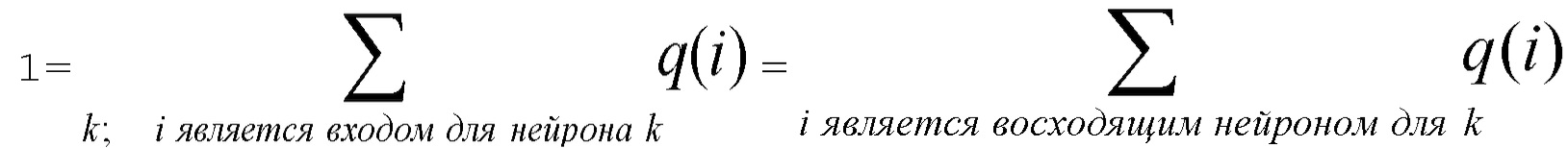

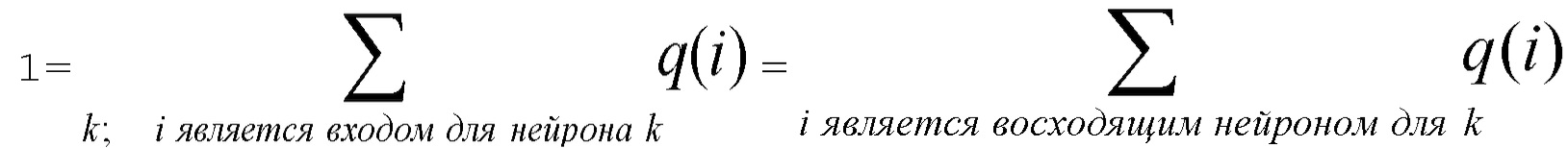

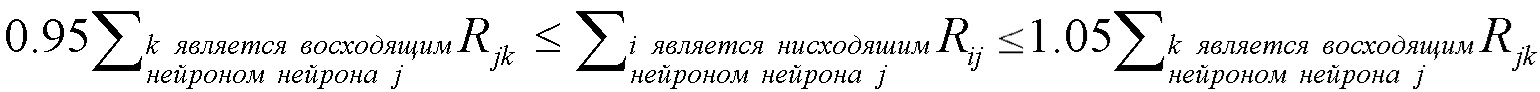

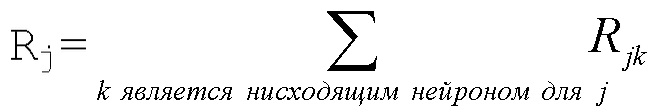

Используя индексы i и k для обозначения нейронов, входящих и исходящих в нейрон с индексом j (входящие обозначены на фиг. 3 ссылочной позицией 40 и, таким образом, образуют предшественников или восходящих соседей), должно выполняться тождество

где Rij обозначает релевантность, которая протекает от нейрона j к нейрону i, и Rjk обозначает релевантность, которая протекает от нейрона k к нейрону j. Заметим, что принцип сохранения релевантности утверждает, что сумма релевантностей, которые 'втекают в нейрон', должна быть такой же, как сумма релевантностей, которые 'вытекают из этого нейрона'. Сохранение релевантности гарантирует, что сумма релевантностей входных нейронов (например, релевантностей пикселов) равна выходному значению сети (например, оценке классификации).

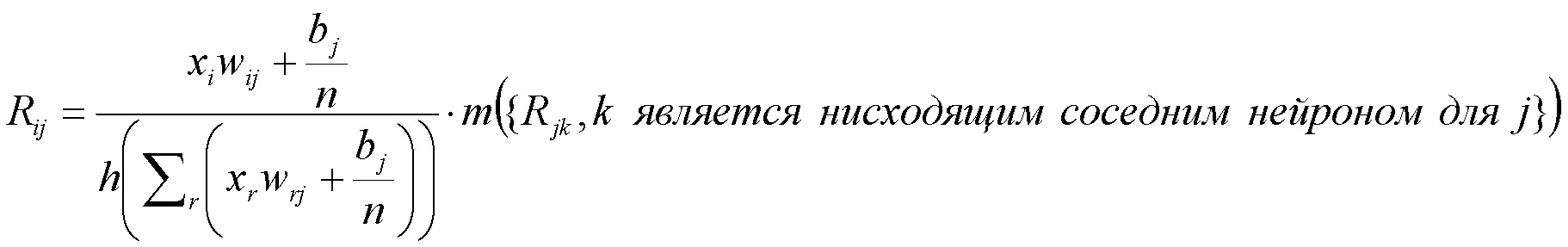

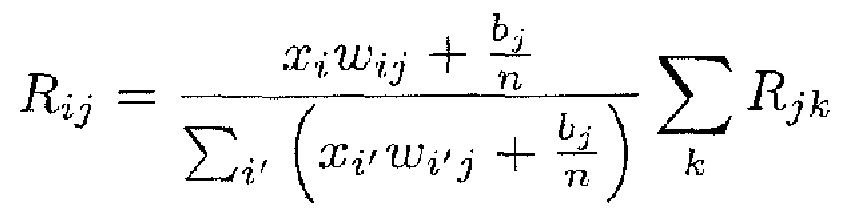

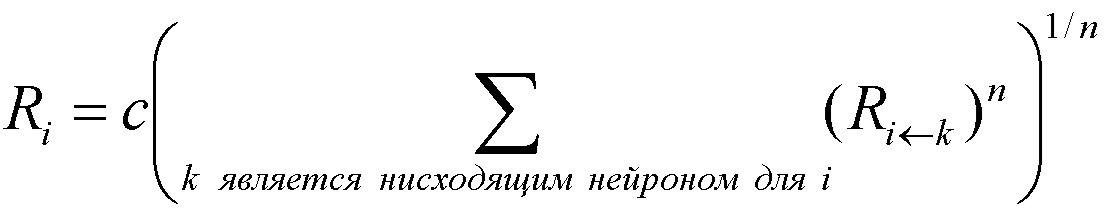

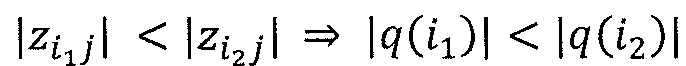

Свойство 2: перераспределение релевантности

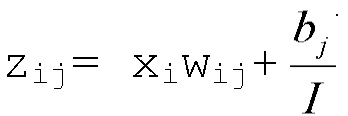

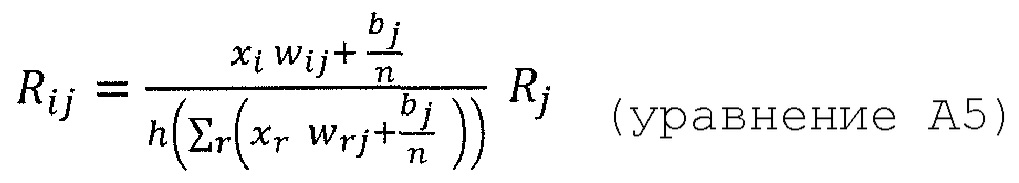

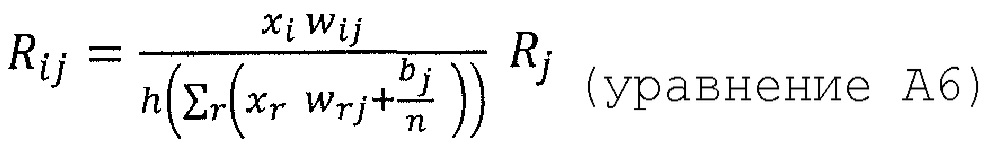

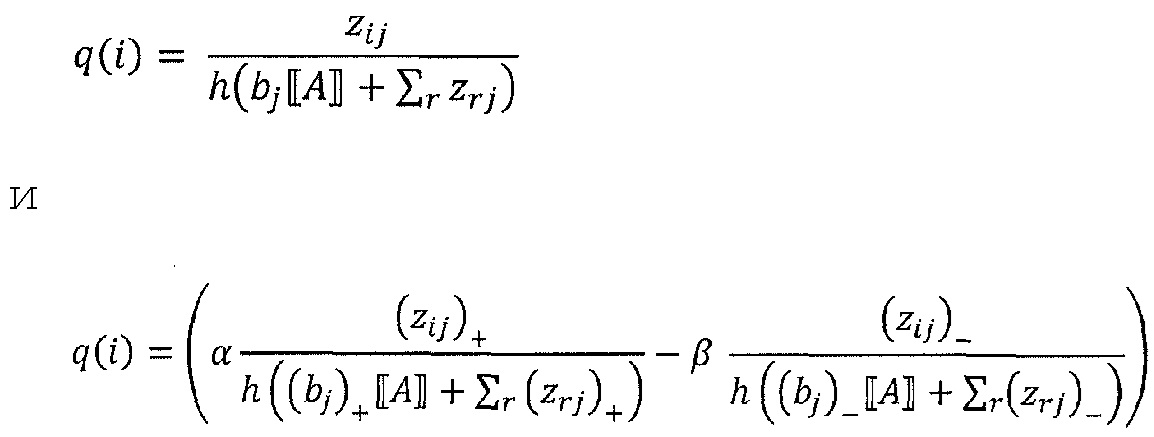

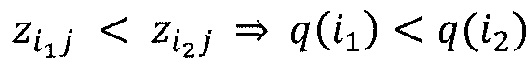

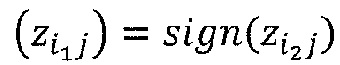

Вторым основным свойством модели распространения релевантности является то, что локальное перераспределение релевантности должно следовать фиксированному правилу, которое неизменно применяется ко всем нейронам сети. Для перераспределения релевантности может быть определено множество различных правил. Некоторые из правил ʺзначимыʺ (поддаются интерпретации), другие - нет. Одним из таких значимых правил является, например,

где n - число нейронов, индексированных посредством i. Рационализация этого правила перераспределения заключается в том, что нейроны xi, которые в наибольшей степени способствуют активации нейрона xj, будут относиться к большей части входящей релевантности ΣkRjk. Кроме того, суммируя перераспределенную релевантность Rij по всем входящим нейронам i, должно быть ясно, что свойство 1 удовлетворяется.

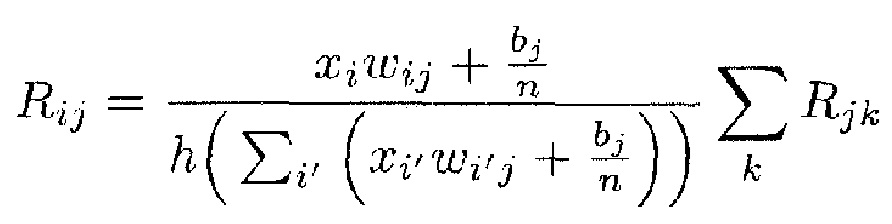

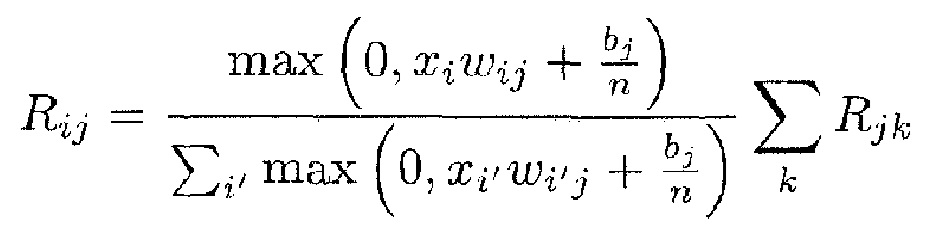

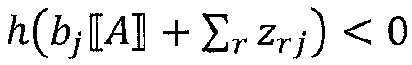

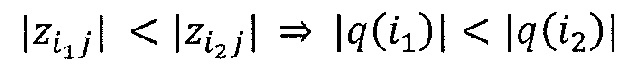

Однако приведенное выше детерминистское правило распространения релевантности имеет два недостатка: во-первых, он может быть численно неустойчивым, когда знаменатель близок к нулю. Во-вторых, оно может создавать отрицательные значения для Rij, которые имеют неопределенное значение. Первая проблема разрешается путем переопределения правила как

где h(t)=t+ε⋅sign(t) - численный стабилизатор, который не позволяет знаменателю быть близким к нулю, и где ε выбрано очень малым, чтобы соответствовать свойству 1. Вторая проблема разрешается путем учета только положительных вкладов в активации нейронов, в частности,

Здесь отметим, что отношение двух положительных величин обязательно положительно и, следовательно, будет иметь релевантность. Эти два усовершенствования могут легко комбинироваться, чтобы удовлетворять как свойства стабильности, так и положительности.

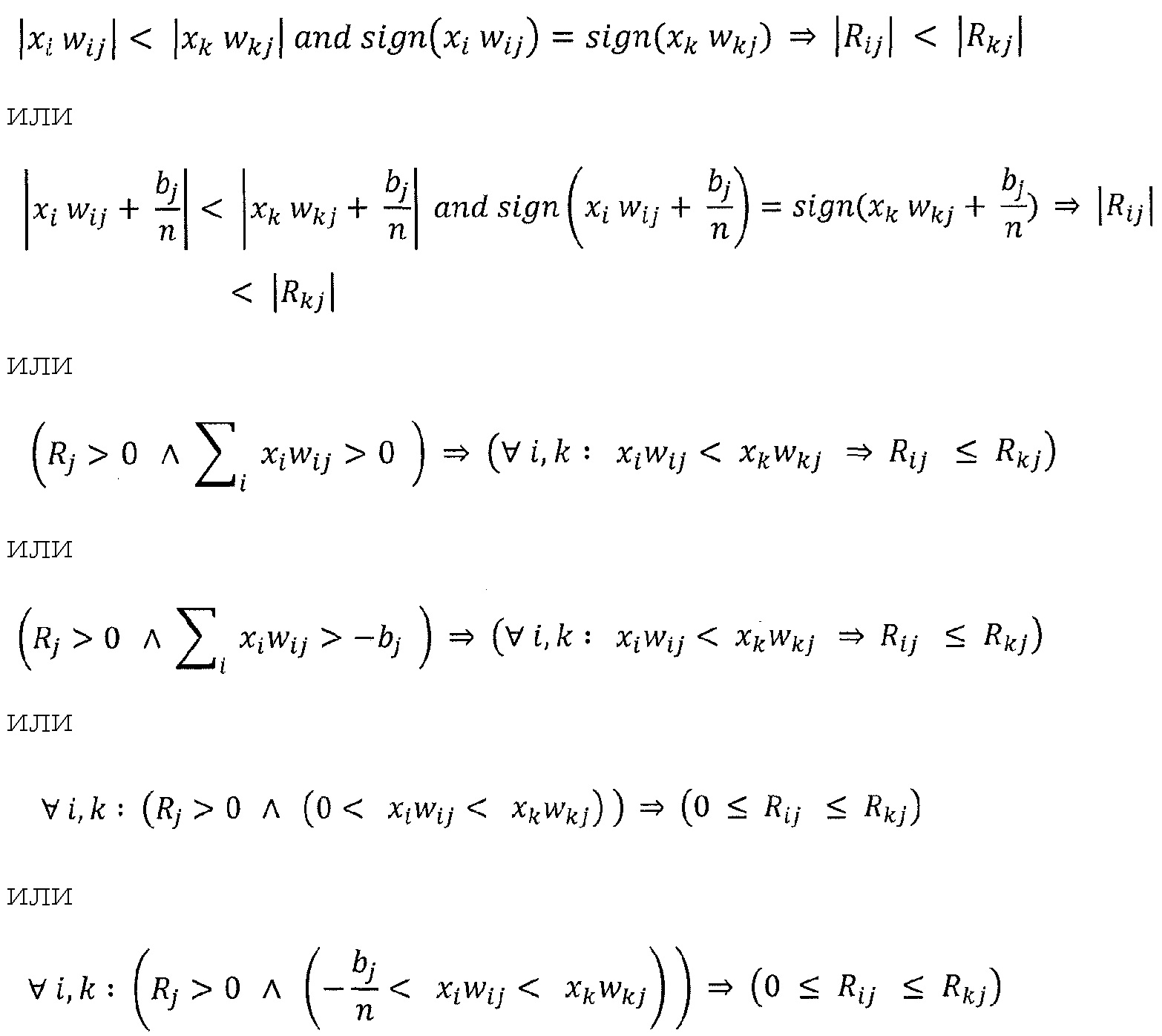

Отметим, что сохранение релевантности указывает, что делает обратное распространение (= распределение выходных релевантностей на входные переменные при сохранении общего значения (суммы) постоянным), тогда как перераспределение релевантности указывает, как это сделать (= ʺзначимоеʺ перераспределение должно обеспечивать, что нейроны, которые в наибольшей степени способствуют активации (имеют большие взвешенные активации xiwij), будут отнесены к большей части входящих релевантностей).

Прежде чем описывать устройство в соответствии с вариантом осуществления настоящей заявки, вышеуказанное введение должно быть расширено, чтобы более четко представить возможные альтернативы.

Например, хотя вариант осуществления, описанный со ссылкой на фиг. 1а и 2а, использовал изображение 22 в качестве набора 16 элементов, с возможным проектированием сети 10 таким образом, что нейронные активации нейронов одного слоя представляют собой ʺлокальные признакиʺ изображения, то есть выборки карт 20 признаков, вариант осуществления, показанный на фиг. 1b и 2b, использует карты 20 признаков в качестве набора 16 элементов. То есть в сеть 10 подаются выборки признаков карт 20 признаков. Карты 20 признаков могут быть получены из входного изображения 22, подвергая его воздействию экстракторов признаков, каждый из которых извлекает соответствующую карту 20 признаков из входного изображения 22. Эта операция экстракции признаков проиллюстрирована на фиг. 1b, используя стрелку 30. Экстрактор признаков может, например, локально применять ядро фильтра к изображению 22, чтобы выводить на каждое применение выборку признаков при перемещении ядра фильтра по изображению, чтобы получать соответствующую карту 20 признаков, состоящую из выборок признаков, расположенных, например, в строках и столбцах. Ядро/шаблон фильтра может быть индивидуальным для соответствующих экстракторов признаков и соответствующих карт 20 признаков соответственно. Здесь сеть 10 согласно фиг. 1b может совпадать с оставшейся частью сети 10 согласно фиг. 1а, остатком сети 10 после удаления части 21. Таким образом, в случае фиг. 1b, значения выборок признаков распространяются как часть так называемого процесса предсказания вдоль направления 14 вперед по сети 10 и дают в результате выход 18 сети. На фиг. 2b показан процесс обратного распространения релевантности для сети, показанной на фиг. 1b: Процесс обратного распространения распространяет обратно значение R релевантности через сеть 10 по направлению к входу сети, то есть набору 16 элементов, тем самым получая оценку Ri релевантности для каждого элемента. В случае, показанном на фиг. 2b, таким образом, оценка Ri релевантности получается для каждой выборки i признака. Однако, поскольку карты 20 признаков связаны с содержанием изображения с помощью функций выделения отдельных фильтров карт признаков, каждая оценка i релевантности может быть переведена в пиксельную область, то есть в пикселы, а именно, путем распределения отдельных оценок релевантности элементов набора 16 фиксированным способом в отдельные положения пикселов изображения 22. ʺФиксированный способʺ однозначно зависит от экстракторов признаков, ассоциированных с картой признаков соответствующей оценки релевантности, и представляет собой своего рода обратную функцию 38 выделения 30 признаков. Эта обратная функция 38, таким образом, образует своего рода расширение процесса обратного распространения, чтобы закрыть промежуток от области набора признаков до пространственной области пикселов.

Кроме того, следует отметить, что в случае фиг. 1а и фиг. 2а было предварительно принято, что каждый пиксел изображения 22, т.е. каждый элемент 16, несет скаляр. Эта интерпретация может применяться, например, в случае изображения 22 шкалы уровней серого, например, при каждом пиксельном значении, соответствующем значению шкалы уровней серого. Однако существуют и другие возможности. Например, изображение 22 может быть цветным изображением. В этом случае каждый элемент набора 16 может соответствовать выборке или пиксельному значению одной из нескольких цветных плоскостей или цветовых компонентов изображения 22. На фиг. 1c и 2c в качестве примера показаны три компонента, которые показывают расширение фиг. 1a и 2а для цветных изображений 22. Таким образом, набор 16 элементов в случае фиг. 1с и 2с будет Χ⋅Y⋅3 в случае наличия для каждого из Χ⋅Y положений пикселов значения цветового компонента для каждого из трех цветовых компонентов. Однако количество цветовых компонентов может отличаться от трех. Кроме того, пространственное разрешение цветовых компонентов не должно быть одинаковым. Обратное распространение на фиг. 2с завершается значением релевантности для каждого элемента, т.е. выборки цветового компонента. В случае наличия значения компонента для всех компонентов для каждого пиксела, окончательная карта релевантности может быть получена путем суммирования значений релевантности, полученных для цветовых компонентов соответствующего пиксела. Это показано как 37.

Хотя фиг. 1-2c относились к изображениям и пикселам, варианты осуществления настоящей заявки не ограничиваются данными такого типа. Например, тексты и их слова могут быть использованы в качестве основы. Приложение анализа социального графа может выглядеть следующим образом: релевантность назначается узлам и соединениям в графе, где граф задается как вход в нейронную сеть 10. В контексте анализа социального графа узлы могут представлять пользователей, а соединения могут представлять связь между этими пользователями. Такие соединения также могут быть направлены на моделирование информационных потоков (например, сеть ссылок) или цепочку ответственности внутри организации. Например, нейронные сети могут обучаться, чтобы предсказывать для графа, заданного в качестве входа, определенное свойство графа (например, производительность, ассоциированную с конкретным социальным графом). В этом случае способ распространения релевантности и тепловой карты будет стремиться идентифицировать на этом графе подструктуры или узлы, которые объясняют предсказанное свойство (то есть высокую или низкую производительность). Нейронные сети также могут обучаться, чтобы предсказывать состояние графа в более поздний момент времени. В этом случае процедура распространения релевантности будет пытаться идентифицировать, какая подструктура в графе объясняет будущее состояние графа (например, какие подструктуры или узлы наиболее влиятельны в социальном графе в их способности распространять информацию в графе или изменять его состояние). Таким образом, нейронная сеть может, например, использоваться для предсказания успеха (например, количества проданных продуктов) рекламной кампании (задача регрессии). Оценки релевантности могут использоваться для идентификации некоторых влиятельных аспектов успеха. Компания может сэкономить деньги, сосредоточившись только на этих релевантных аспектах. Процесс назначения оценки релевантности может выдавать оценку для каждого элемента рекламной кампании. Затем процессор принятия решений может принять этот вход, а также информацию о расходах по каждому элементу рекламной кампании и определить оптимальную стратегию кампании. Однако релевантность может также использоваться для выбора признака, как показано выше.

Назначение оценки релевантности начинается с вывода начального значения R релевантности. Как упоминалось выше, оно может быть установлено на основе одного из выходных нейронов нейронной сети, чтобы получить, путем обратного распространения, значения релевантности для элементов набора 16, ссылаясь на ʺсмысловое значениеʺ этого одного выходного нейрона. Однако выход 18 сети может альтернативно быть вектором, а выходные нейроны могут иметь такие смысловые значения, которые могут быть разделены на перекрывающиеся или неперекрывающиеся поднаборы. Например, выходные нейроны, соответствующие смысловому значению (категории) ʺгрузовикʺ и ʺмашинаʺ, могут объединяться, чтобы приводить к подмножеству выходных нейронов со смысловым значением ʺавтомобильʺ. Соответственно, выходные значения обоих выходных нейронов могут использоваться в качестве начальной точки в обратном распространении, тем самым приводя к оценке релевантности для элементов 16, то есть пикселов, указывая релевантность для смыслового значения поднабора, то есть ʺавтомобиляʺ.

Хотя изложенное выше описание предполагало, что набор элементов представляет собой изображение, и каждый из элементов 42 набора 16 элементов 42 соответствует одному пикселу изображения, это может быть иным. Например, каждый элемент может соответствовать набору пикселов или субпикселов (пиксел имеет обычно значения rgb; субпикселом будет, например, зеленый компонент пиксела), такому как суперпиксел, как показано на фиг. 2c. Кроме того, набор 16 элементов может альтернативно быть видео, и каждый из элементов 42 набора 16 элементов 42 соответствует одному или нескольким пикселам изображений (кадров) видео, кадрам видео или последовательностям кадров видео. Поднабор пикселов, к которым относится элемент, может содержать пикселы кадров с разными временными метками. Кроме того, набор 16 элементов может быть аудиосигналом, и каждый элемент 42 набора 16 элементов 42 соответствует одной или нескольким выборкам аудиосигнала, таким как выборки PCM. Отдельные элементы набора 16 могут быть выборками или любой другой частью аудиозаписи. Или набор элементов может представлять собой пространство произведений частот и времени, и каждый элемент представляет собой набор из одного или нескольких частотно-временных интервалов, таких как спектрограмма, состоящая, например, из MDCT-спектров последовательности перекрывающихся окон. Кроме того, набор 16 может представлять собой карту признаков для локальных признаков, локально извлеченных из изображения, видео или аудиосигнал, с элементами 42 набора 16 элементов 42, соответствующими локальным признакам, или текст с элементами 42 набора 16 элементов 42, соответствующими словам, предложениям или абзацам текста.

Для полноты, на фиг. 1d и 2d показан вариант, согласно которому набор данных 16 элементов представляет собой текст, а не изображение. Для этого случая, фиг. 1d иллюстрирует, что текст, который является фактически последовательностью 41 слов (например, I) слов 43, переносится в ʺабстрактнуюʺ или ʺинтерпретируемуюʺ версию путем отображения каждого слова wi 43 на соответствующий вектор vi 45 общей длины, т.е. общее число J компонентов vij 47, в соответствии с пословным преобразованием 49. Каждый компонент может быть ассоциирован с семантическим значением. Пословное преобразование, которое может быть использовано, представляет собой, например, Word2Vec или векторы указателя слов. Компоненты vij 47 векторов vi 45 представляют элементы набора 16 и подвергаются воздействию сети 10, что приводит к результату 18 предсказания в выходных узлах 12' сети. Обратное распространение, показанное на фиг. 2, приводит к значению релевантности для каждого элемента, т.е. для каждого векторного компонента vij (0<i<I; 0<j<J). Суммирование 53, для каждого слова wi, оценок релевантности для компонентов vij вектора vi, ассоциированного с соответствующим словом wi, при 0<j<J, приводит к суммарному значению релевантности (оценке релевантности) на каждое слово, например, и, таким образом, каждое слово wi в тексте может быть выделено в соответствии с его суммарной оценкой релевантности. Количество опций выделения может быть равно двум или больше. То есть, суммарные значения релевантности слов могут быть квантованы, чтобы получить опцию выделения для каждого слова. Опция выделения может быть ассоциирована с различной интенсивностью выделения, и отображение от суммарных значений релевантности на опции выделения может привести к монотонной ассоциации между суммарными значениями релевантности и интенсивностью выделения. Опять же, подобно примерам, в которых нейронная сеть относилась к характеристикам предсказания на изображениях, часть входной стороны сети 10 согласно фиг. 1d и 2d может иметь некоторое интерпретируемое смысловое значение. В случае изображений это были наборы признаков. В случае фиг. 1d и 2d, входная часть сети 10 могла бы представлять другое векторное отображение векторов, состоящих из компонентов набора 16, на наиболее вероятные векторы меньшей размерности, компоненты которых могут иметь более предпочтительное семантическое значение по сравнению с относящимися к предпочтительному семейству слов компонентами векторов, составленных из компонентов набора 16.

На фиг. 4 показан пример устройства для назначения оценки релевантности набору элементов. Устройство реализовано, например, в программном обеспечении, то есть в программируемом компьютере. Однако можно представить себе другие возможности реализации. В любом случае, устройство 50 сконфигурировано для использования вышеописанного процесса обратного распространения для того, чтобы назначать, поэлементно, оценку релевантности набору 16 элементов, причем оценка релевантности указывает для каждого элемента, какую релевантность имеет этот элемент в получении сетью 10 на его основе выхода 18 сети. Соответственно, на фиг. 4 также показана нейронная сеть. Сеть 10 показана как не являющаяся частью устройства 50: вместо этого сеть 10 определяет источник смыслового значения ʺрелевантностиʺ, для которой должны быть назначены оценки набору 16 элементов устройством 50. Однако, в качестве альтернативы, устройство 50 также может включать в себя сеть 10.

Фиг. 4 показывает сеть 10 в качестве принимающей набор 16 элементов, причем элементы иллюстративно показаны в виде кружков 42. Фиг. 4 также иллюстрирует возможность того, что сеть 10 управляется параметрами 44 нейрона, такими как весовые коэффициенты функции, управляющие вычислением активации нейронов на основе восходящих соседних/предшествующих нейронов данного нейрона, как описано выше, то есть параметрами нейронных функций. Эти параметры 44 могут, например, сохраняться в памяти или хранилище 46. Фиг. 4 также иллюстрирует выход сети 10 после завершения обработки набора 16 элементов 42 с использованием параметров 44, а именно, выход 18 сети и, опционально, нейронные активации нейронов 12, полученные в результате обработки набора 16, причем активации нейронов проиллюстрированы ссылочной позицией 48. Активации 48 нейронов, выход 18 сети и параметры 44 иллюстративно показаны сохраненными в памяти 46, но они также могут храниться в отдельном хранилище или памяти или могут не храниться. Устройство 50 имеет доступ к выходу 18 сети и выполняет задачу 52 перераспределения с использованием выхода 18 сети и вышеописанного принципа обратного распространения, чтобы получить оценку Ri релевантности для каждого элемента i 52 набора 16. В частности, как описано выше, устройство 50 получает начальное значение R релевантности из выхода сети и перераспределяет эту релевантность R, используя процесс обратного распространения, чтобы получить индивидуальные оценки Ri релевантности для элементов i. Отдельные элементы набора 16 показаны на фиг. 4 маленькими кружками, обозначенными ссылочной позицией 42. Как описано выше, перераспределение 52 может управляться параметрами 44 и активациями 48 нейронов, и, соответственно, устройство 50 также может иметь доступ к этим элементам данных. Кроме того, как показано на фиг. 4, фактическую нейронную сеть 10 не требуется реализовывать в устройстве 50. Скорее, устройство 50 может иметь доступ, например, к информации о конструкции сети 10, такой как количество нейронов, функции нейронов, к которым относятся параметры 44, и взаимосвязи нейронов, информация о которых проиллюстрирована на фиг. 4 с использованием описания 54 нейронной сети, которое, как показано на фиг. 4, также может храниться в памяти или хранилище 46 или в другом месте. В альтернативном варианте осуществления, искусственная нейронная сеть 10 также реализуется на устройстве 50, так что устройство 50 может содержать процессор нейронной сети для применения нейронной сети 10 к набору 16 в дополнение к процессору перераспределения, который выполняет задачу 52 перераспределения.

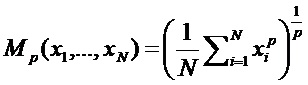

Таким образом, приведенные выше варианты осуществления могут, в том числе, закрывать промежуток между классификацией и интерпретируемостью для многослойных нейронных сетей, которые пользуются популярностью в компьютерном зрении. Для нейронных сетей (например, [6, 31]) мы рассмотрим общие многослойные сетевые структуры с произвольными непрерывными нейронами и функциями опрашивания на основе обобщенных р-средних.

Следующий раздел ʺПопиксельная декомпозиция как обобщенная концепцияʺ объяснит основные подходы, лежащие в основе попиксельной декомпозиции классификаторов. Эта попиксельная декомпозиция была проиллюстрирована со ссылкой на фиг. 1a и 2c. Попиксельная декомпозиция для многослойных сетей применяет тейлоровский подход и подход послойного распространения релевантности, объясняемые в разделе ʺПопиксельная декомпозиция как обобщенная концепцияʺ для архитектур нейронных сетей. Экспериментальная оценка нашей структуры будет дана в разделе ʺЭкспериментыʺ.

Попиксельная декомпозиция как обобщенная концепция

Общая идея попиксельной декомпозиции заключается в том, чтобы понять вклад отдельного пиксела изображения x в предсказание f(x), сделанное классификатором f в задаче классификации изображений. Мы хотели бы узнать, отдельно для каждого изображения x, какие пикселы в какой степени вносят вклад в положительный или отрицательный результат классификации. Более того, мы хотим выразить эту степень количественно мерой. Мы предполагаем, что классификатор имеет действительнозначные выходы, пороговые значения которых равны нулю. В такой установке это соответствует отображению f: RV→R1, так что f(x)>0 означает наличие обученной структуры. Вероятностные выходы для классификаторов двух классов можно рассматривать без потери общности путем вычитания 0,5 или взятия логарифма предсказания и добавления затем логарифма 2.0. Представляет интерес узнать вклад каждого входного пиксела x(d) входного изображения x в конкретное предсказание f(x). Важное ограничение, характерное для классификации, состоит в нахождении дифференциального вклада относительно состояния максимальной неопределенности относительно классификации, который затем представляется набором корневых точек f(x0)=0. Один из возможных способов состоит в декомпозиции предсказания f(x) как суммы членов отдельных входных размерностей xd или пикселов:

Качественная интерпретация заключается в том, что Rd<0 способствует доказательству против наличия структуры, которая должна классифицироваться, тогда как Rd>0 способствует доказательству ее присутствия. С точки зрения последующей визуализации, результирующие релевантности Rd для каждого входного пиксела x(d) могут быть отображены в цветовое пространство и визуализированы таким образом как обычная тепловая карта. Одним из основных ограничений в следующей работе будет то, что знаки Rd должны следовать вышеуказанной качественной интерпретации, то есть положительные значения должны обозначать положительные вклады, отрицательные значения - отрицательные вклады.

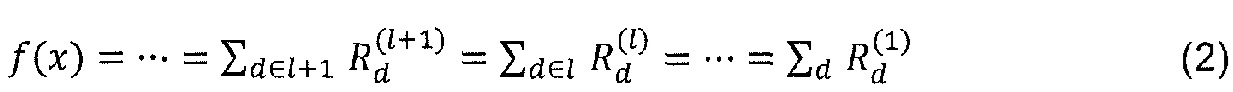

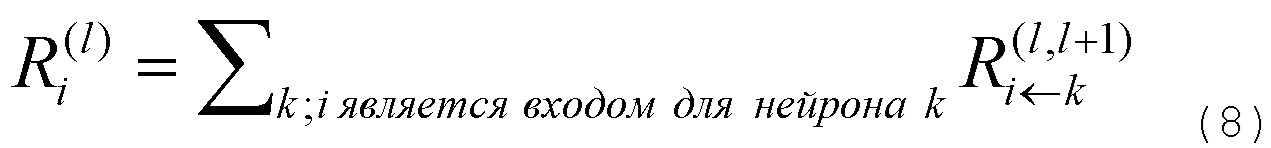

В дальнейшем, концепция обозначается как послойное распространение релевантности в качестве концепции с целью достижения попиксельной декомпозиции, как в уравнении (1). Также обсуждается подход, основанный на декомпозиции Тейлора, который дает аппроксимацию послойного распространения релевантности. Будет показано, что для широкого диапазона архитектур нелинейной классификации можно выполнить послойное распространение релевантности без использования аппроксимации посредством разложения Тейлора. Приведенные ниже методы не включают сегментацию. Они не требуют попиксельной тренировки (обучения) в качестве обучающей настройки или попиксельной маркировки для фазы обучения. Используемая здесь настройка - это классификация по изображению, в которой во время обучения одна метка предоставляется для изображения в целом, однако вклад заключается не в обучении классификатора. Методы строятся поверх предварительно обученного классификатора. Они применимы к уже предварительно обученному классификатору изображений.

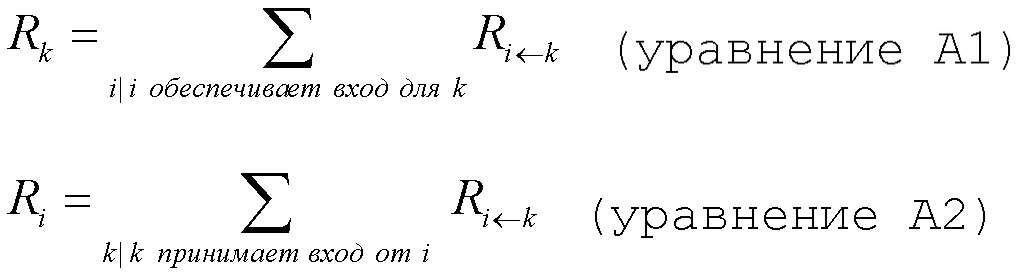

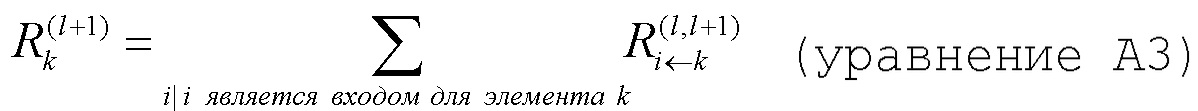

Послойное распространение релевантности

Послойное распространение релевантности в его обобщенной форме предполагает, что классификатор можно разложить на несколько слоев вычисления. Такие слои могут быть частями выделения признаков из изображения или частями алгоритма классификации, выполняемого на вычисленных признаках. Как показано ниже, это возможно для нейронных сетей.

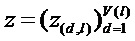

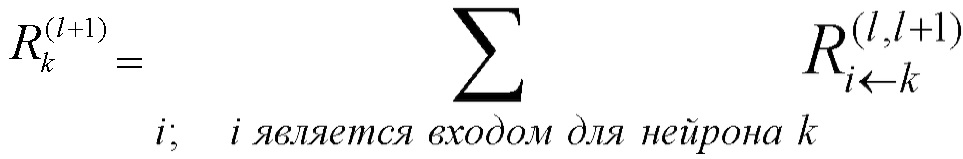

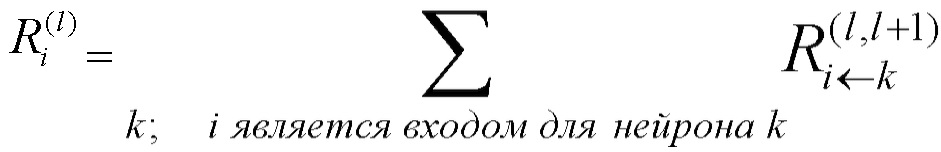

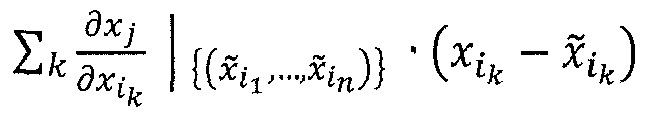

Первым слоем могут быть входы, пикселы изображения, последним слоем является дествительнозначный выход предсказания классификатора f. l-ый слой моделируется как вектор  с размерностью V(l). Послойное распространение релевантности предполагает, что для каждой размерности z(d,l+1) вектора z в слое l+1 имеется оценка

с размерностью V(l). Послойное распространение релевантности предполагает, что для каждой размерности z(d,l+1) вектора z в слое l+1 имеется оценка  релевантности. Идея состоит в том, чтобы найти оценку

релевантности. Идея состоит в том, чтобы найти оценку  релевантности для каждой размерности z(d,l) вектора z на следующем слое l, который ближе к входному слою, так что выполняется следующее уравнение.

релевантности для каждой размерности z(d,l) вектора z на следующем слое l, который ближе к входному слою, так что выполняется следующее уравнение.

Итерация уравнения (2) из последнего слоя, который является выходом f(x) классификатора, до входного слоя x, состоящего из пикселов изображения, дает тогда требуемое уравнение (1). Релевантность для входного слоя будет служить желательной декомпозицией суммы в уравнении (1). Как будет показано, такая декомпозиция сама по себе не является ни уникальным, ни гарантирующей, что она дает значимую интерпретацию предсказания классификатора.

Приведем здесь простой контрпример. Предположим, что имеется один слой. Входы представляют собой x∈RV. Используем линейный классификатор с некоторым произвольным и специфическим для размерности отображением φd пространства признаков и смещением b

Определим релевантность для второго слоя тривиально как  =f(x). Тогда одной возможной формулой послойного распространения релевантности должно быть определение релевантности R(1) для входов x как

=f(x). Тогда одной возможной формулой послойного распространения релевантности должно быть определение релевантности R(1) для входов x как

Это явно удовлетворяет уравнениям (1) и (2), однако релевантность R(1)(xd) всех входных размерностей имеет тот же знак, что и предсказание f(x). В терминах интерпретации попиксельной декомпозиции, все входы указывают на наличие структуры, если f(x)>0, и на отсутствие структуры, если f(x)<0. Это для многих задач классификации не является реалистичной интерпретацией.

Обсудим более осмысленный способ определения послойного распространения релевантности. Для этого примера определим

Тогда релевантность размерности xd признака зависит от знака члена в уравнении (5). Это для многих проблем классификации является более правдоподобной интерпретацией. Этот второй пример показывает, что послойное распространение релевантности способно иметь дело с нелинейностями, такими как отображение φd пространства признаков до некоторой степени, и на практике может выглядеть как пример послойного распространения релевантности, удовлетворяющий формуле (2). Заметим, что здесь вообще не требуется предположение о регулярности отображения φd пространства признаков, оно может быть даже не непрерывным или не измеримым по мере Лебега. Основополагающая формула (2) может быть интерпретирована как закон сохранения для релевантности R между слоями обработки признаков.

Приведенный выше пример дает, кроме того, интуитивное представление о том, чем является релевантность R, а именно, локальный вклад в функцию f(x) предсказания. В этом смысле релевантность выходного слоя может быть выбрана в качестве самого предсказания f(x). Этот первый пример показывает, что можно ожидать в качестве декомпозиции для линейного случая. Линейный случай обеспечивает первое интуитивное представление.

Приведем второй, более графический и нелинейный пример. На фиг. 5 показан классификатор нейронной сети с нейронами и весами wij на соединениях между нейронами. Каждый нейрон i имеет выход ai из функции активации.

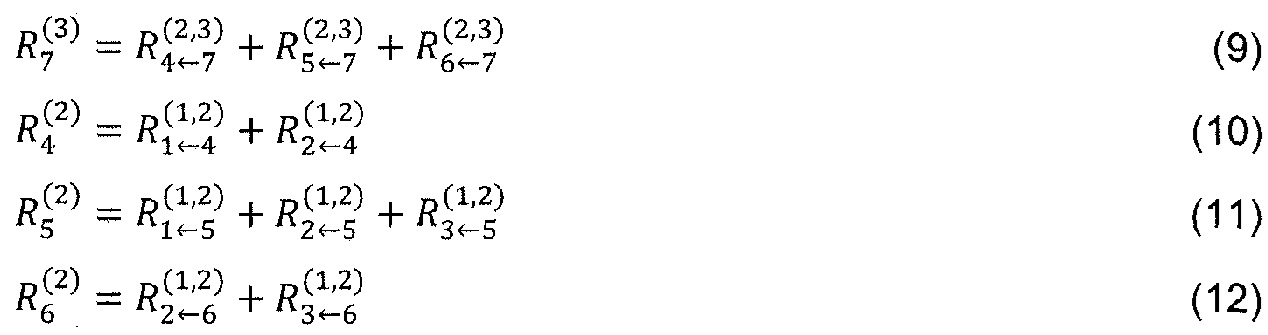

Верхний слой состоит из одного выходного нейрона, индексированного как 7. Для каждого нейрона i вычислим релевантность Ri. Отбросим верхний индекс R(l) слоя для этого примера, поскольку все нейроны имеют явный индекс нейрона всякий раз, когда индекс слоя очевиден. Инициализируем релевантность  верхнего слоя как значение функции, таким образом, R7=f(x). Послойное распространение релевантности в уравнении (2) требует теперь поддержания

верхнего слоя как значение функции, таким образом, R7=f(x). Послойное распространение релевантности в уравнении (2) требует теперь поддержания

Сделаем два предположения для этого примера. Во-первых, выразим послойную релевантность в терминах сообщений  между нейронами i и j, которые могут передаваться по каждому соединению. Однако сообщения направляются от нейрона к его входным нейронам, в отличие от того, что происходит во время предсказания, как показано на фиг. 6. Во-вторых, определим релевантность любого нейрона, кроме нейрона 7, в виде суммы входящих сообщений:

между нейронами i и j, которые могут передаваться по каждому соединению. Однако сообщения направляются от нейрона к его входным нейронам, в отличие от того, что происходит во время предсказания, как показано на фиг. 6. Во-вторых, определим релевантность любого нейрона, кроме нейрона 7, в виде суммы входящих сообщений:

Например,  =

= +

+ . Отметим, что нейрон 7 не имеет входящих сообщений. Вместо этого его релевантность определяется как

. Отметим, что нейрон 7 не имеет входящих сообщений. Вместо этого его релевантность определяется как  =f(x). В уравнении (8) и следующем тексте термины ʺвходʺ и ʺисточникʺ имеют значение в смысле входа в другой нейрон в направлении, определенном во время классификации, а не во время вычисления послойного распространения релевантности. Например, на фиг. 6 нейроны 1 и 2 являются входами и источниками для нейрона 4, в то время как нейрон 6 является приемником для нейронов 2 и 3. Учитывая два предположения, закодированные в уравнении (8), послойное распространение релевантности по уравнению (2) может быть удовлетворено следующим достаточным условием:

=f(x). В уравнении (8) и следующем тексте термины ʺвходʺ и ʺисточникʺ имеют значение в смысле входа в другой нейрон в направлении, определенном во время классификации, а не во время вычисления послойного распространения релевантности. Например, на фиг. 6 нейроны 1 и 2 являются входами и источниками для нейрона 4, в то время как нейрон 6 является приемником для нейронов 2 и 3. Учитывая два предположения, закодированные в уравнении (8), послойное распространение релевантности по уравнению (2) может быть удовлетворено следующим достаточным условием:

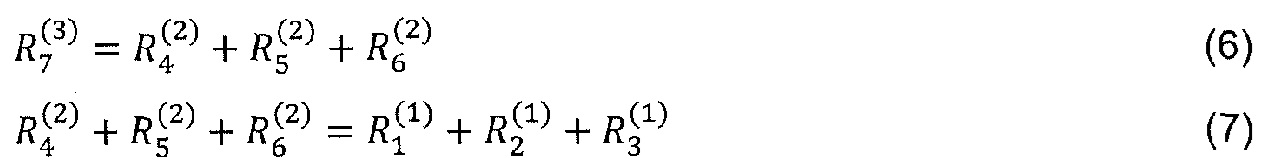

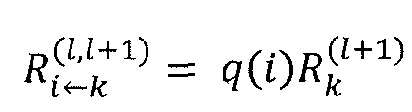

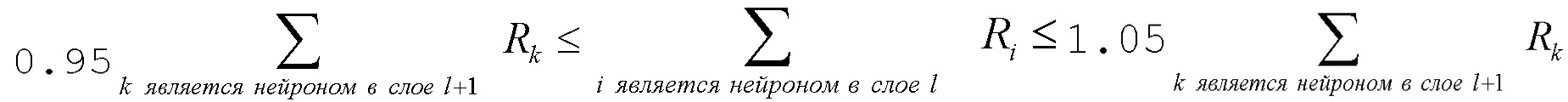

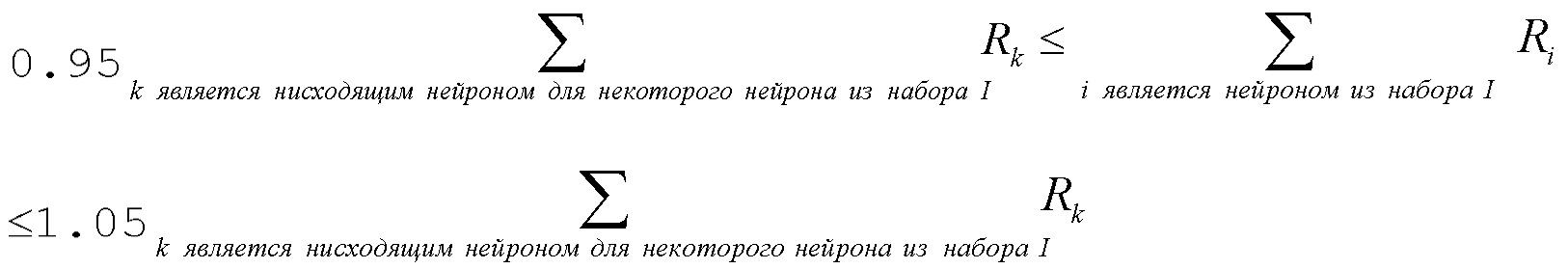

В общем случае это условие может быть выражено как:

Разница между условием (13) и определением (8) заключается в том, что в условии (13) сумма пробегает по источникам в слое l для фиксированного нейрона k в слое l+1, тогда как в определении (8) сумма пробегает по приемникам в слое l+1 для фиксированного нейрона i в слое l. Это условие является достаточным условием, а не необходимым. Оно является следствием определения (8). Можно интерпретировать достаточное условие (13), говоря, что сообщения  используются для распределения релевантности

используются для распределения релевантности  нейрона k на его входные нейроны в слое l. Следующие разделы будут основаны на этом понятии и более строгой форме сохранения релевантности, как задается определением (8) и достаточным условием (13).

нейрона k на его входные нейроны в слое l. Следующие разделы будут основаны на этом понятии и более строгой форме сохранения релевантности, как задается определением (8) и достаточным условием (13).

Теперь можем получить явную формулу для послойного распространения релевантности для нашего примера путем определения сообщений  . Послойное распространение релевантности должно отражать сообщения, переданные в течение времени классификации. Мы знаем, что в течение времени классификации нейрон i вводит aiwik в нейрон k, при условии, что i имеет прямое соединение с k. Таким образом, мы можем представить уравнения (9) и (10) посредством

. Послойное распространение релевантности должно отражать сообщения, переданные в течение времени классификации. Мы знаем, что в течение времени классификации нейрон i вводит aiwik в нейрон k, при условии, что i имеет прямое соединение с k. Таким образом, мы можем представить уравнения (9) и (10) посредством

В общем случае это можно выразить как

Хотя это определение еще нужно адаптировать так, что оно может использоваться, когда знаменатель обращается в нуль, пример, приведенный в уравнении (16), дает представление о том, что может представлять сообщение  , а именно, релевантность приемного нейрона

, а именно, релевантность приемного нейрона  , которая уже была вычислена взвешенно пропорционально входу нейрона i из предыдущего слоя l. Это понятие справедливо аналогичным образом, когда мы используем различные архитектуры классификации и заменяем понятие нейрона на размерность вектора признаков в данном слое.

, которая уже была вычислена взвешенно пропорционально входу нейрона i из предыдущего слоя l. Это понятие справедливо аналогичным образом, когда мы используем различные архитектуры классификации и заменяем понятие нейрона на размерность вектора признаков в данном слое.

Формула (16) имеет второе свойство: знак релевантности, переданной сообщением  , переключается, если вклад нейрона aiwik имеет другой знак, чем сумма вкладов от всех входных нейронов, т.е. если нейрон срабатывает против общей тенденции для верхнего нейрона, из которого он наследует часть релевантности. Так же, как и для примера с линейным отображением в уравнении (5), входной нейрон может наследовать положительную или отрицательную релевантность в зависимости от знака его входа.

, переключается, если вклад нейрона aiwik имеет другой знак, чем сумма вкладов от всех входных нейронов, т.е. если нейрон срабатывает против общей тенденции для верхнего нейрона, из которого он наследует часть релевантности. Так же, как и для примера с линейным отображением в уравнении (5), входной нейрон может наследовать положительную или отрицательную релевантность в зависимости от знака его входа.

Здесь также показано еще одно свойство. Формула для распределения релевантности применима к нелинейным и даже недифференцируемым или не являющимся непрерывными активациям ak нейрона. Алгоритм будут начинаться с релевантностей R(l+1) уровня l+1, которые уже были вычислен. Тогда сообщения  будут вычисляться для всех элементов k из слоя l+1 и элементов i из предыдущего слоя l таким образом, чтобы выполнялось уравнение (13). Тогда определение (8) будет использоваться для определения релевантности R(l) для всех элементов слоя l.

будут вычисляться для всех элементов k из слоя l+1 и элементов i из предыдущего слоя l таким образом, чтобы выполнялось уравнение (13). Тогда определение (8) будет использоваться для определения релевантности R(l) для всех элементов слоя l.

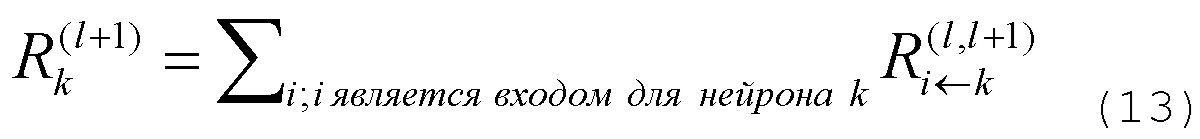

Декомпозиция тейлоровского типа

Одним альтернативным подходом к достижению декомпозиции, как в (1) для общего дифференцируемого предсказателя f, является аппроксимация Тейлора первого порядка.

Выбор базовой точки x0 Тейлора является свободным параметром в этой установке. Как было сказано выше, в случае классификации интересно выяснить вклад каждого пиксела относительно состояния максимальной неопределенности предсказания, которая задается набором точек f(x0)=0, так как f(x)>0 обозначает наличие и f(x)<0 обозначает отсутствие изученной структуры. Таким образом, x0 следует выбирать как корень предсказателя f. Для точности аппроксимации Тейлора предсказания, x0 следует выбрать близким к x по евклидовой норме для минимизации остатка Тейлора в соответствии с аппроксимациями Тейлора более высокого порядка. В случае нескольких существующих корней x0 с минимальной нормой, их можно усреднить или интегрировать, чтобы получить среднее значение по всем этим решениям. Вышеприведенное уравнение упрощается до

Попиксельная декомпозиция содержит нелинейную зависимость от точки предсказания x за пределами ряда Тейлора, так как нужно найти ближайшую корневую точку x0. Таким образом, полная попиксельная декомпозиция является не линейным, а локально линейным алгоритмом, так как корневая точка x0 зависит от точки x предсказания.

В нескольких работах использовались карты чувствительности [2, 18, 38] для визуализации предсказаний классификаторов, основанных на использовании частных производных в точке x предсказания. Существуют два существенных различия между картами чувствительности, основанными на производных в точке x предсказания, и подходом попиксельной декомпозиции. Во-первых, нет прямой зависимости между значением f(x) функции в точке x предсказания и дифференциалом Df(x) в той же точке x. Во-вторых, интересно объяснить предсказание классификатора относительно некоторого состояния, заданного набором корней функции f(x0) предсказания. Дифференциал Df(x) в точке предсказания не обязательно указывает на корень, который близок к евклидовой норме. Он указывает на ближайший локальный оптимум, который может по-прежнему иметь тот же знак, что и предсказание f(x), и, таким образом, вводить в заблуждение для объяснения разницы с набором корневых точек функции предсказания. Поэтому производные в точке х предсказания не являются полезными для достижения нашей цели. На фиг. 7 показано качественное различие между локальными градиентами (стрелками, направленными вверх) и декомпозицией по размерностям предсказания (стрелкой, направленной вниз). В частности, на этой фигуре изображено интуитивное представление, что градиент в точке х предсказания, показанной здесь квадратом, не обязательно указывает на близкую точку на границе решения. Вместо этого он может указывать на локальный оптимум или на удаленную точку на границе решения. В этом примере вектор объяснения от локального градиента в точке х предсказания имеет слишком большой вклад в нерелевантном направлении. Ближайшие соседи другого класса могут быть найдены под другим углом. Таким образом, локальный градиент в точке х предсказания может не оказаться хорошим объяснением для вкладов отдельных измерений в значение функции f(x). Локальные градиенты в точке предсказания в левом изображении и корневая точка Тейлора в правом изображении обозначены черными стрелками. Ближайшая корневая точка x0 показана как треугольник на границе решения. Стрелка, направленная вниз, в правом изображении визуализирует аппроксимацию f(x) разложением Тейлора вокруг ближайшей корневой точки x0. Аппроксимация задается как вектор, представляющий произведение по размерностям между Df(x0) (серая стрелка на правой панели) и x-x0 (пунктирная линия на правой панели), который эквивалентен диагонали векторного произведения между Df(x0) и x-x0.

Одна из технических трудностей состоит в том, чтобы найти корневую точку x0. Для непрерывных классификаторов мы можем использовать немаркированные тестовые данные или данные, создаваемые генеративной моделью, изученной на данных обучения в подходе дискретизации, и выполнить поиск линии между точкой х предсказания и набором точек-кандидатов {x'}, так что их предсказание имеет противоположный знак: f(x)f(x')<0. Ясно, что линия l(a)=ax+(1-a)x' должна содержать корень f, который может быть найден посредством интервального пересечения. Таким образом, каждая точка-кандидат x' дает один корень, и можно выбрать корневую точку, которая минимизирует остаток Тейлора или использует среднее значение по поднабору корневых точек с низкими остатками Тейлора.

Отметим, что декомпозиция тейлоровского типа, применяемая к одному слою или поднабору слоев, может рассматриваться как примерный способ распространения релевантности, когда функция сильно нелинейна. Это выполняется, в частности, при применении к выходной функции f в качестве функции предыдущего слоя f=f(zi-1), так как уравнение (18) удовлетворяет приблизительно уравнению (2) распространения, когда релевантность выходного слоя инициализируется как значение функции f(x) предсказания. В отличие от аппроксимации Тейлора, послойное распространение релевантности не требует использовать вторую точку, кроме входной точки. Формулы в разделе ʺПопиксельная декомпозиция для многослойных сетейʺ продемонстрируют, что послойное распространение релевантности может быть реализовано для широкого спектра архитектур без необходимости аппроксимировать с помощью разложения Тейлора.

Попиксельная декомпозиция для многослойных сетей

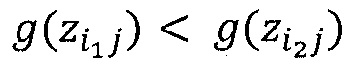

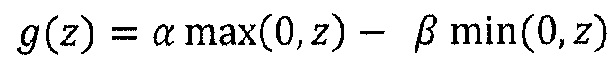

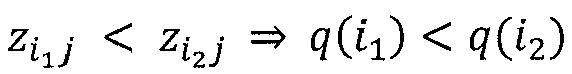

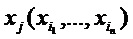

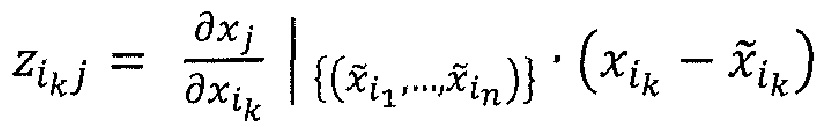

Многослойные сети обычно строятся как набор взаимосвязанных нейронов, организованных послойным способом. При объединении друг с другом они определяют математическую функцию, которая отображает нейроны первого слоя (вход) на нейроны последнего слоя (выход). Каждый нейрон обозначается посредством xi, где i - индекс для нейрона. По соглашению, ассоциируем разные индексы для каждого слоя сети. Обозначим суммирование по всем нейронам данного слоя через ʺΣiʺ и суммирование по всем нейронам другого слоя через ʺΣjʺ. Обозначим через x(d) нейроны, соответствующие активациям пикселов (т.е. с которыми желательно получить декомпозицию решения классификации). Общее отображение от одного слоя на другой состоит из линейной проекции, за которой следует нелинейная функция:

где wij - вес, соединяющий нейрон xi с нейроном xj, bj - член смещения, g - нелинейная функция активации (см. фиг. 8 для пояснения используемых обозначений). Многослойные сети складывают несколько из этих слоев, каждый из которых состоит из большого числа нейронов. Общими нелинейными функциями являются гиперболический тангенс g(t)=tanh(t) или функция выпрямления g(t)=max(0,t). Такая формулировка нейронной сети является достаточно общей, чтобы охватывать широкий спектр архитектур, таких как простой многослойный персептрон [39] или сверточные нейронные сети [25], когда свертка и объединение сумм являются линейными операциями.

Декомпозиция тейлоровского типа

Обозначая через f:RM→RN векторнозначную многомерную функцию, реализующую отображение между входом и выходом сети, первое возможное объяснение решения классификации x→f(x) может быть получено разложением Тейлора вблизи корневой точки x0 решающей функции f:

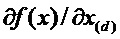

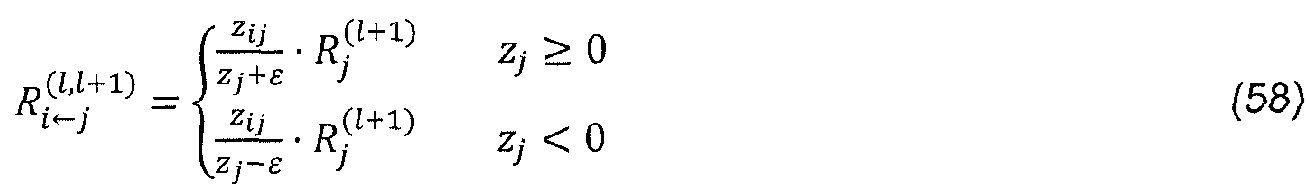

Производная  , необходимая для попиксельной декомпозиции, может быть эффективно вычислена путем повторного использования сетевой топологии с использованием алгоритма обратного распространения [39]. В частности, возвратив производные до некоторого слоя j, можно вычислить производную предыдущего слоя i, используя правило цепи:

, необходимая для попиксельной декомпозиции, может быть эффективно вычислена путем повторного использования сетевой топологии с использованием алгоритма обратного распространения [39]. В частности, возвратив производные до некоторого слоя j, можно вычислить производную предыдущего слоя i, используя правило цепи:

Требование декомпозиции на основе Тейлора состоит в том, чтобы найти корни x0 (т.е. точки на границе классификации), которые поддерживают локальное объяснение решения классификации для x. Эти корни можно найти путем локального поиска в окрестности точки x. Однако, как отмечено в [43], это может привести к точкам входного пространства, которые перцептивно эквивалентны исходной выборке x и выбор которых в качестве корня приведет к неинформативным попиксельным декомпозициям.

В качестве альтернативы, корневые точки могут быть найдены путем поиска линии на сегменте, определяемом посредством x и его ближайшим соседом другого класса. Это решение проблематично, когда множество данных является малонаселенным, как это имеет место для естественных изображений. В этом случае, вполне вероятно, что следование прямой линии между х и его ближайшим соседом будет сильно удаляться от множества данных и создавать корни x0 с одинаково плохими попиксельными декомпозициями.

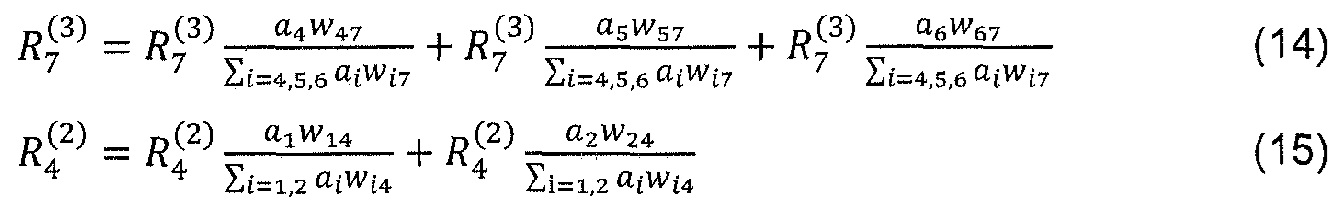

Послойное обратное распространение релевантности

В качестве альтернативы к декомпозиции тейлоровского типа, можно вычислить релевантности на каждом слое в обратном проходе, то есть выразить релевантности  как функцию релевантности выше расположенного слоя,

как функцию релевантности выше расположенного слоя,  , и обратно распространять релевантности до тех пор, пока не достигнем входа (пикселов).

, и обратно распространять релевантности до тех пор, пока не достигнем входа (пикселов).

Метод работает следующим образом: зная релевантность определенного нейрона  для решения f(x) классификации, желательно получить декомпозицию такой релевантности в терминах сообщений, отправленных к нейронам предыдущих слоев. Назовем их сообщениями

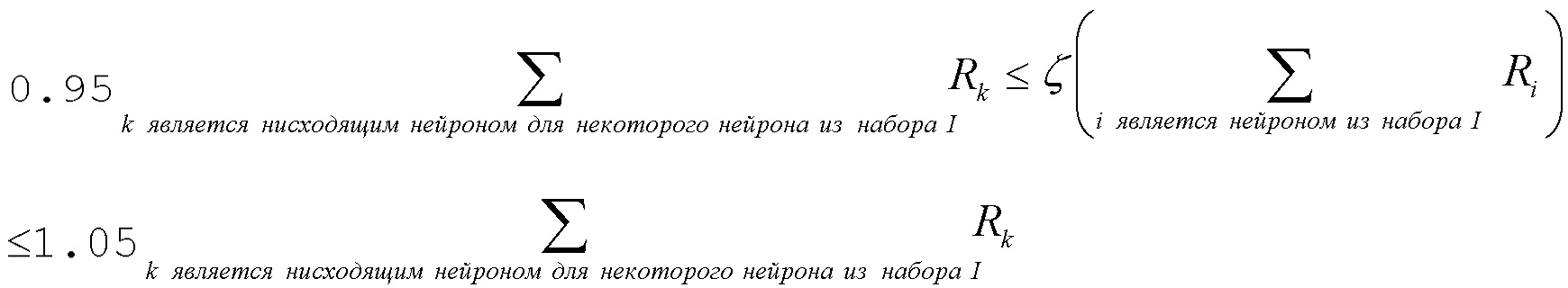

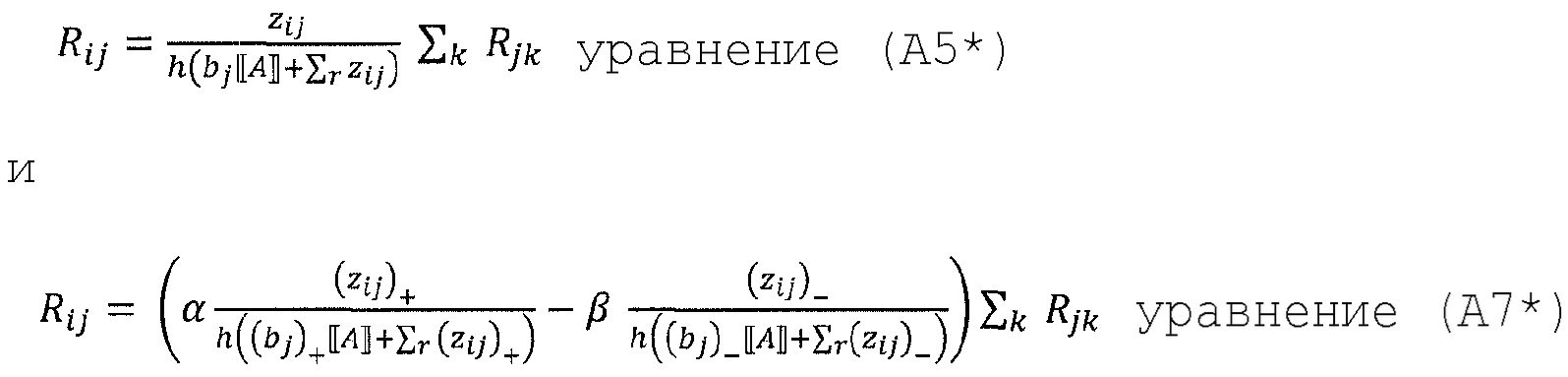

для решения f(x) классификации, желательно получить декомпозицию такой релевантности в терминах сообщений, отправленных к нейронам предыдущих слоев. Назовем их сообщениями  . В частности, как выражается уравнениями (8) и (13), должно поддерживаться свойство сохранения

. В частности, как выражается уравнениями (8) и (13), должно поддерживаться свойство сохранения

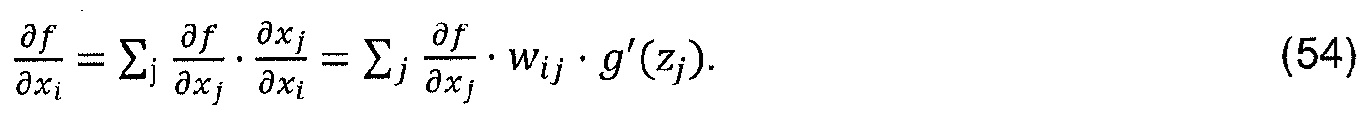

В случае линейного нейрона xj=Σizij, где релевантность Rj=f(x), такое разложение сразу задается через  =zij. Однако в общем случае активация xj нейрона является нелинейной функцией от zj. Тем не менее, для гиперболического тангенса и функции выпрямления, двух простых монотонно возрастающих функций, удовлетворяющих условию g(0)=0, предактивации zij все же обеспечивают разумный способ измерения относительного вклада каждого нейрона xi в Rj. Первый возможный вариант декомпозиции релевантности основан на отношении локальных и глобальных предактиваций и определяется следующим образом:

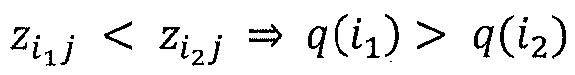

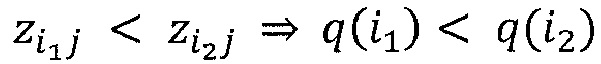

=zij. Однако в общем случае активация xj нейрона является нелинейной функцией от zj. Тем не менее, для гиперболического тангенса и функции выпрямления, двух простых монотонно возрастающих функций, удовлетворяющих условию g(0)=0, предактивации zij все же обеспечивают разумный способ измерения относительного вклада каждого нейрона xi в Rj. Первый возможный вариант декомпозиции релевантности основан на отношении локальных и глобальных предактиваций и определяется следующим образом:

Легко показать, что эти релевантности  аппроксимируют свойства сохранения уравнения (2), в частности:

аппроксимируют свойства сохранения уравнения (2), в частности:

где множитель учитывает релевантность, которая поглощается (или вводится) членом смещения. При необходимости, релевантность остаточного смещения может быть перераспределена на каждый нейрон xi.

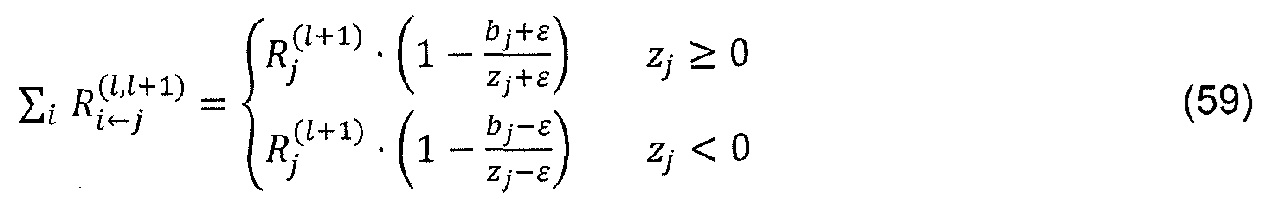

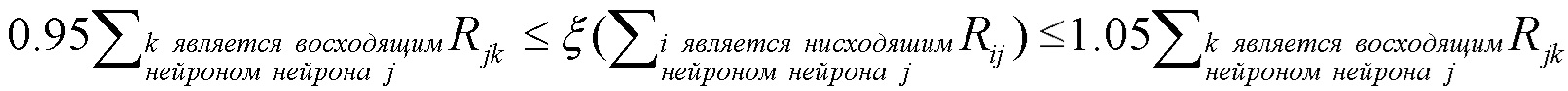

Недостатком правила распространения согласно уравнению (56) является то, что для малых значений zj, релевантности  могут принимать неограниченные значения. Неограниченность может быть преодолена путем введения предопределенного стабилизатора ε≥0:

могут принимать неограниченные значения. Неограниченность может быть преодолена путем введения предопределенного стабилизатора ε≥0:

Тогда закон сохранения становится

где можно заметить, что некоторая дополнительная релевантность поглощается стабилизатором. В частности, релевантность полностью поглощается, если стабилизатор ε становится очень большим.

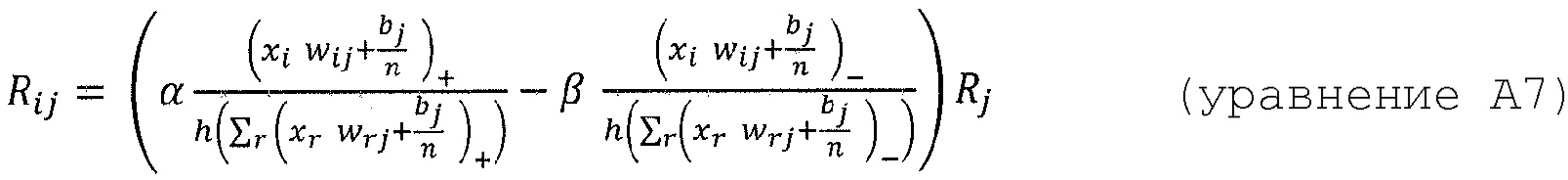

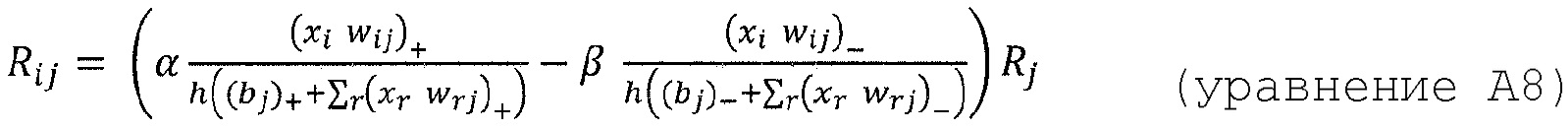

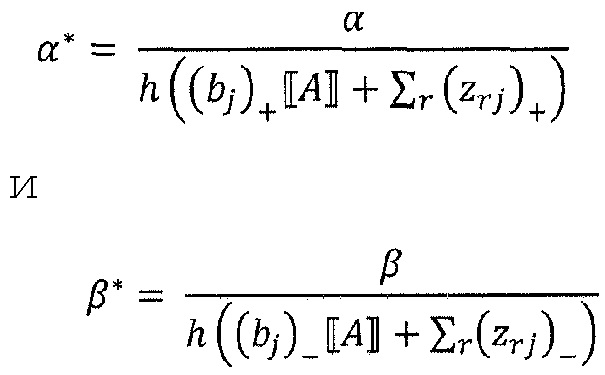

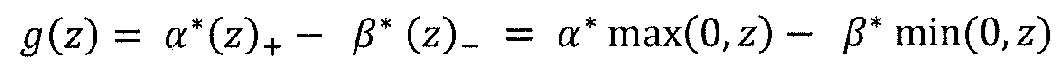

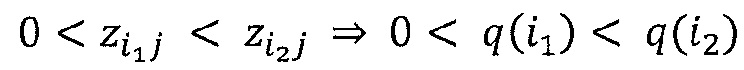

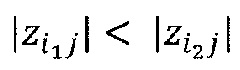

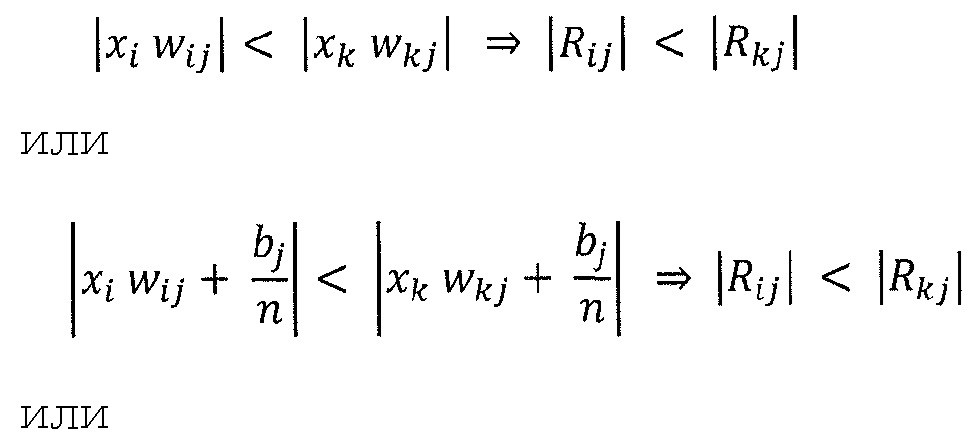

Альтернативный метод стабилизации, который не связан с утечкой релевантности, состоит в том, чтобы обрабатывать отрицательные и положительные предактивации отдельно. Допустим

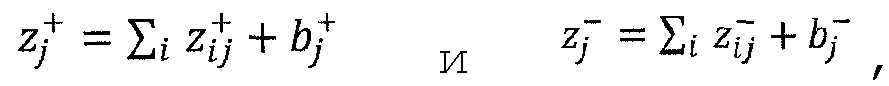

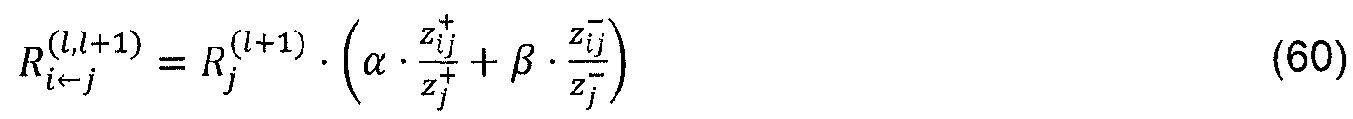

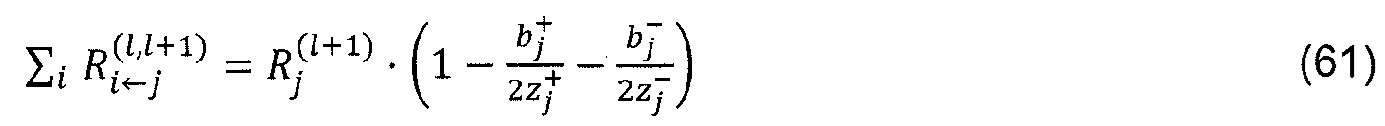

где ʺ-ʺ и ʺ+ʺ означают отрицательную и положительную часть zij и bj. Распространение релевантности определяется теперь как

где ʺ-ʺ и ʺ+ʺ означают отрицательную и положительную часть zij и bj. Распространение релевантности определяется теперь как

Где α>0, β<0, α+β=1. Например, при α=2, β=-1, закон сохранения принимает вид: